Установка AIC с использованием графического инсталлятора#

Общая информация#

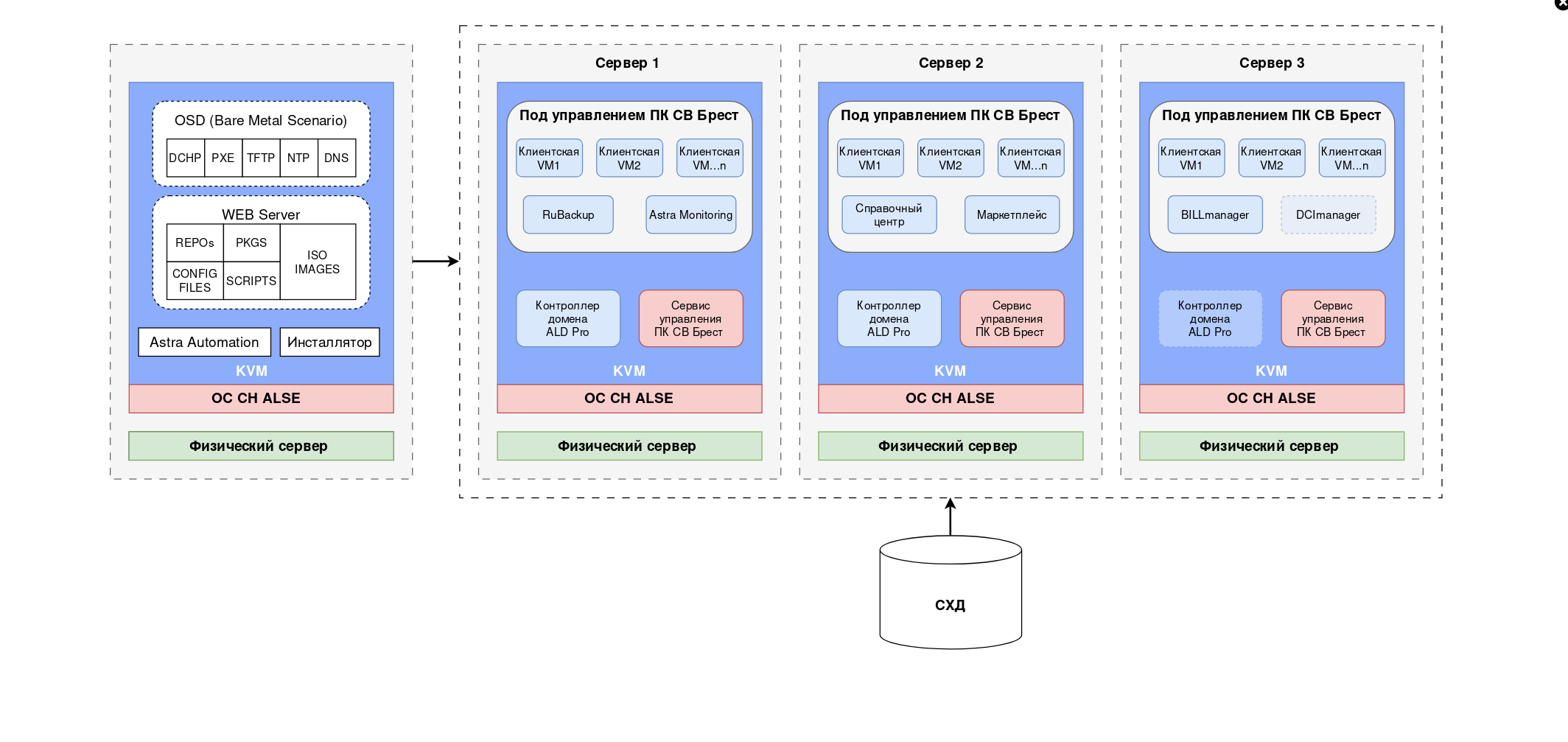

AIC это сложный программный комплекс состоящий из следующих компонентов:

Базовая ОС — ОС СН Astra Linux;

Подсистема виртуализации облачных ресурсов — ПК СВ «Брест»;

Подсистема контроллера домена — ALD Pro;

Подсистема резервного копирования — RuBackup;

Подсистема портала самообслуживания, тарификации и биллинга — BILLmanager;

Подсистема мониторинга — Astra Monitoring;

Подсистема автоматизации развертывания — Astra Automation;

Подсистема справочного центра — Help Center;

Подсистема магазина приложений — Market place;

Подсистема управления серверным оборудованием — DCImanager (опциональный компонент).

Графический инсталлятор AIC позволяет упростить и оптимизировать процесс развертывания всех компонентов комплекса, сократить время на их установку и уменьшить вероятность человеческой ошибки.

Версии продуктов и компонентов#

Версионность продуктов:

ПК СВ «Брест» — 3.3.3.UU1;

ALD Pro — 2.4.1;

RuBackup — 2.4;

Astra Monitoring — 0.7.1;

BILLmanager — 6.121 (редакция Hosting&Cloud for AIC);

DCImanager — 6;

ОС СН Astra Linux — SE 1.7.7, SE 1.7.6.UU2 (версия 1.7.7 используется для серверов управления и виртуализации ПК СВ «Брест», версия 1.7.6.UU2 для всех остальных серверов облачной платформы кроме DCImanager, для него используется версия ALSE 1.7.4.UU1).

Описание возможного сценария развертывания инфраструктуры#

Ключевые этапы развертывания инфраструктуры:

запуск виртуальной машины bootstrap сервера из Qcow2-образа;

загрузка ISO из личного кабинета в специальные директории на bootstrap сервере;

установка ОС на целевых серверах;

создание служебных виртуальных машин на целевых серверах;

подготовка и исполнение сценария установки основных компонентов, кроме СРК RuBackup (далее — Средство Резервного Копирования, СРК), Astra Monitoring, BILLmanager, DCImanager, Справочного центра, Market place;

подключение хранилищ iSCSI к ПК СВ «Брест» (далее — Подсистема виртуализации, Портал администратора);

развертывание ВМ со Средством резервного копирования, Astra Monitoring, BILLmanager, DCImanager, Справочного центра и Market place внутри Подсистемы виртуализации.

Минимальная инфраструктура состоит из трех целевых серверов виртуализации, на них же размещаются служебные виртуальные машины серверов управления и контроллера домена.

Схема расположения служб и виртуальных машин на целевых серверах базовой установки AIC:

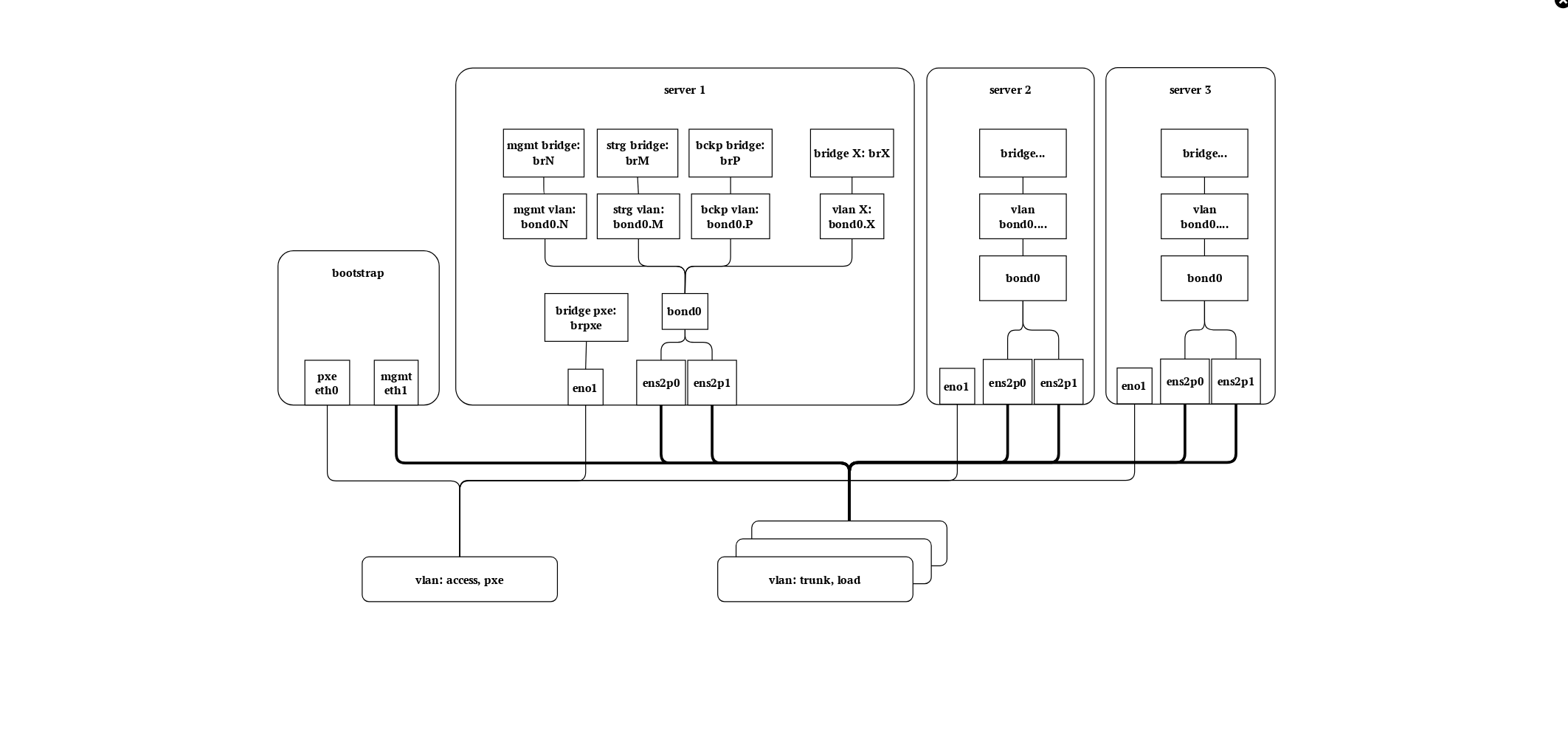

Сетевая топология#

Правильная настройка сетевых подключений является критической для успешной установки платформы и дальнейшей ее работы.

Рекомендуемая схема сетевого подключения:

Примечание

Данная схема является минимальной рабочей топологией. Она может быть расширена и дополнена, но не может быть упрощена.

Схема описывает сетевые соединения серверов виртуализации, топологию сетевых интерфейсов с точки зрения операционной системы, а также относительное расположение сервера bootstrap.

Для работы как Инсталлятора, так и самой платформы AIC требуются следующие сети:

Management, которая используется во время установки платформы;

Storage, которая соединяет серверы виртуализации с СХД (iSCSI);

Backup для резервного копирования.

Сеть PXE должна быть нетегируемой (access), остальные, учитывая ожидаемую топологию, — тегируемые (trunk).

Предупреждение

Необходимо выделять отдельный физический канал для целей сетевой установки ОС (PXE). Выделение отдельного физического канала для резервного копирования (Backup) допускается и рекомендуется, но не является обязательным.

Примечание

Для именования сетевых интерфейсов применяется один из двух методов:

Традиционный метод: система назначает имя

ethXв момент инициализации интерфейса (определяется в параметрах загрузки:net.ifnames=0).Механизм

predictable namesназначает имя видаeno1илиens1p0, в соответствии с расположением устройства в древе PCI.

В целях обеспечения отказоустойчивости сетевого подключения, производится агрегация сетевых интерфейсов в соединения типа bond. В связи с тем, что инициализация оборудования выполняется асинхронно, при использовании традиционного метода именования интерфейсов, в процессе загрузки сервера, имена портов могут изменяться (например, порт eth1 сменит название на eth0), что может привести к некорректной агрегации сетевых интерфейсов.

Механизм predictable names позволяет избежать данной проблемы, т.к., при его использовании, устройства получают одни и те же имена, в зависимости от расположения в древе PCI.

Однако, в зависимости от установленного оборудования, традиционное именование может оказаться более удобным в процессах эксплуатации и документирования кластера.

Для сохранения традиционного метода наименования и закрепления за сетевыми интерфейсами стабильных имен, может быть прописано правило udev.

Добавление правила udev и включение традиционного именования интерфейсов не является строго обязательным и выполняется на усмотрение администратора.

В процессе автоматической установки ОС из параметров загрузки убирается параметр net.ifnames=0, что включает механизм predictable names. Для его отключения следует:

На уже установленной ОС вернуть параметр

net.ifnames=0, отредактировав в файле/etc/default/grubстрокуGRUB_CMDLINE_LINUX_DEFAULT:#GRUB_CMDLINE_LINUX_DEFAULT="<param> net.ifnames=0 <param>"

Обновить

grub.cfgкомандой:update-grub

Привязать соответствующие имена к MAC-адресам интерфейсов в новом правиле

udev:# /etc/udev/rules.d/10-network-names.rules SUBSYSTEM=="net", ACTION=="add", ATTR{address}=="aa:bb:cc:dd:ee:11", NAME="eth0" SUBSYSTEM=="net", ACTION=="add", ATTR{address}=="aa:bb:cc:dd:ee:22", NAME="eth1" SUBSYSTEM=="net", ACTION=="add", ATTR{address}=="aa:bb:cc:dd:ee:33", NAME="eth2"

Поставить

systemdзапрет на переписывание переименованных интерфейсов, выполнив команду:sudo ln -s /dev/null /etc/systemd/network/99-default.link

Отредактировать файл

/etc/network/interfaces, заменив или добавив туда новые именования:auto enp1s0f0 iface enp1s0f0 inet manual auto enp1s0f1 iface enp1s0f1 inet manual auto bond0 iface bond0 inet manual ... auto eth1 iface eth1 inet manual auto eth2 iface eth2 inet manual auto bond0 iface bond0 inet manual ...

Удалять или комментировать старые имена до следующей загрузки не требуется. При возникновении проблем, сервер применит сетевые настройки с ранее заданными именами.

На серверах виртуализации каждый VLAN подключается к сетевому мосту с соответствующим названием, указывающим на VLAN ID или роль, которую выполняет мост. Создание сетевых мостов на виртуальной машине bootstrap не целесообразно.

Требования к подготовке программно-аппаратного окружения#

Примечание

Требования к программно-аппаратным ресурсам и конфигурации сети для развертывания сценария представлены в разделе Системные требования.

Дополнительные требования к подготовке программно-аппаратного окружения:

Для корректной автоматизации развертывания AIC требуется предварительно настроить следующие VLAN:

Должна быть возможность использовать одинаковые последние октеты IP-адресов для всех серверов AIC во всех сетях. То есть для каждой локальной ВМ и ВМ под управлением ПК СВ должна быть возможность задать одинаковый последний октет для всех сетей.

Пример:

Для развертывания AIC выделено три сети:

В случае если в графическом инсталляторе или в файле с переменными для первого сервера управления ПК СВ будет задан адрес:

192.168.22.150, то, во время создания самой ВМ, ей будут добавлены все три сети и назначены адреса:192.168.22.150,10.22.22.150,10.205.17.150.В случае использовании iSCSI, для доступа к СХД, должны быть настроены два LUN, которые предоставляются через сеть, выделенную под трафик СХД. Эти два LUN будут использованы как СХД ПК СВ. Логические и физические размеры секторов на LUN должны совпадать, в ином случае использование LUN как хранилища для ПК СВ типа BREST_LVM нельзя. Если возможности изменить размеры секторов нет, автоматизация установки AIC предоставляет код для подключения хранилищ типа LVM_LVM.

Минимальный размер iSCSI LUN или OSD-дисков, который будет использоваться для хранилища данных ПК СВ — 150 ГБ в случае iSCSI LUN, или 335 ГБ в случае OSD-диска Ceph. В случае развертывания DCImanager, минимальный размер — 200 ГБ в случае iSCSI LUN, или 550 ГБ в случае OSD-дисков Ceph. DCImanager является необязательным компонентом AIC, и требует отдельного лицензирования. Такие размеры хранилища являются минимальными для возможности установки, в процессе эксплуатации количество занимаемого пространства будет увеличиваться. Минимальный размер iSCSI LUN или OSD диска, который будет использоваться для хранилища образов ПК СВ — 50 ГБ в случае iSCSI LUN, или 100 ГБ в случае OSD-диска Ceph.

Серверов ALD Pro может быть как два, так и три. Создание третьего сервера КД будет выполнено только в случае указания определенной переменной.

Установочный сервер AIC (bootstrap сервер) и три основных сервера виртуализации ПК СВ должны быть размещены в едином сегменте сети (без промежуточных маршрутизаторов), обеспечивая коммутацию трафика на уровне L2.

Пререквизиты для установки#

Для установки необходим выделенный сервер или рабочая станция с установленной ОС СН Astra Linux версии не ниже 1.7.4 с графическим интерфейсом (GUI), уровень защищенности не важен. Рекомендуется использовать ALSE 1.7.4 без оперативных обновлений. На эту рабочую станцию будет установлен bootstrap.

Установка платформы производится с bootstrap сервера, который поставляется в виде образа виртуальной машины, включающий в себя необходимые сценарии развертывания, конфигурационные файлы и репозитории пакетов.

Предполагается, что bootstrap сервер будет запущен в виде отдельной виртуальной машины на целевом сервере, или рабочей станции, имеющей выход в целевой VLAN (broadcast домен). Установочный образ поставляется в виде Qcow2-файла, который необходимо скачать из личного кабинета.

Примечание

Для создания ВМ из скаченного файла, его необходимо расположить в директории, в которой хранятся образы libvirt (директория по умолчанию

/var/lib/libvirt/images), поменять права файла наroot:libvirt-qemu.Поменять права можно выполнив команду:

sudo chown root:libvirt-qemu /var/lib/libvirt/images/<bootstrap_image_name>.qcow2

Далее в приложении Менеджер виртуальных машин создать новую ВМ, выбрав при ее создании пункт меню Импорт образа диска. Указав установочный Qcow2-образ, как Выбор тома. В поле Выберите операционную систему для установки указать Debian 10.

Установочный образ содержит:

ОС Astra Linux Special Edition (далее — ALSE) версии 1.7.6 с оперативным обновлением UU2, уровень защищенности «Орел»;

Графический инсталлятор AIC;

необходимые для развертывания AIC приложения и директории.

В зависимости от сетевой топологии следует поменять настройки виртуальных сетевых интерфейсов, так как один используется для сетевой установки ОС на целевые серверы, а другой — для соединения к виртуальным машинам и целевым серверам.

Минимальные требования к ВМ сервера bootstrap:

vCPU: 4 ядра;

RAM: 4 ГБ;

HDD: от 150 ГБ;

2 адаптера Ethernet (в ВМ bootstrap сервера должно быть настроено 2 подсети: подсеть для PXE, подсеть для управляющей сети — менеджмент, по которой bootstrap сервер будет разворачивать AIC на всех серверах).

Примечание

Имя пользователя и пароль bootstrap сервера по умолчанию

astra/astra.К целевым серверам, которые будут являться клиентами PXE, должен быть добавлен сетевой интерфейс, подключенный к выделенному для PXE VLAN. Порты этого VLAN предпочтительно подключать в режиме

access. Рекомендуемая пропускная способность портов — не менее 1 Гбит/с.Предупреждение

Нежелательно наличие работающих DHCP-серверов в этой сети, чтобы избежать сетевых проблем в ходе установки.

Во время установки AIC посредством инсталлятора производится автоматическое заполнение 2-х конфигурационных файлов:

файл с переменными —

/home/astra/aic-code/ansible/playbooks/group_vars/all.yml;файл с адресацией всех серверов —

/home/astra/aic-code/inventory.yml(далее — файл-инвентарь).

В файле-инвентаре отображается структура с перечислением имен групп и серверов, которые находятся в этих группах.

Пример трех групп серверов для ALD Pro:

aldpro_server: hosts: dc1-test: aldpro_replica: hosts: dc2-test: aldpro_clients: children: aldpro_replica: brest_kvm_nodes: brest_fronts:

В этом примере есть три группы серверов, их имена —

aldpro_server,aldpro_replicaиaldpro_clients. В группуaldpro_serverвходит сервер с именемdc1-test, в группуaldpro_replicaвходит сервер с именемdc2-test. В группуaldpro_clientsвходят не серверы, а группы серверов, такие какaldpro_replica,brest_kvm_nodes,brest_fronts.AIC 1.3.1 использует для развертывания сертифицированные ФСТЭК ISO-образы для каждого компонента AIC. На bootstrap сервере в домашней директории пользователя

astraтребуется организовать структуру папок. Для этого необходимо создать директорию с именемiso, полный путь до этой директории:/home/astra/iso. В ней создать следующие директории:aldpro_iso,alse_iso,billmanager_iso,brest_iso,rubackup_iso. Для этого выполнить команду:mkdir -p /home/astra/iso/aldpro_iso /home/astra/iso/alse_iso /home/astra/iso/billmanager_iso /home/astra/iso/brest_iso /home/astra/iso/dci_manager_iso /home/astra/iso/rubackup_iso

После выполнения команды необходимо загрузить из личного кабинета Группы Астра на bootstrap сервер ISO-образ и файл с хэш-суммой каждого компонента AIC, — ALD Pro, ALSE, BILLmanager, ПК СВ «Брест», RuBackup. Разместить их следует в соответствующих директориях.

Предупреждение

Файлы должны иметь указанные имена, рядом с каждым ISO (кроме ISO для RuBackup, DCImanager и BILLmanager) должен быть расположен файл с его хэш-суммой. ISO-образ для BILLmanager и файл с его md5 суммой изначально размещены на bootstrap сервере в нужной директории.

В личном кабинете каждый образ имеет свое уникальное имя, включающее в себя версию продукта. При скачивании файлов из личного кабинета необходимо выбирать корректные версии файлов и сохранять их строго под теми же именами. Переименование файлов не допускается.

Пример структуры каталогов и файлов внутри директории /home/astra/iso:

/home/astra/iso/ ├── aldpro_iso │ ├── ALD_Pro_2.4.1.gost │ └── ALD_Pro_2.4.1.iso ├── alse_iso │ ├── base-1.7.4.11-23.06.23_17.13.iso │ ├── base-1.7.4.11-23.06.23_17.13.iso.gost │ ├── installation-1.7.6.15-15.11.24_17.20.iso │ ├── installation-1.7.6.15-15.11.24_17.20.iso.gost │ ├── installation-1.7.7.6-10.03.25_13.44.iso │ └── installation-1.7.7.6-10.03.25_13.44.iso.gost ├── billmanager_iso │ ├── billmgr.aic.iso │ └── billmgr.aic.iso_md5sum.txt ├── brest_iso │ ├── brest-3.3.3.uu1-for-astra-1.7.7.iso │ └── brest-3.3.3.uu1-for-astra-1.7.7.iso.gost ├── dci_manager_iso │ ├── dci6_repo.iso │ └── dci_latest.iso └── rubackup_iso └── rubackup-release_2.4.0.42_astra-1.7.iso

Примечание

DCImanager является необязательным компонентом AIC. В случае его установки, — скачать нужные для него ISO (

dci_latest.isoиdci6_repo.iso) можно на странице официальной документации ispsystem. Репозиторий для ALSE 1.7.4.UU1 (base-1.7.4.11-23.06.23_17.13.iso) необходим только для DCImanager. Если в инсталляции AIC не планируется установка DCImanager — этот репозиторий и файл с его хэш-суммой не требуются.Перед верификацией ISO необходимо в файле по пути

/home/astra/aic-code/ansible/playbooks/group_vars/all.ymlпоменять значение следующей переменной:dci_install: trueЗначение true нужно указывать только в случае, если в инсталляции AIC планируется устанавливать DCImanager. В ином случае у переменной должно быть значение false. Этот параметр отвечает за необходимость верификации базового репозитория ALSE 1.7.4 с оперативным обновлением UU1, а также за дальнейшее монтирование этого ISO как репозитория на bootstrap сервер.

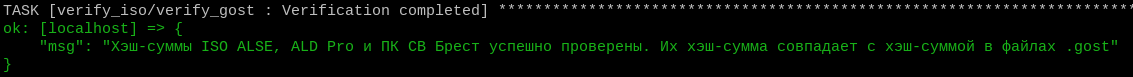

После подготовки структуры репозиториев ISO-образов необходимо проверить целостность этих образов (хэш-суммы и корректность загруженных ISO). Для этого на bootstrap сервере перейти в директорию

/home/astra/aic-codeи выполнить команду:task iso_verifyЭта команда запустит автоматизацию проверки валидности скаченных ISO. Автоматизация проверит корректность расположения ISO в соответствующих директориях и соответствие хэш-сумм этих ISO с хэш-суммами, указанными в файлах

.iso.gost.Пример вывода после успешного выполнения автоматизации:

В случае обнаружения ошибок в структуре ISO-репозитория или нарушения целостности ISO-образа компонентов AIC (отсутствия какого-либо ISO или несовпадения хэш-сумм), на экран будет выведено сообщение об ошибке. Перед продолжением установки необходимо устранить данную ошибку.

Подготовка целевых серверов к установке ОС.

Перед запуском процесса сетевой установки ОС необходимо подготовить оборудование для развертывания комплекса. Для этого:

Найти и выписать MAC-адреса сетевых интерфейсов трех целевых серверов (будет использовано в переменных Инсталлятора).

Настроить RAID-массив: тома должны быть сконфигурированы заранее и иметь от 200 до 500 ГБ свободного пространства.

Определить название целевого накопителя. (Как правило, это

/dev/sda, для установки с использованием RAID-контроллера).Настроить UEFI целевых серверов, включив поддержку виртуализации (например,

Intel vDT-x).Сконфигурировать UEFI целевых серверов таким образом, чтобы в ней присутствовала возможность загрузки по сети. Рекомендуется сетевой интерфейс устанавливать вторым по счету непосредственно после загрузки целевого накопителя. В случае переустановки ранее развернутого сервера, необходимо вручную выбрать вариант загрузки по сети, открыв меню загрузки соответствующей комбинацией клавиш.

Примечание

При установке по сети рекомендуется использовать режим загрузки UEFI, по возможности избегая DUAL и Legacy BIOS. Если firmware сервера и сетевой карты предоставляет выбор между загрузкой по PXE или iPXE — необходимо использовать PXE.

Предупреждение

Все серверы, на которые предполагается установка AIC, должны быть настроены на поддержку загрузки по сети. Во время установки потребуется перезагрузка серверов.

Ранее установленные операционные системы и данные на этих серверах будут уничтожены.

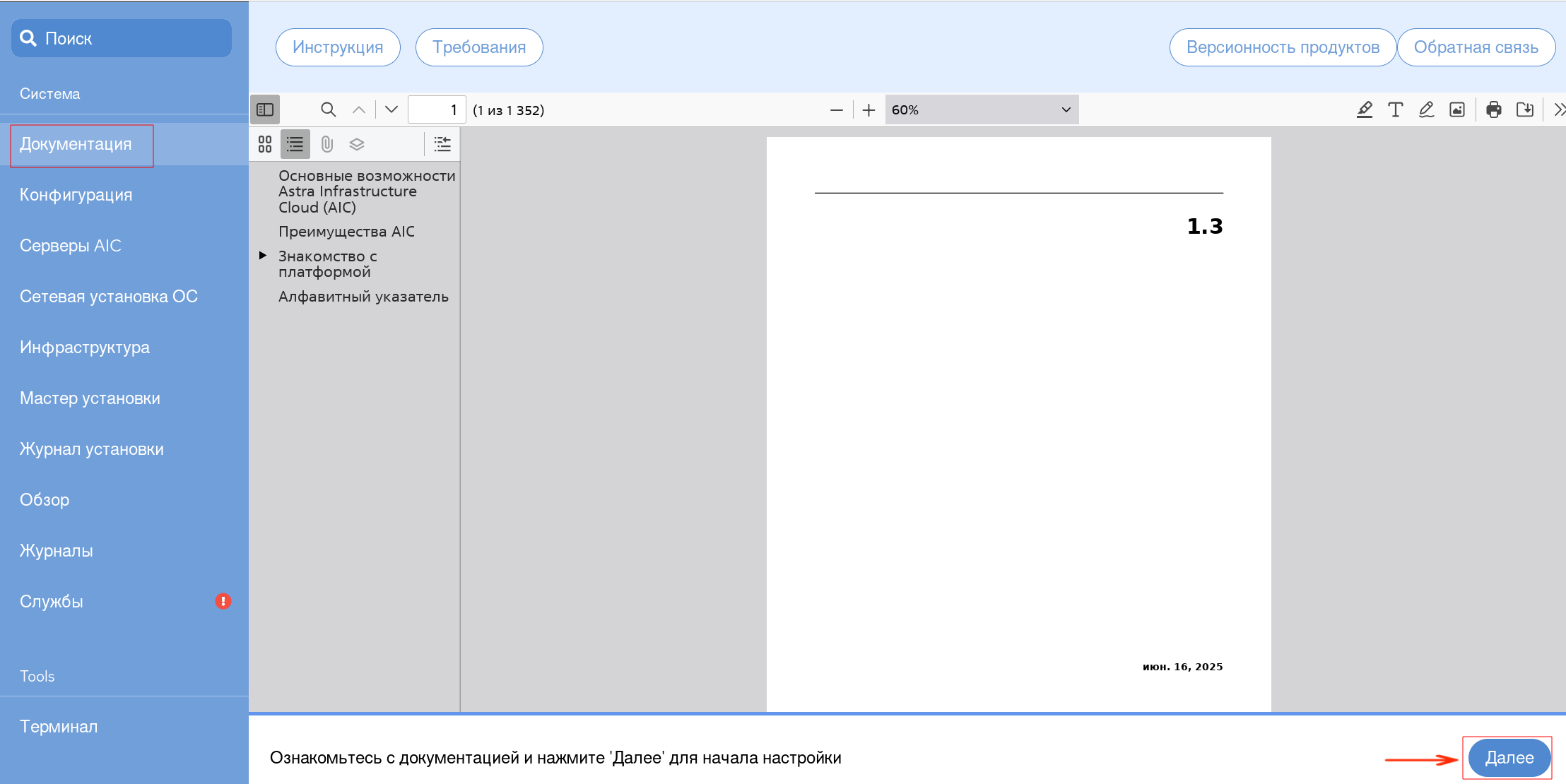

Ознакомление с документацией#

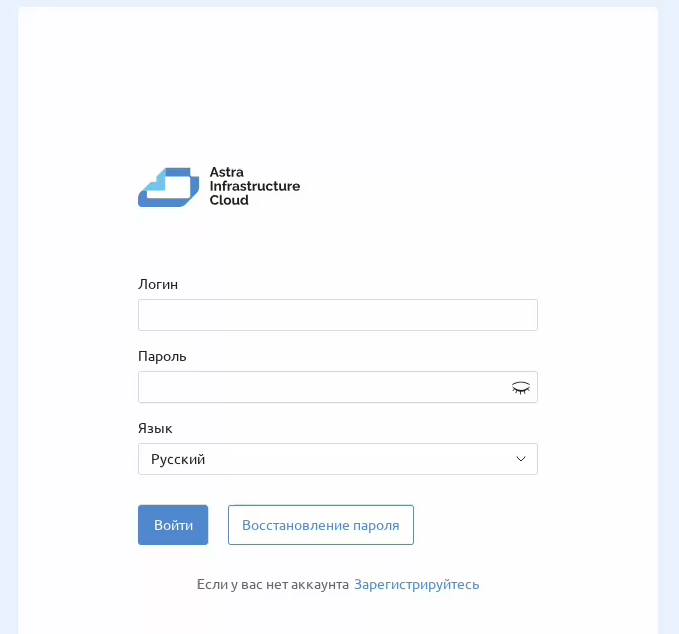

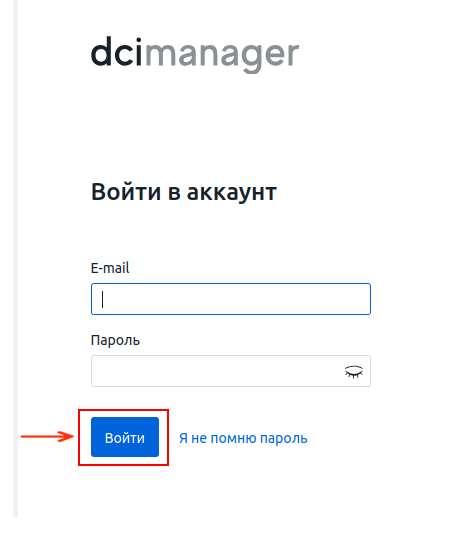

После выполнения предварительной подготовки необходимо перейти в графический интерфейс Инсталлятора AIC по адресу: https://<IP_bootstrap_srv> и авторизоваться.

Примечание

Логин и Пароль для входа по умолчанию: astra/astra.

Инсталлятор автоматически откроется на страница с документацией (вкладка основного меню слева Документация). После ознакомления с документацией следует в нижней правой части экрана нажать на кнопку Далее:

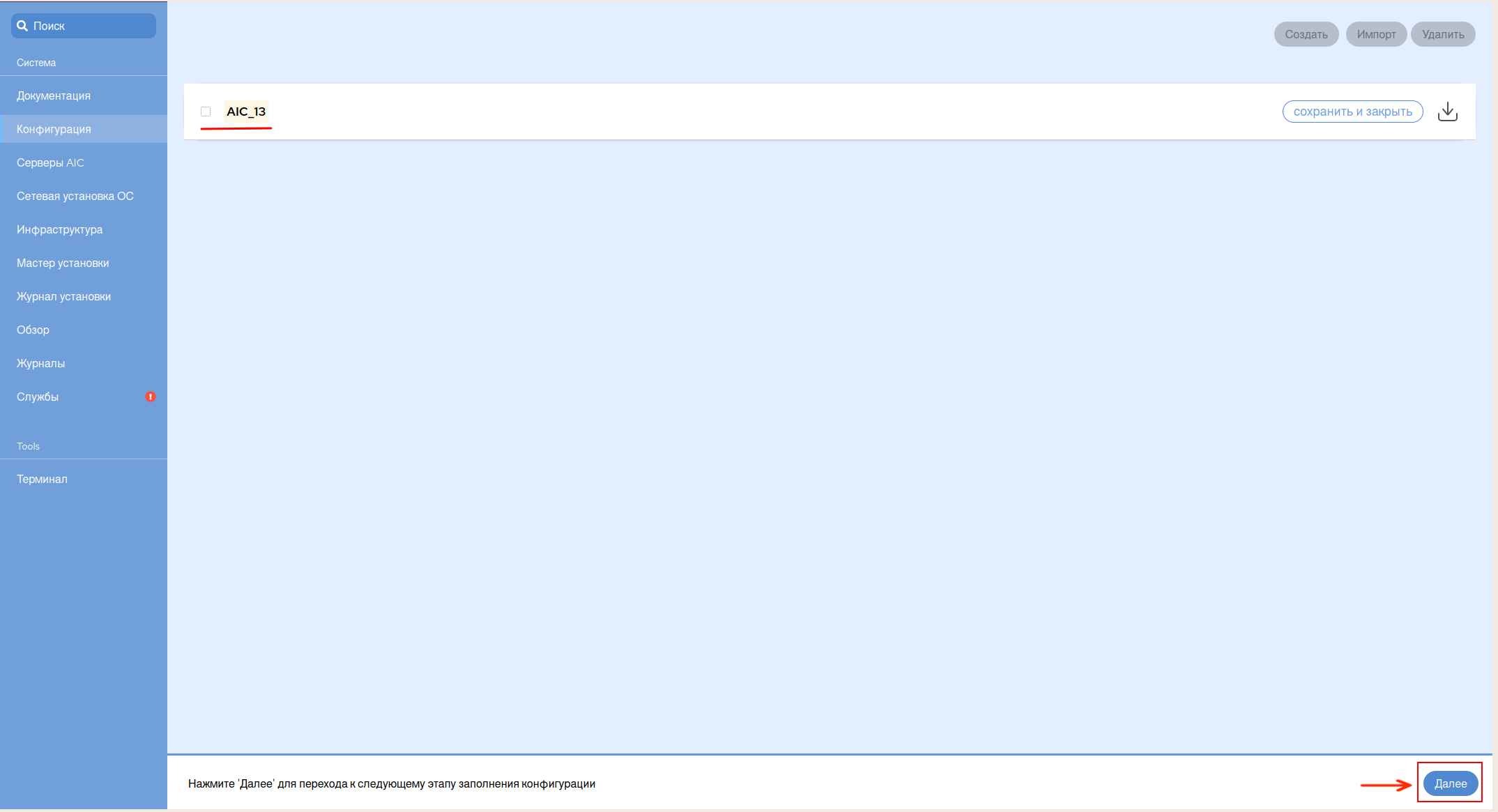

Данное действие приведет к открытию окна вкладки Конфигурация.

Подготовка конфигурации#

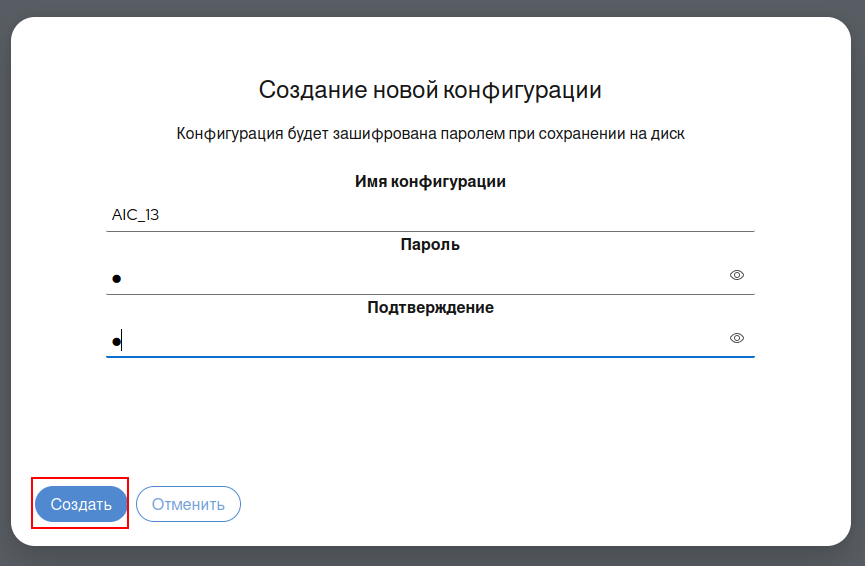

Для создания новой конфигурации в открывшемся окне вкладки Конфигурация:

Нажать на кнопку Создать в правой верхней части экрана:

В открывшемся окне Создание новой конфигурации задать имя и пароль новой конфигурации, нажать на кнопку Создать:

Новая конфигурация появится в списке доступных конфигураций.

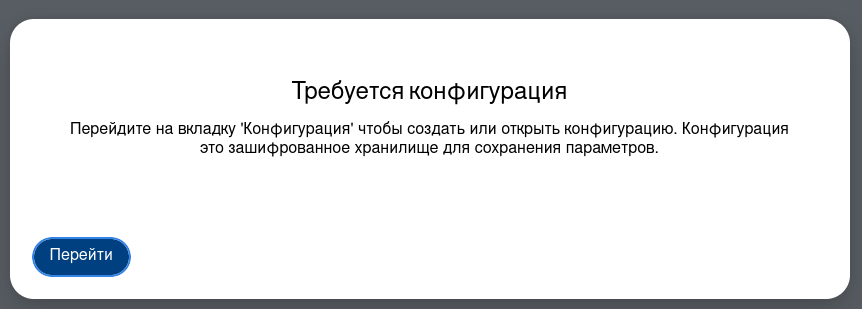

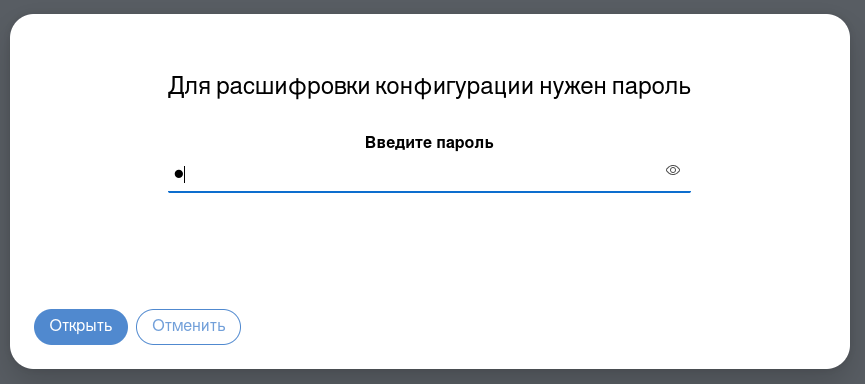

Примечание

При длительном бездействии Пользователя и/или перезагрузке сервера Bootstrap, а также в некоторых других случаях, конфигурация может заблокироваться. В таком случае, на экран будет выведено сообщение следующего содержания:

Для расшифровки конфигурации необходимо перейти во вкладку Конфигурация основного меню слева, выбрать из списка одну из ранее созданных конфигураций и в открывшемся окне ввести пароль, заданный на этапе создания данной Конфигурации. Нажать на кнопку Открыть:

Для перехода к настройке серверов AIC и Сетевой установке, нажать на кнопку Далее в правой нижней части экрана:

Предупреждение

Далее для установки платформы потребуется заполнить ряд переменных. В случае введения в любое из полей невалидного значения, в нижней левой части экрана появится сообщение об ошибке:

Необходимо устранить все ошибки заполнения до начала установки, так как Инсталлятор запустит процесс в любом случае, однако, при введении невалидных значений, установка выполнена не будет.

Для удобства Пользователя, подсказки о сути переменных и/или требованиях к их заполнению, отображаются на экране при наведении курсора на поле каждой из переменных.

Серверы AIC и Сетевая установка ОС#

На этапах Серверы AIC и Сетевая установка ОС будут заданы параметры для установки Операционной системы и ее последующего конфигурирования.

Примечание

Минимальный необходимый к заполнению набор параметров на этапах Серверы АИК и Сетевая установка ОС:

название сетевого интерфейса DHCP;

MAC-адреса целевых серверов. MAC-адрес — адрес сетевого интерфейса на соответствующем целевом сервере, где происходит установка;

имена целевых серверов;

oбъем корневого раздела

root, на котором будет установлена ОС.

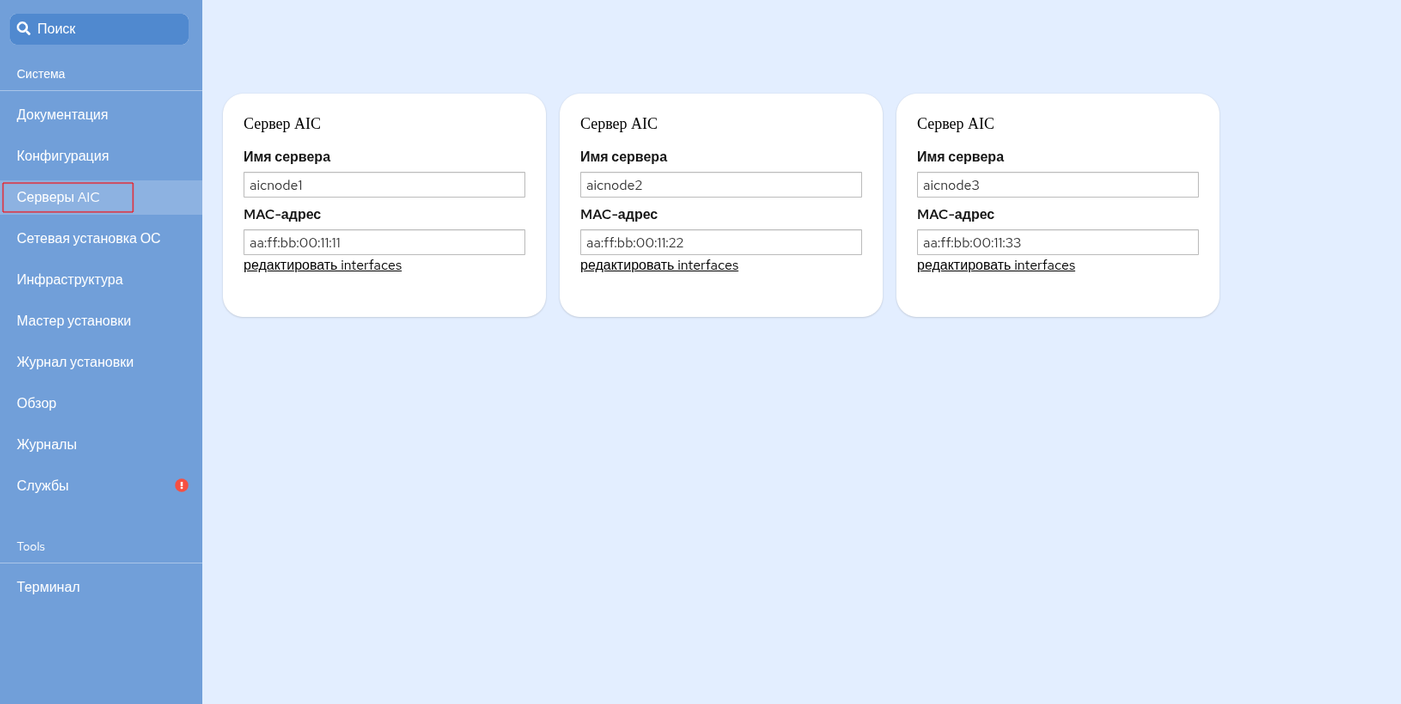

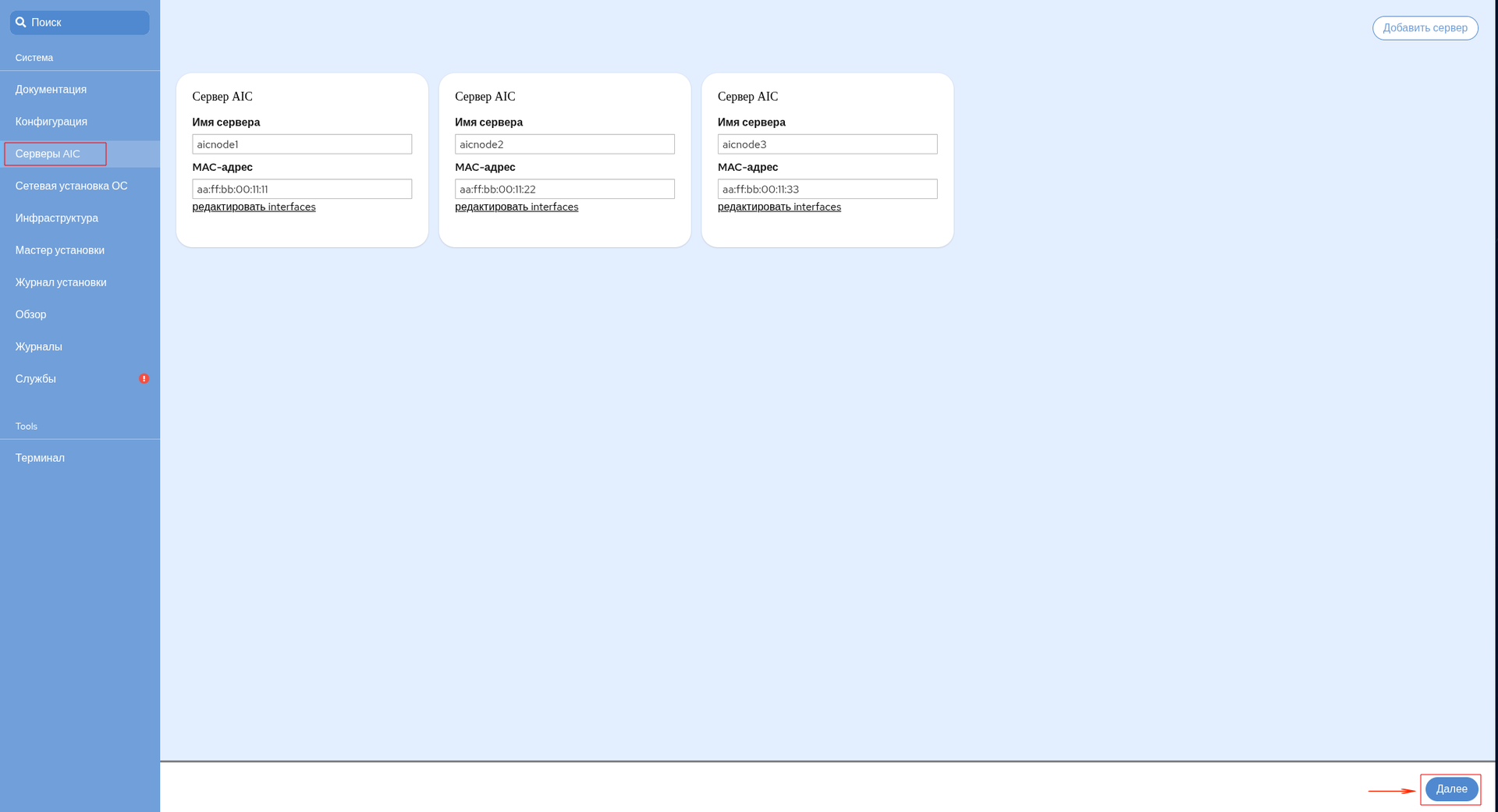

Серверы AIC#

В открывшемся окне вкладки Серверы AIC:

Обозначить серверы виртуализации AIC, для этого:

В поле Имя сервера каждого из трех блоков Сервер AIC указать имена для трех целевых серверов, которые будут заданы в процессе установки ОС.

Примечание

Имена серверов, заданные на данном этапе, должны быть использованы позднее для наименования KVM-серверов на этапе Инфраструктура. В случае несоблюдения данного условия возможны ошибки в отработке автоматизации процесса развертывания AIC.

В поле MAC-адрес каждого из трех блоков Сервер AIC указать, полученные на этапе подготовки к развертыванию (Пререквизиты для установки), MAС-адреса сетевых интерфейсов целевых серверов, имеющих выход в выделенную сеть, через которую будет производиться сетевая установка.

Предупреждение

Конфигурации целевых серверов должны совпадать по именам устройств накопителей (/dev/sdX), куда устанавливается операционная система, по объему этих накопителей (допустим объем, превышающий тот, что будет указан в переменной размера корневой файловой системы) и по имени устройства сетевого интерфейса PXE.

Примечание

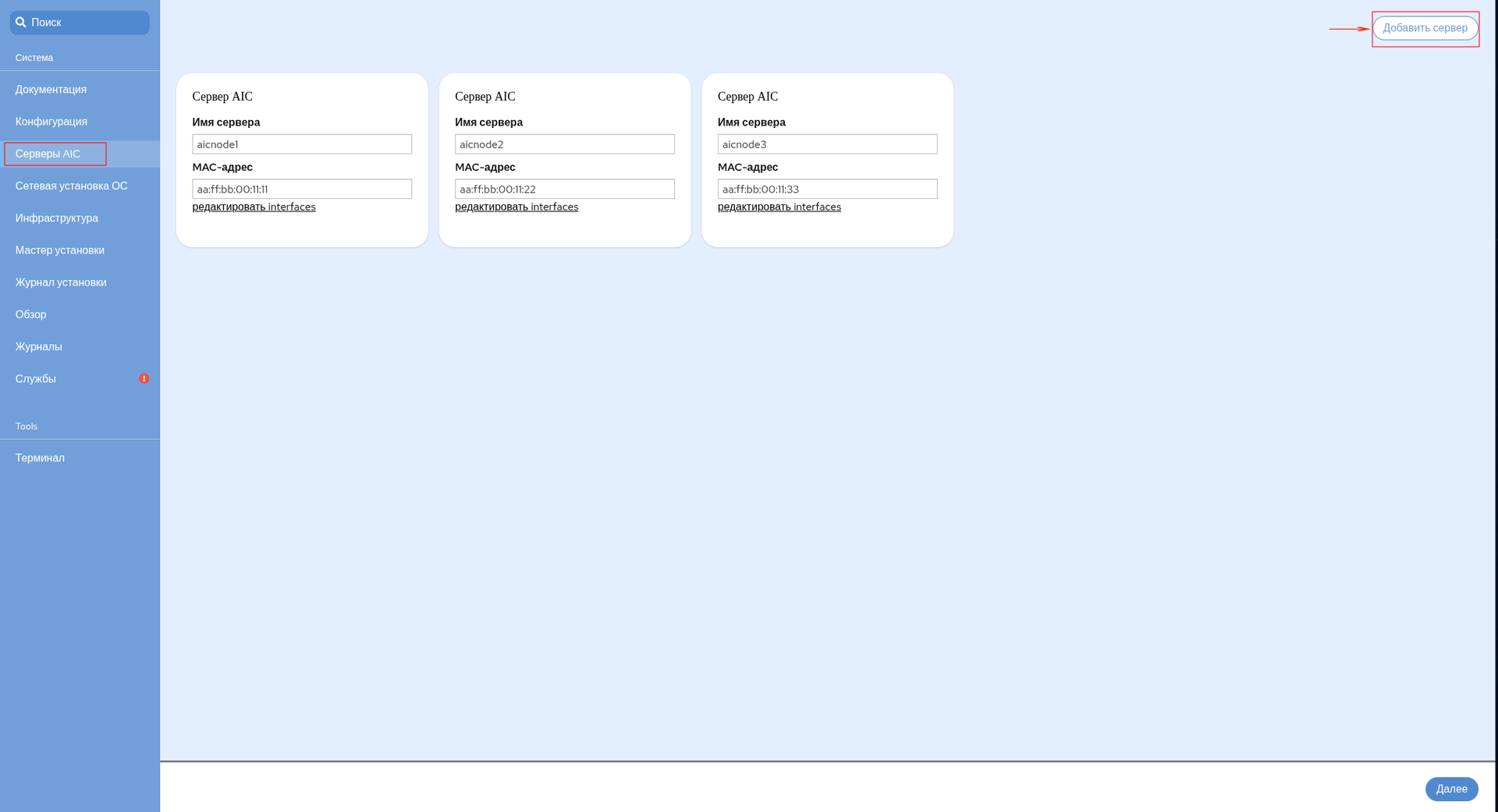

Для корректного развертывания AIC необходимо использовать минимум три целевых сервера. Максимальное количество добавляемых серверов — 10. Добавление серверов производится кнопкой Добавить в правой верхней части окна Серверы ОС:

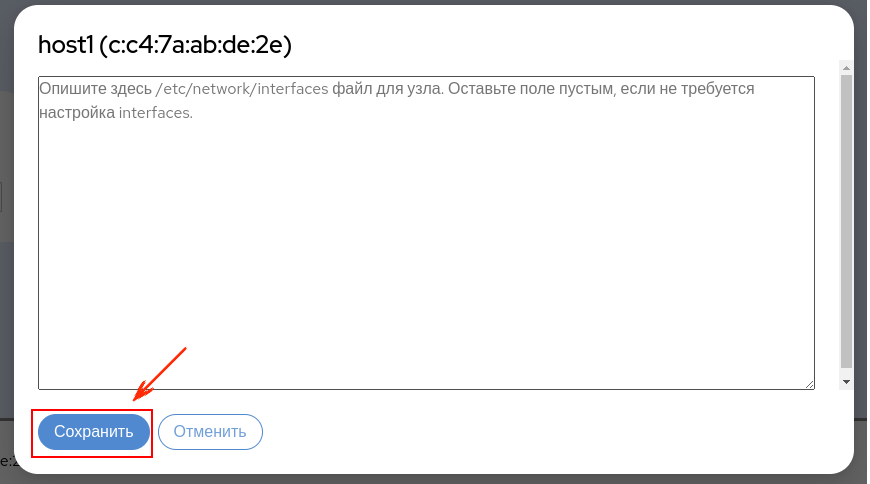

Для выполнения автоматизированной настройки сети на развертываемых серверах, после указания MAC-адреса сервера можно нажать на кнопку Редактировать Interfaces и в открывшемся окне ввести соответствующую конфигурацию сетевых интерфейсов. Для сохранения конфигурации нажать на кнопку Сохранить:

Пример файла конфигурации Interfaces:

source /etc/network/interfaces.d/*

# --- networks in use:

# vlan 200 - management : 192.168.22.0/24

# vlan 170 - iSCSI : 10.205.17.0/24

# vlan 169 - backup : 10.22.222.0/24

# -------------------------------------------------------------

auto lo

iface lo inet loopback

# bond0 lacp

auto eno1

iface eno1 inet manual

auto eno2

iface eno2 inet manual

auto bond0

iface bond0 inet manual

mtu 9000

bond-slaves eno1 eno2

bond-mode 802.3ad

bond-miimon 100

bond-lacp-rate fast

bond-xmit-hash-policy layer3+4

bond-updelay 200

bond-downdelay 200

# -------------------------------------------------------------

# vlan 200 - mgmt

auto bond0.200

iface bond0.200 inet manual

vlan-raw-device bond0

auto br200

iface br200 inet static

mtu 9000

address 192.168.22.74/24

# address 192.168.22.75/24

# address 192.168.22.76/24

bridge_ports bond0.200

bridge_stp on

# -------------------------------------------------------------

# vlan 170 - iSCSI

auto bond0.170

iface bond0.170 inet manual

vlan-raw-device bond0

auto br170

iface br170 inet static

mtu 9000

address 10.205.17.14/24

# address 10.205.17.15/24

# address 10.205.17.16/24

bridge_ports bond0.170

bridge_stp on

# -------------------------------------------------------------

# vlan 169 - backup

auto bond0.169

iface bond0.169 inet manual

vlan-raw-device bond0

auto br169

iface br169 inet static

address 10.22.22.14/24

# address 10.22.22.15/24

# address 10.22.22.16/24

bridge_ports bond0.169

bridge_stp on

если не заполнить данные значения, пост-скрипт сгенерирует настройки, исходя из интерфейса, активного на момент установки, прописывая получение адреса по DHCP. Таким образом Администратору предоставляется сетевой доступ не только через BMC, но и через CLI;

имена интерфейсов можно узнать, загрузившись в окружение с включенным механизмом

predictable names(убрав из параметров загрузкиnet.ifnames=0).

Нажать на кнопку Далее в правой нижней части экрана:

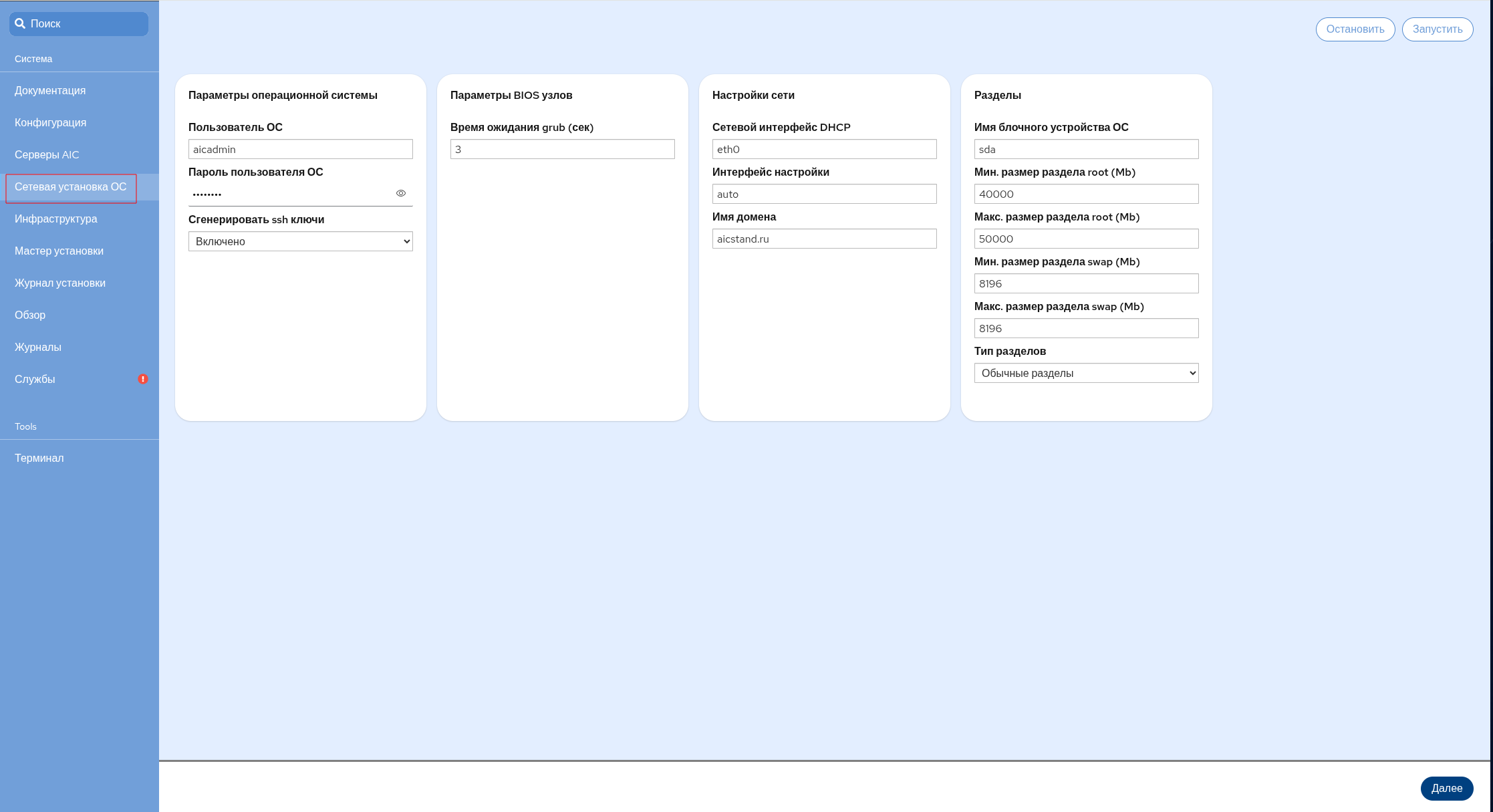

Сетевая установка ОС:#

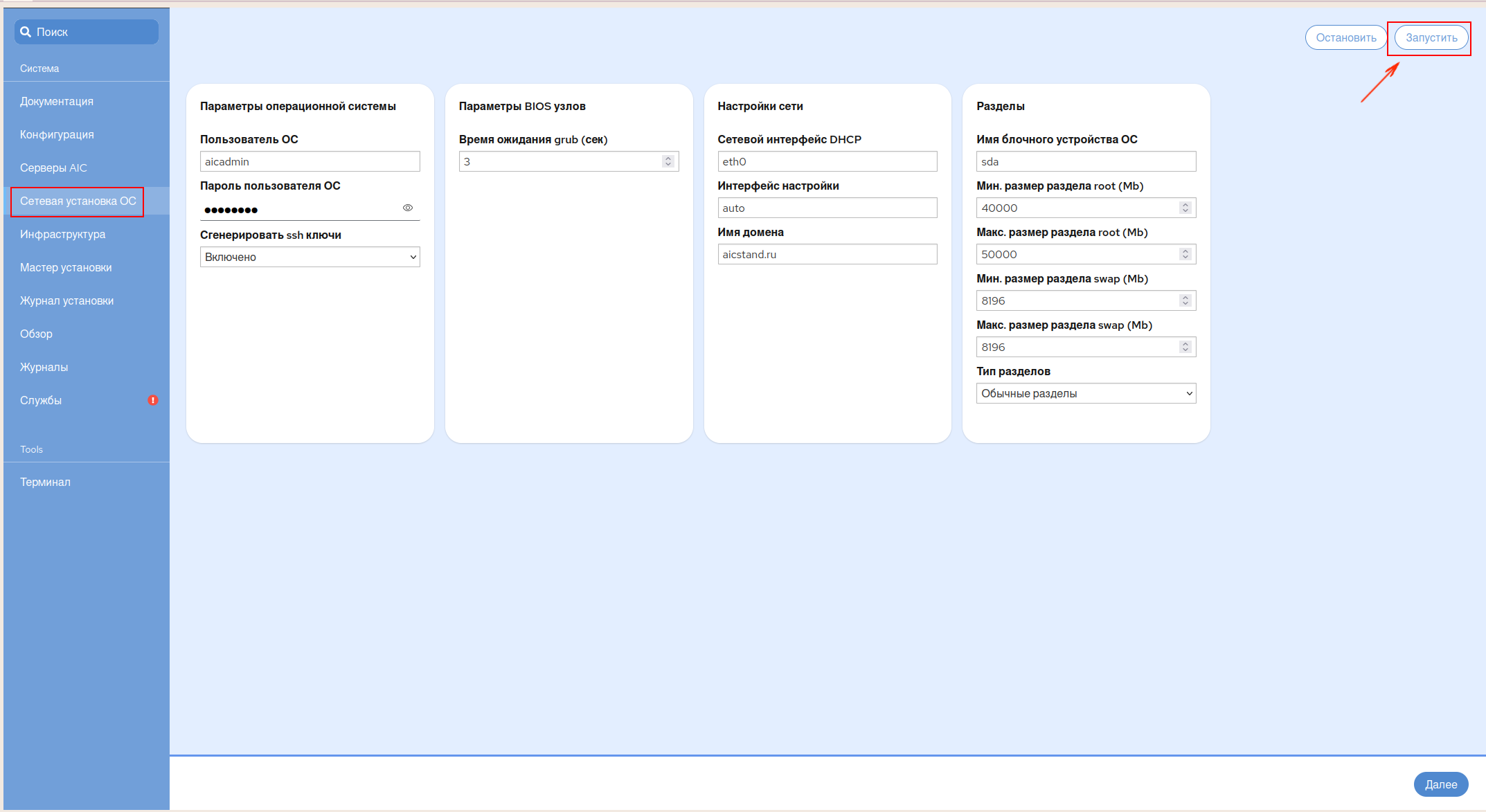

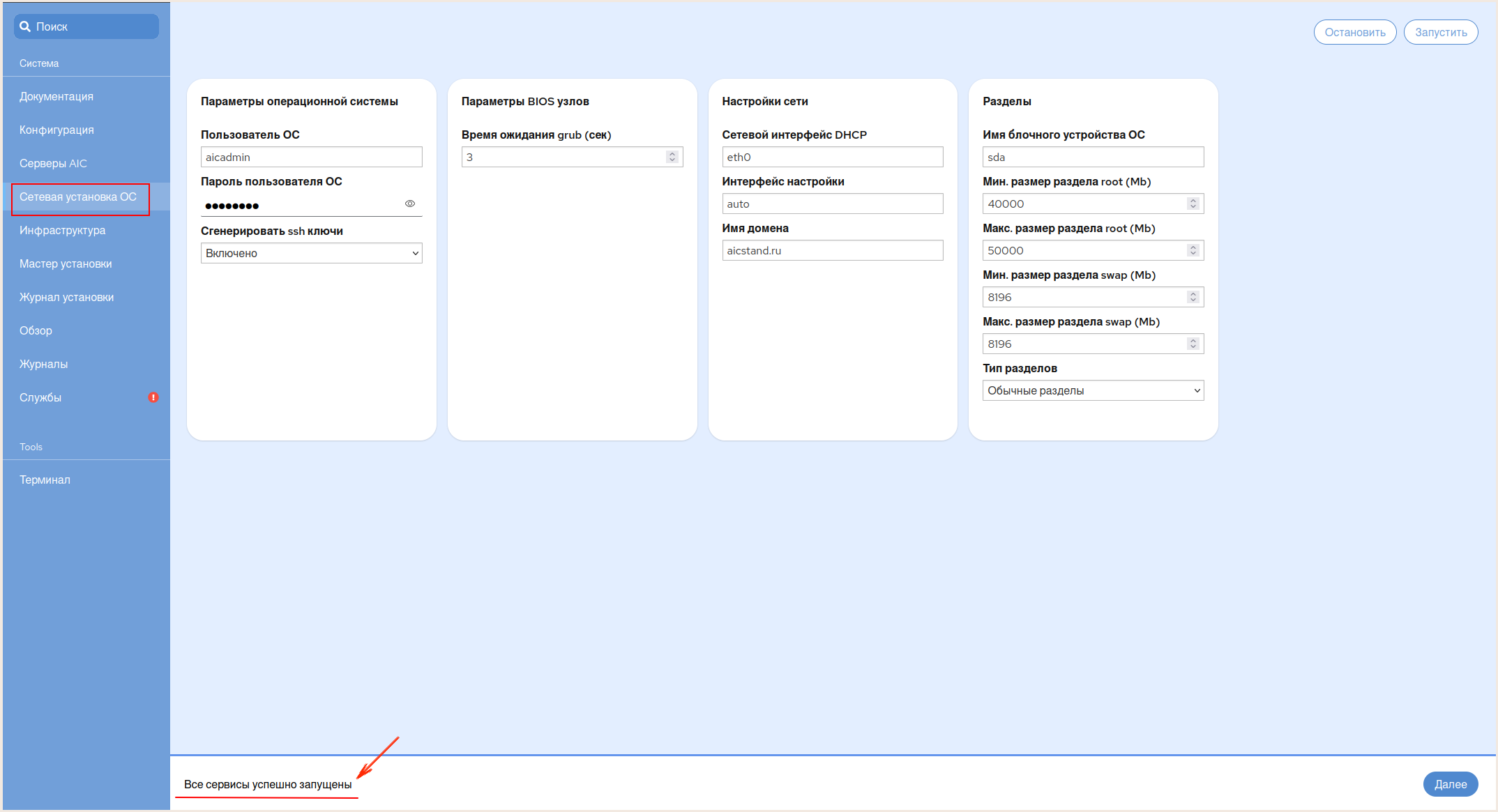

В открывшемся окне вкладки Сетевая установка ОС заполнить параметры, необходимые для конфигурирования процесса установки ОС:

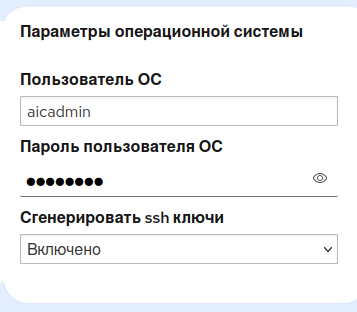

В блоке Параметры операционной системы:

В полях Пользователь ОС и Пароль пользователя ОС задать учетные данные Сервисного пользователя (Локального администратора), который будет создан на каждом сервере.

Предупреждение

Имя Пользователя ОС, заданное на данном этапе, должно совпадать со значением, задаваемым позднее на этапах Инфраструктура и Мастер установки. В случае несоблюдения данного условия автоматизация не получит доступ к серверам, и установка AIC выполнена не будет.

Пароль пользователя ОС должен состоять минимум из 8 символов.

Для организации беспарольного доступа к серверам виртуализации, в поле Сгенерировать ssh ключи в выпадающем списке выбрать значение Включено.

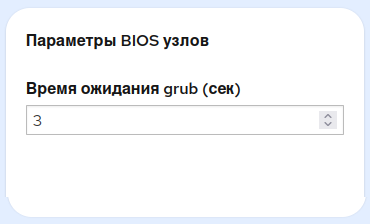

В блоке Параметры BIOS узлов в поле Время ожидания grab (сек) указать время ожидания Инсталлятора (в секундах) перед выполнением действия по умолчанию:

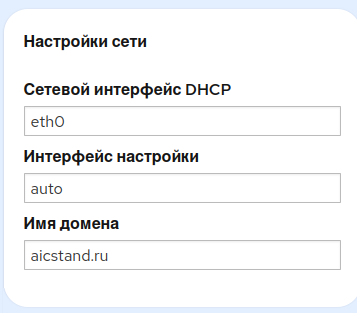

В блоке Настройка сети:

В поле Сетевой интерфейс DHCP указать имя сетевого интерфейса на bootstrap сервере, обслуживающего DHCP-запросы.

В поле Интерфейс настройки указать наименование сетевого интерфейса на серверах AIC с выходом в выделенную для PXE сеть. В случае, если название интерфейса неизвестно или в процессе установки возникли ошибки, следует поменять значение на auto.

В поле Имя домена указать доменное имя кластера. Данная информация необходима для переименования серверов:

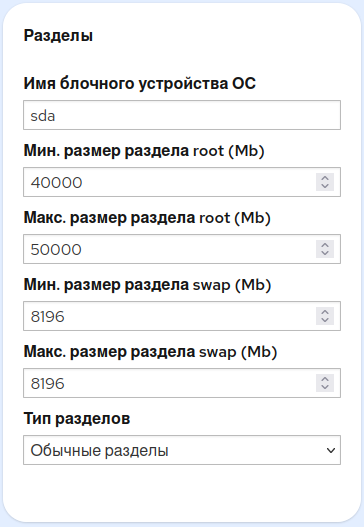

В блоке Разделы:

В поле Имя блочного устройства ОС задать идентификатор блочного устройства, на которое будет установлена ОС.

Предупреждение

Данное значение должно быть одинаковым для всех серверов, иначе установка произведена не будет.

В полях Мин. размер раздела root (Mb) и Макс. размер раздела root (Mb) указать размеры для основного раздела (

root).В полях Мин. размер раздела swap (Mb) и Макс. размер раздела swap (Mb) указать размеры для раздела Swap.

В поле Тип разделов в выпадающем списке выбрать значение в зависимости от схемы разбивки диска:

при выборе стандартной схемы, установить значение Обычные разделы;

при выборе схемы LVM, установить значение LVM разделы:

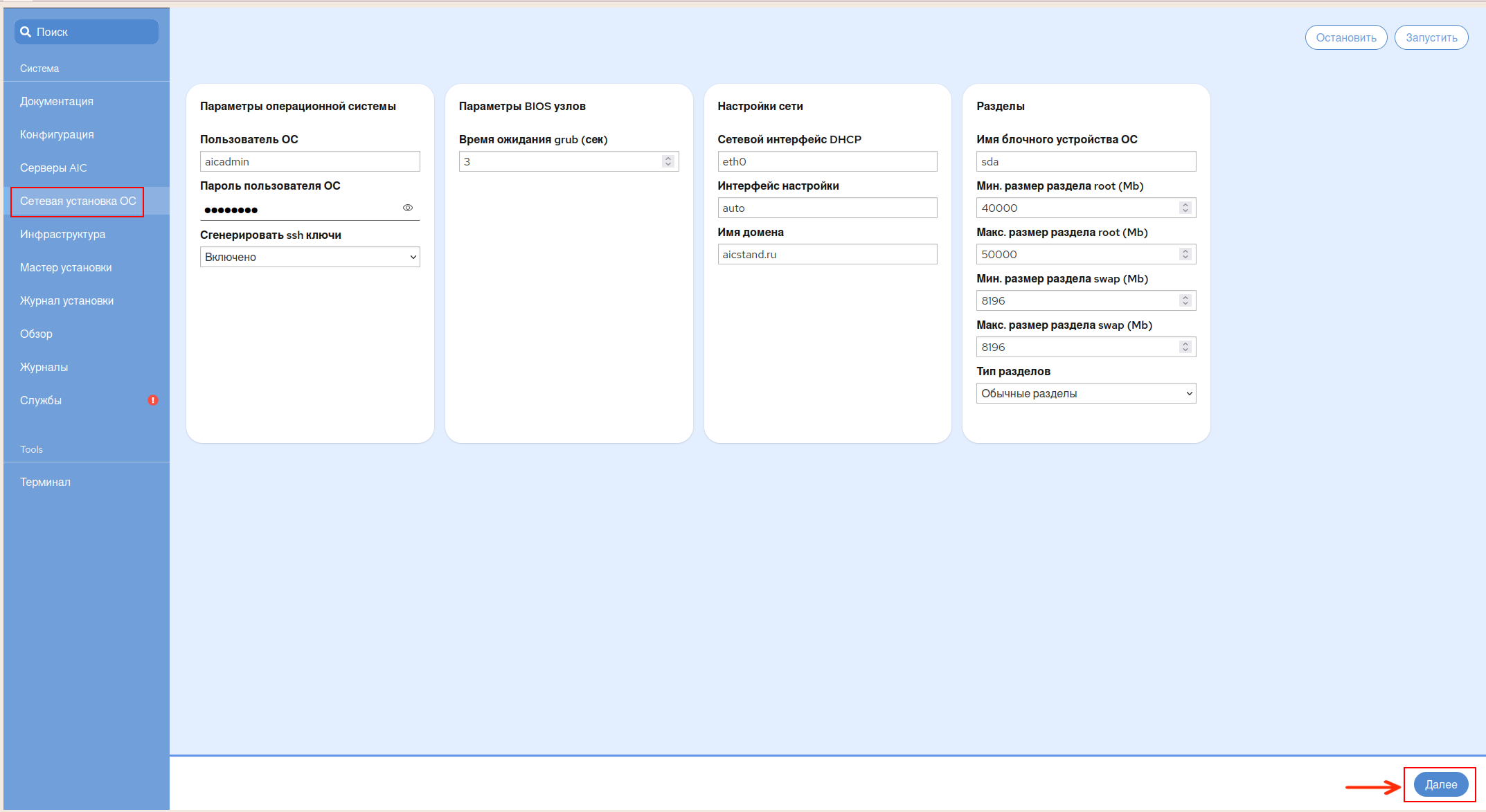

В верхней правой части экрана нажать кнопку Запустить:

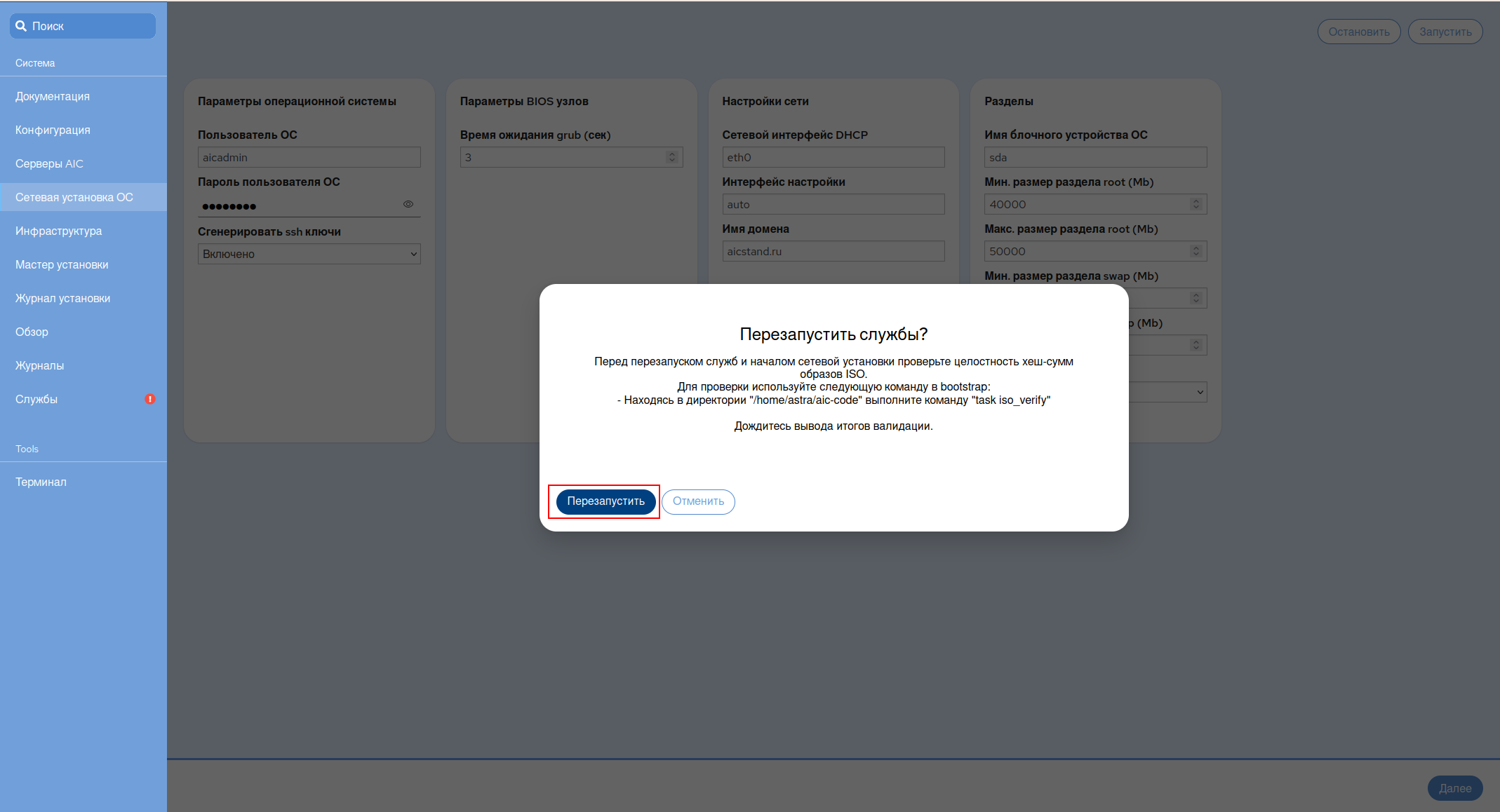

Для запуска сетевой загрузки и прохождения автоматической установки на основе файла конфигурации

Preseed, выполнить перезагрузку настраиваемых служб кнопкой Перезапустить:

Инсталлятор произведет запуск служб PXE для выполнения сетевой загрузки с последующей автоматизированной установкой ОС.

В случае успешного запуска сервисов, соответствующее сообщение появится в нижнем левом углу окна Сетевая установка ОС:

Перезагрузить серверы виртуализации для выполнения сетевой установки ОС. После успешного завершения установки, проверить сетевую доступность или выполнить настройку сети в ручном режиме.

После завершения установи ОС необходимо остановить запущенные для сетевой установки службы, нажав на кнопку Остановить в правом верхнем углу окна Сетевая установка ОС.

Для перехода к следующему шагу нажать на кнопку Далее в правой нижней части экрана:

Возможные ошибки на этапах Серверы AIC и Сетевая установка ОС#

Для устранения ошибок, возникших на этапах Серверы AIC и Сетевая установка ОС, необходимо обратиться к интерфейсу командной строки сервера Bootstrap. Наиболее вероятные ошибки:

Сервис DHCP возвращает ошибки при попытке запуска.

удостовериться, что сетевому интерфейсу, имеющему выход в PXE-сеть, был назначен второй адрес: 10.0.9.11/24;

удостовериться, что в файле с переменными было корректно определено значение переменной DHCPINT. В переменной должно быть указано имя сетевого интерфейса PXE-сети, с временно назначенным вторым адресом 10.0.9.11/24.

Целевой сервер не загружается в среду установки.

удостовериться, что в UEFI целевого сервера в разделе Boot для загрузки выбран корректный сетевой интерфейс, имеющий доступ к PXE-сети (зависит от модели сервера);

во время загрузки посмотреть статус DHCP, где логируется событие выдачи IP-адреса;

удостовериться, что в секции host в файле конфигурации DHCP (/etc/dhcp/dhcpd.conf) корректно заполняются данные;

удостовериться, что адрес сервера установки уникален в сети.

Целевой сервер загрузился в среду установки, но программа-установщик не получает настройки сети.

при появлении диалогового окна с предложением повторить настройку сети, выбрать пункт, запускающий повторное автоматическое получение IP-адреса;

удостовериться, что в секции host в файле конфигурации DHCP корректно заполняются данные;

посмотреть название сетевого интерфейса и указать его в поле Интерфейс настройки этапа Сетевая установка ОС;

войти в shell (для запуска терминала нажать Alt+F2…F7) и проверить получение адреса командой:

udhcpc -i <имя_интерфейса>

исключить нахождение других работающих DHCP-серверов в той же сети.

Инсталлятор выдает ошибку на этапе создания разделов жесткого диска:

удостовериться в правильности указанных размеров партиций в файле

/srv/ftp/recipes/recipe_regular;удостовериться в правильности указанного названия целевого диска в файле

/srv/tftp/se/preseeds/preseed_1.7.7.6_regular.cfg.

Целевой сервер загрузился в ОС после установки, но сеть осталась ненастроенной.

в общем случае настройка сети производится после установки и загрузки в новую ОС;

удостовериться, что подготовленный файл

interfacesназван корректно (interfaces_<MAC-адрес целевого сервера>) и был расположен в папке scripts до запуска скриптов и начала установки;удостовериться в отсутствии ошибок в разделе Редактирование interfaces этапа Серверы AIC;

удостовериться, что пакеты

vlan,bridge-utilsиifenslaveбыли установлены.

В случае, если на этапе Сетевая установка ОС не был заполнен раздел Редактировать Interfaces, перед переходом к развертыванию инфраструктуры AIC, необходимо вручную выполнить настройку сетевых интерфейсов на целевых серверах, в соответствии с утвержденной Сетевой топологией.

Для этого требуется добавить сетевые мосты для трех сетей (менеджмент сеть, сеть для трафика СРК, сеть для трафика СХД) на каждом из целевых серверов. Cетевые мосты должны иметь одинаковые имена на всех серверах.

Развертывание инфраструктуры AIC#

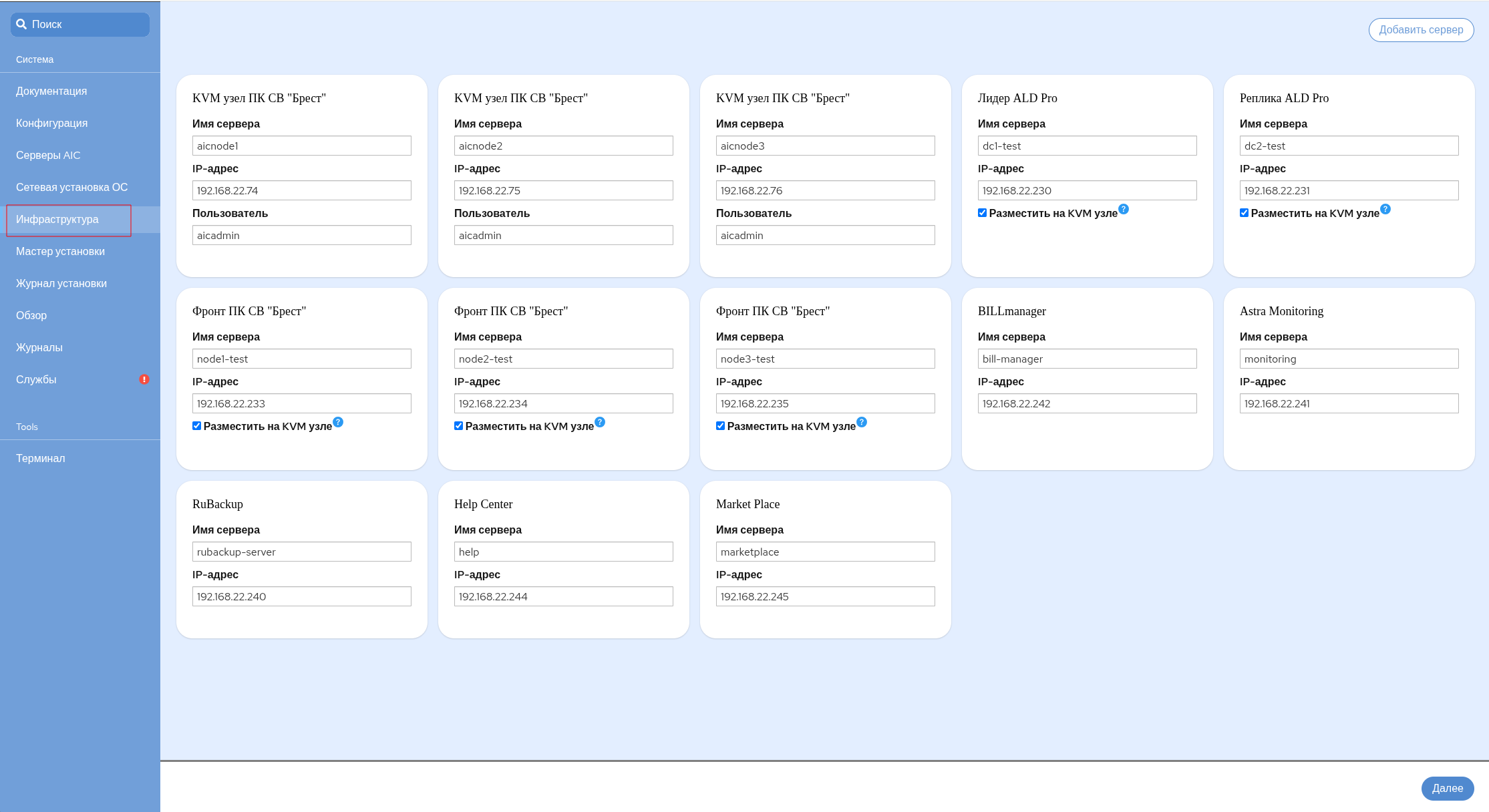

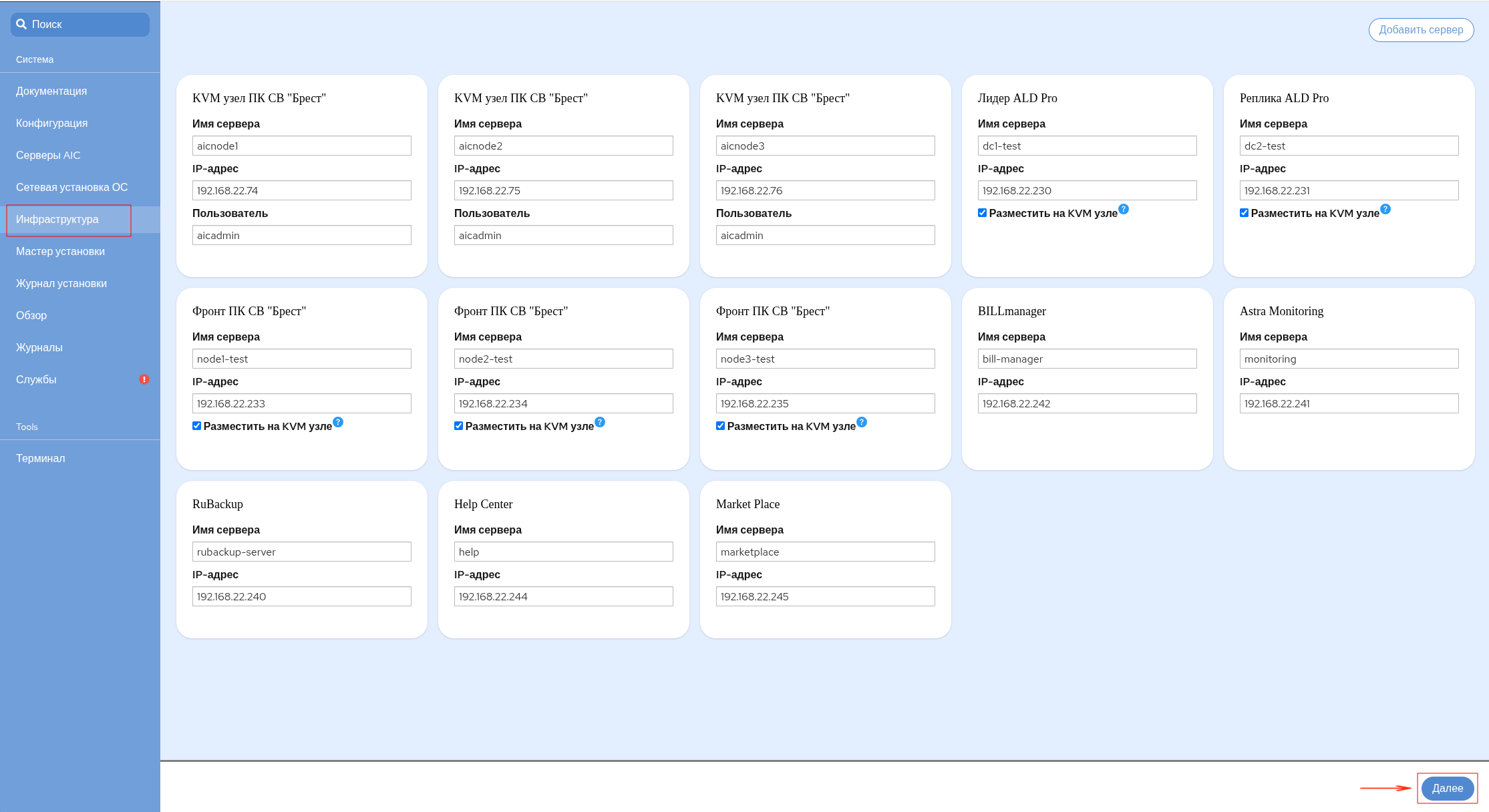

По завершении Сетевой установки ОС необходимо перейти к конфигурированию инфраструктуры AIC. Для этого в открывшемся окне Инфраструктура:

Заполнить данные компонентов AIC:

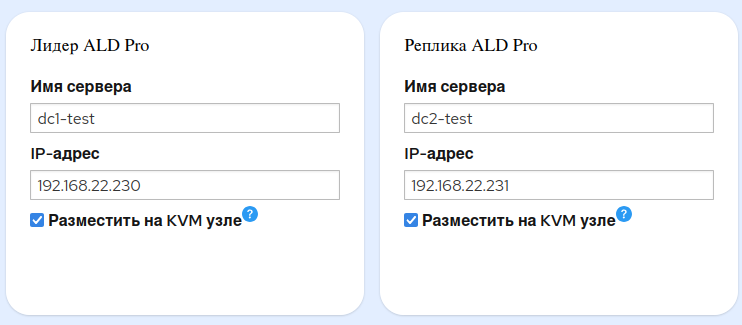

Для создания ВМ будущих серверов управления ПК СВ и серверов КД ALD Pro, требуется указать имена и адреса данных серверов (в данном примере: dc1-test, dc2-test для КД ALD Pro и node1-test, node2-test, node3-test для ПК СВ), а также указать три целевых сервера, на которых будут созданы ВМ для этих ресурсов. .. warning:: В случае добавления дополнительных серверов, на этапе Инфраструктура необходимо будет добавить данные серверы в создаваемую инфраструктуру, определив их роли, используя кнопку Добавить сервер в верхнем правом углу окна Инфраструктура.

Все задаваемые IP-адреса должны быть из менеджмент сети.

Примечание

Три сервера, на которых будут развернуты ВМ, — серверы управления ПК СВ и серверы КД, будут являться так же серверами виртуализации ПК СВ.

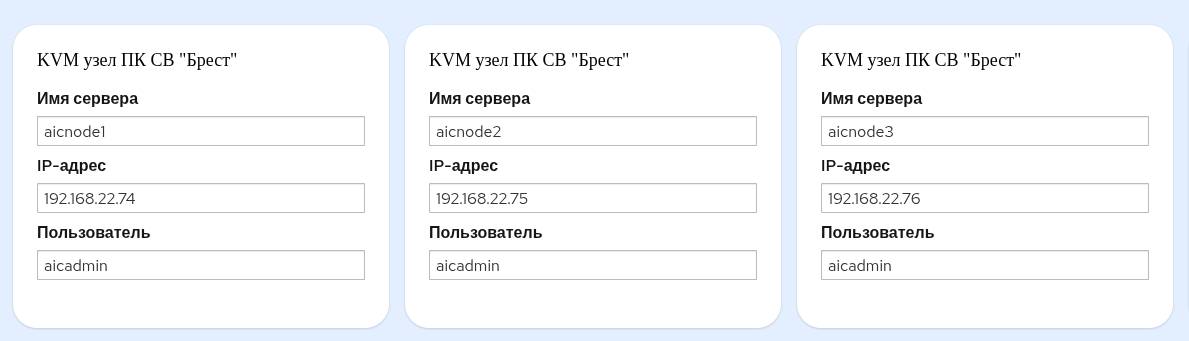

Для подготовки трех целевых серверов, перед созданием ВМ в каждый из трех блоков KVM узел ПК СВ «Брест»:

в поле Имя сервера ввести имя одного из трех ранее подготовленных серверов виртуализации, на которых будут создаваться ВМ для контроллера домена и серверов управления;

в поле IP-адрес указать IP-адрес соответствующего сервера виртуализации;

в поле Пользователь указать имя Сервисного пользователя, заданное на этапе Сетевая установка ОС:

Примечание

Данные, указанные в полях Имя сервера и Пользователь на данном этапе, должны полностью совпадать с аналогичными данными, указанными на этапе Сетевая установка ОС. В случае несоблюдения данного условия возможна некорректная отработка автоматизации процесса развертывания AIC.

В блоках Лидер ALD Pro и Реплика ALD Pro:

в поле Имя сервера указать имена серверов КД ALD Pro (основного и реплики);

Примечание

Имена серверов не должны содержать в себе спецсимволы кроме

-.в поле IP-адрес указать IP-адреса серверов КД ALD Pro (основного и реплики);

Примечание

Несмотря на разделение серверов КД на Лидера и Реплику, они являются равноправными. Между ними будет настроена двунаправленная репликация с периодичностью синхронизации баз данных примерно раз в 5-10 минут. Такое разделение представлено исключительно для удобства работы автоматизации.

в поле Разместить на KVM узле установить флаг:

Примечание

Серверы Контроллера Домена могут быть развернуты на отдельных серверах или на виртуальных машинах (рекомендуется развертывать как ВМ). От установки флага в поле Разместить на KVM узле зависит, будут ли ВМ для КД (Лидер ALD Pro и Реплика ALD Pro ) развернуты на целевых серверах AIC.

При выборе данной опции каждый контроллер домена будет размещен и настроен на своем целевом сервере автоматически. Если опция будет отключена, пользователю потребуется самостоятельно подготавливать серверы для данных ролей.

При развертывании КД на целевых серверах необходимо снять данный флаг, предварительно подготовив серверы, обеспечив беспарольный доступ Сервисному пользователю, заданному в блоке KVM узел ПК СВ «Брест».

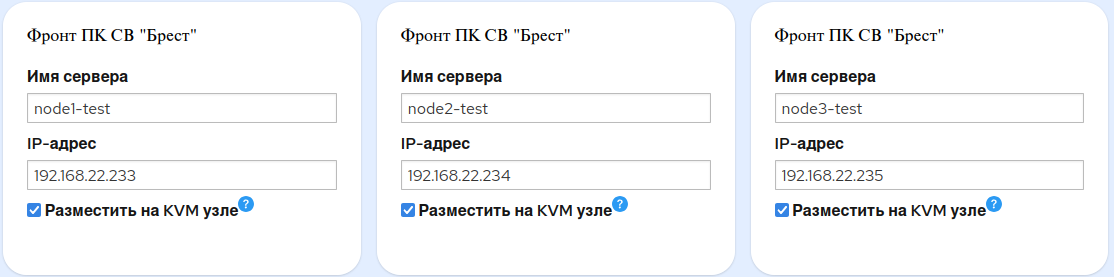

Во всех трех блоках Фронт ПК СВ «Брест»:

в поле Имя сервера указать имя каждого из трех серверов управления ПК СВ;

в поле IP-адрес указать IP-адреса соответствующих серверов управления;

в поле Разместить на KVM узле установить флаг:

Примечание

Серверы управления ПК СВ могут быть развернуты на отдельных серверах или на виртуальных машинах (рекомендуется развертывать как ВМ). От установки флага в поле Разместить на KVM узле зависит, будут ли ВМ для серверов управления ПК СВ (Фронты ПК СВ «Брест») развернуты на целевых серверах AIC. При выборе данной опции каждый сервер управления ПК СВ будет размещен и настроен на своем целевом сервере автоматически. Если опция будет отключена, пользователю потребуется самостоятельно подготавливать серверы для данных ролей.

При развертывании серверов управления ПК СВ на целевых серверах необходимо снять данный флаг, предварительно подготовив серверы, обеспечив беспарольный доступ Сервисному пользователю, заданному в блоке KVM узел ПК СВ «Брест».

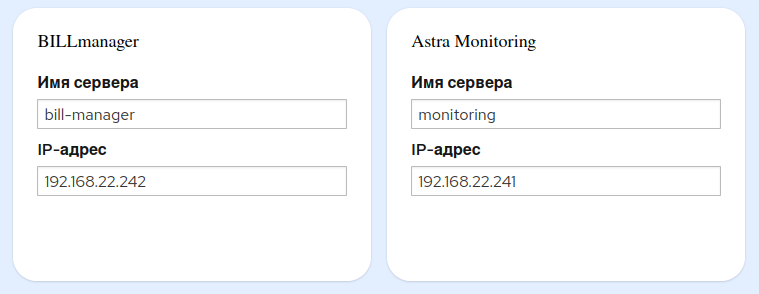

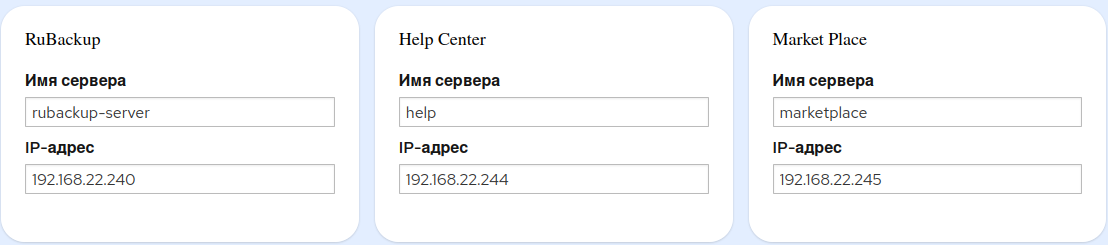

В блоках BILLManager, Astra Monitoring, RuBackup, Help Center и Market Place:

В поле Имя сервера задать имя ВМ каждого из компонентов.

Предупреждение

Имена серверов для данных компонентов должны начинаться со строчной буквы латинского алфавита.

В поле IP-адрес указать IP-адрес ВМ каждого из компонентов AIC:

В правом нижнем углу окна Инфраструктура нажать на кнопку Далее:

Запуск процесса установки#

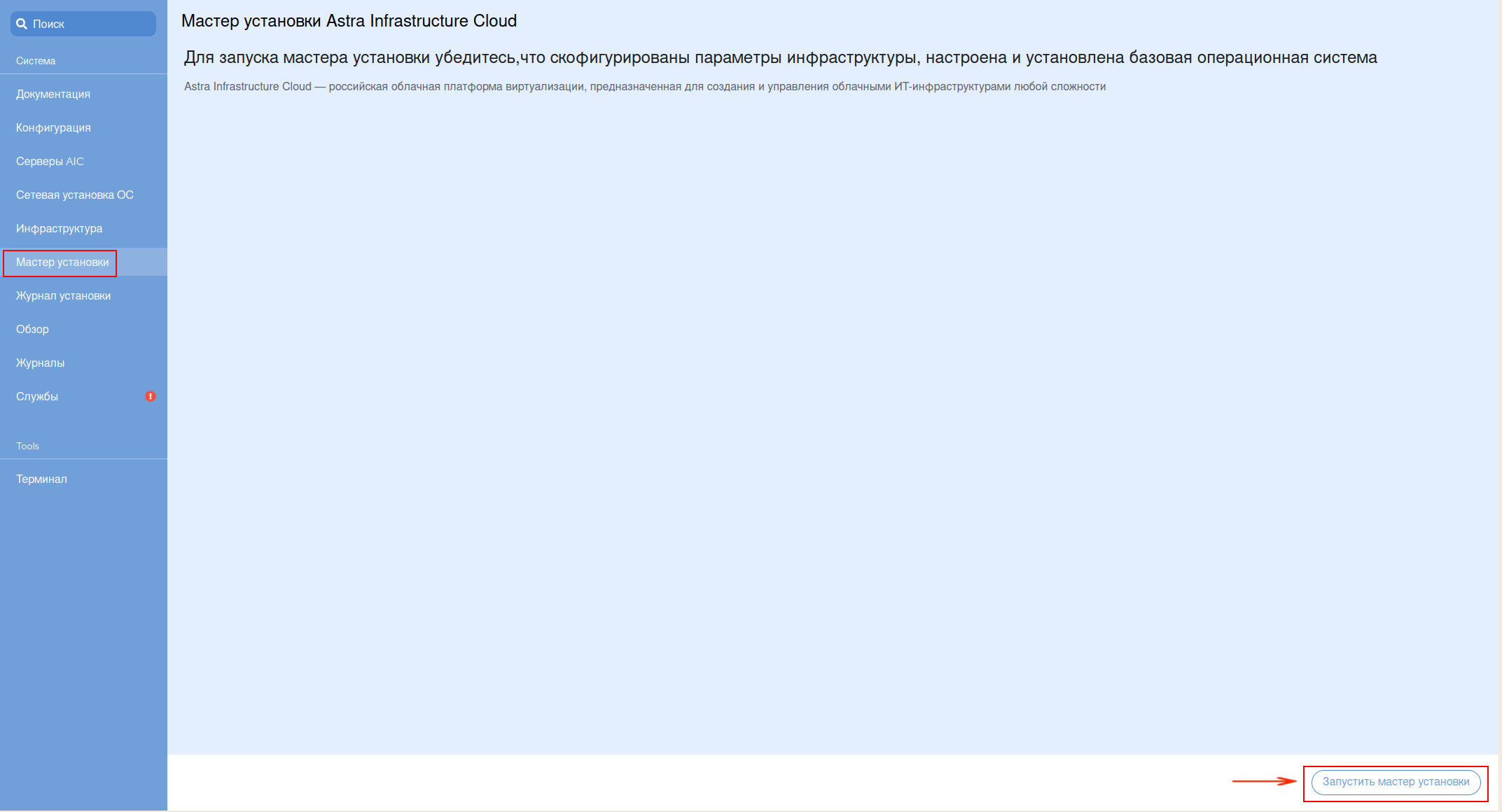

Примечание

Перед запуском процесса установки следует удостовериться, что все параметры инфраструктуры сконфигурированы, а на серверы установлена базовая ОС.

В открывшемся окне Мастер установки Astra Infrastructure Cloud нажать на кнопку Запустить мастер установки в правом нижнем углу экрана:

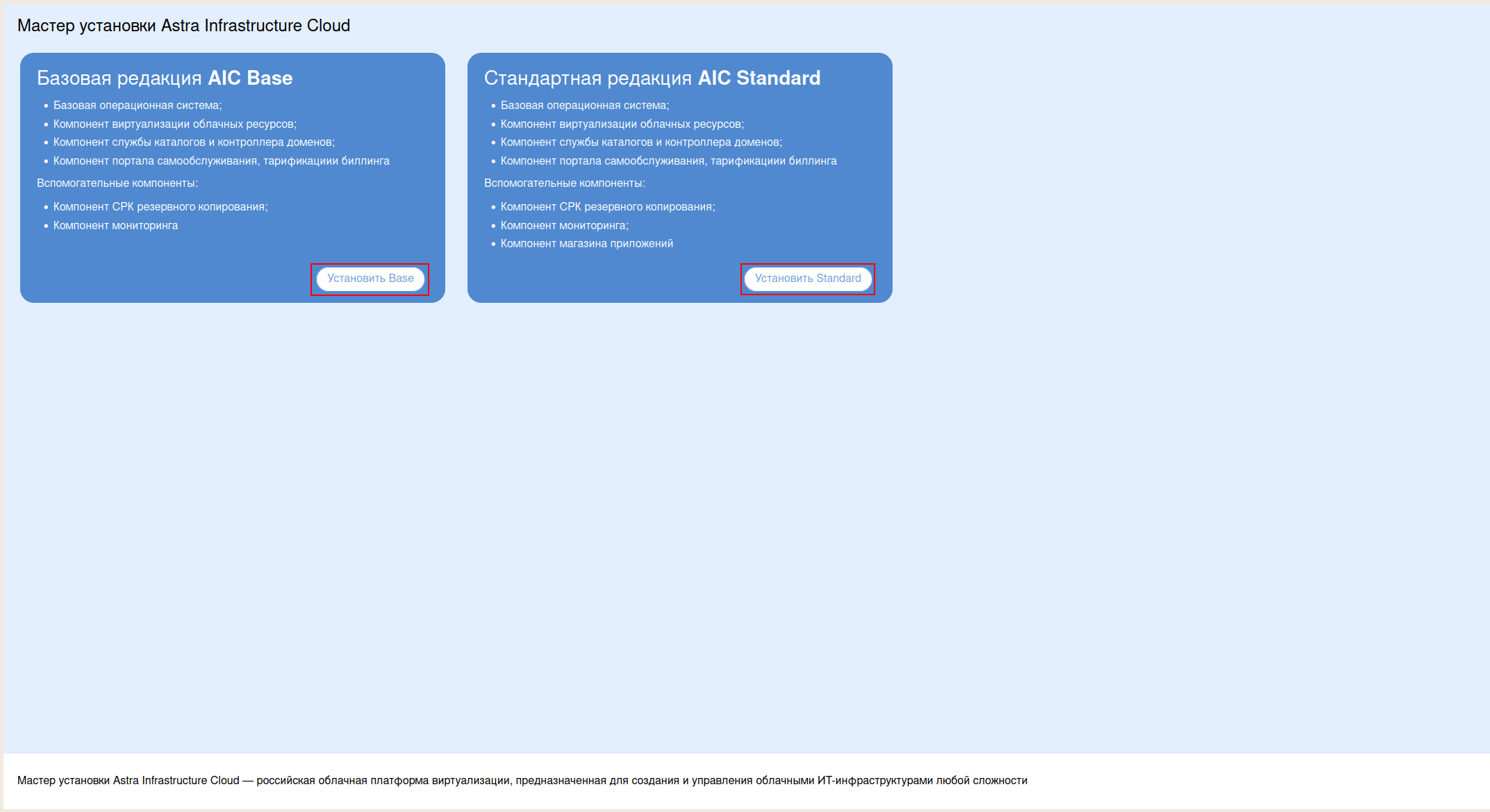

AIC поставляется в двух редакциях: AIC Base (Базовая) и AIC Standard (Стандартная). Для запуска установки выбрать из предложенных редакцию, согласно приобретенной лицензии. Нажать на кнопку: Установить Base либо Установить Standard соответственно:

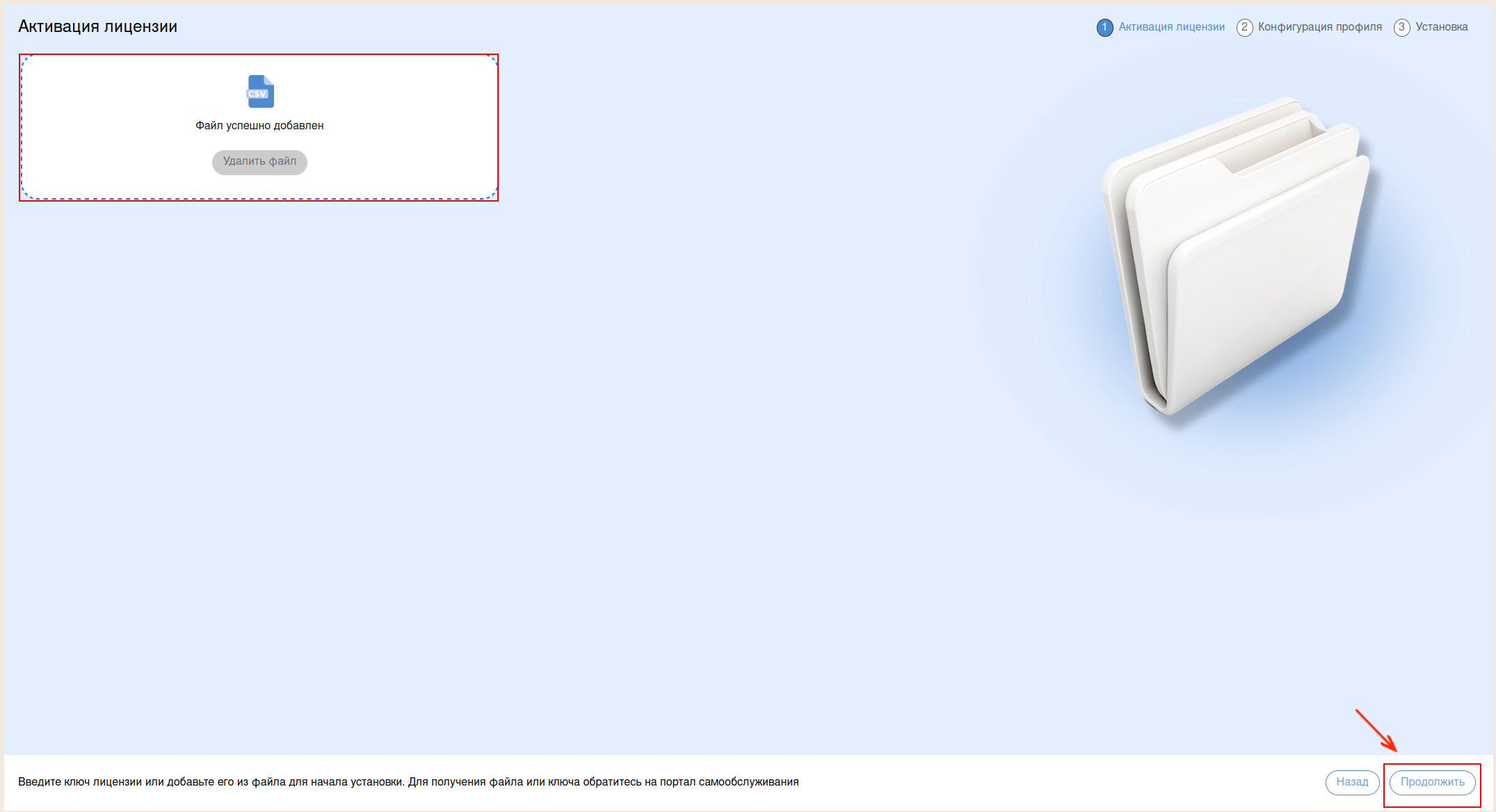

Процесс установки состоит из нескольких этапов:

Активация лицензии. Приобретенная лицензия будет подгружена в систему автоматически. Для продолжения развертывания нажать на кнопку Продолжить в правой нижней части экрана:

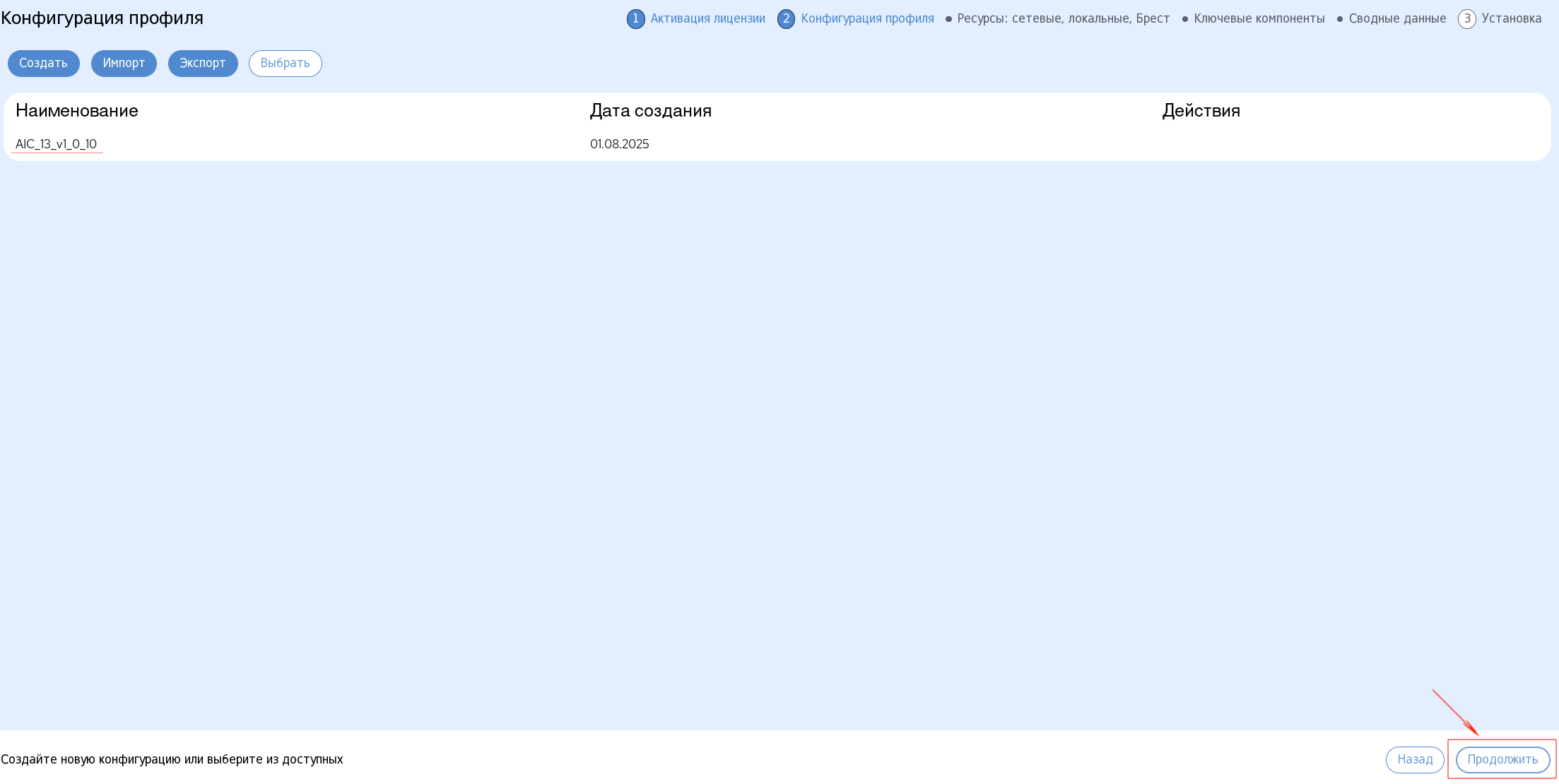

Конфигурация профиля. На данном этапе производится конфигурирование профиля, сети, хранилища и ключевых компонентов AIC. Для этого:

В открывшемся окне Конфигурация профиля подтвердить выбор ранее созданной конфигурации, нажав на кнопку Продолжить в правой нижней части экрана:

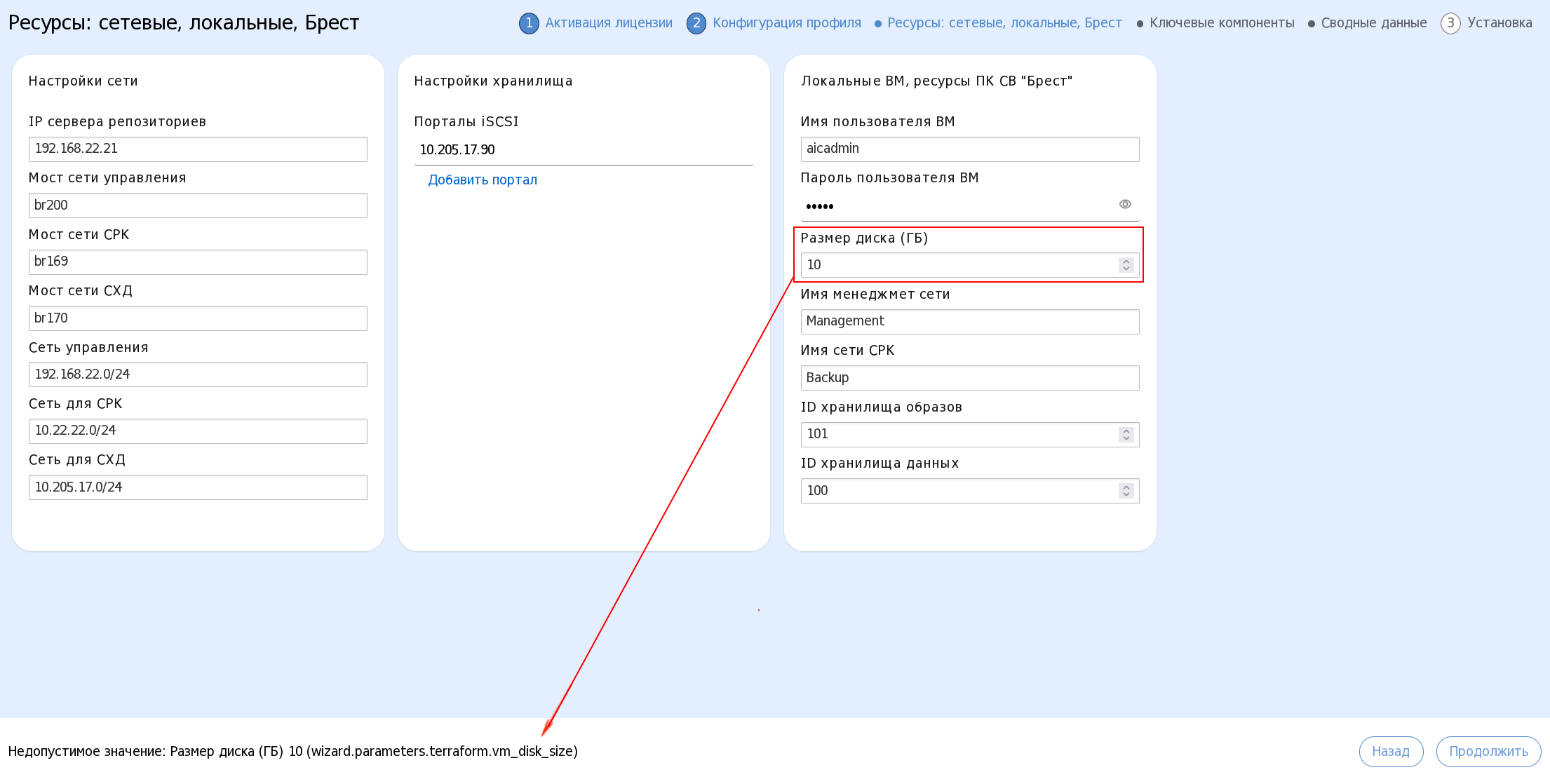

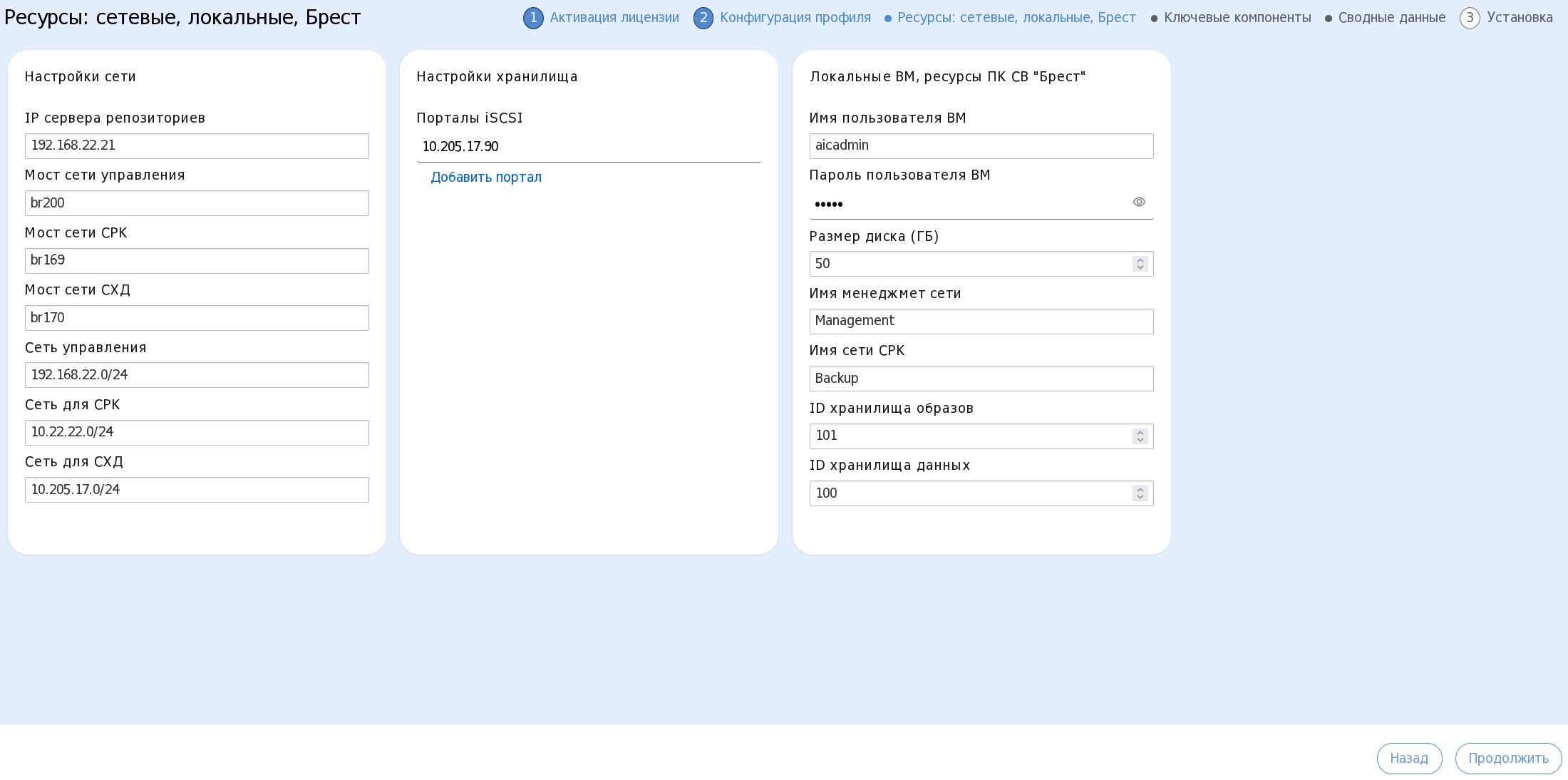

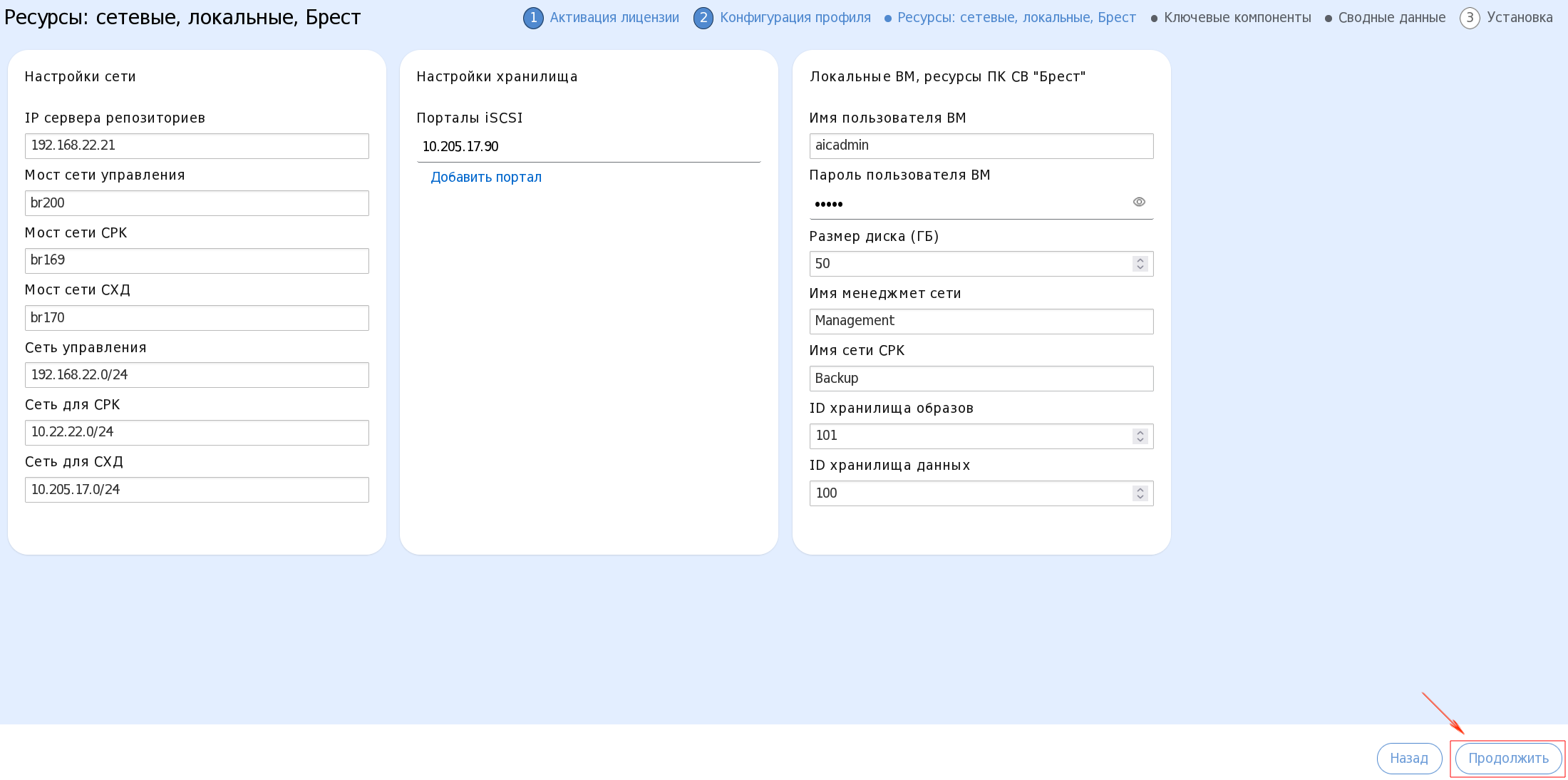

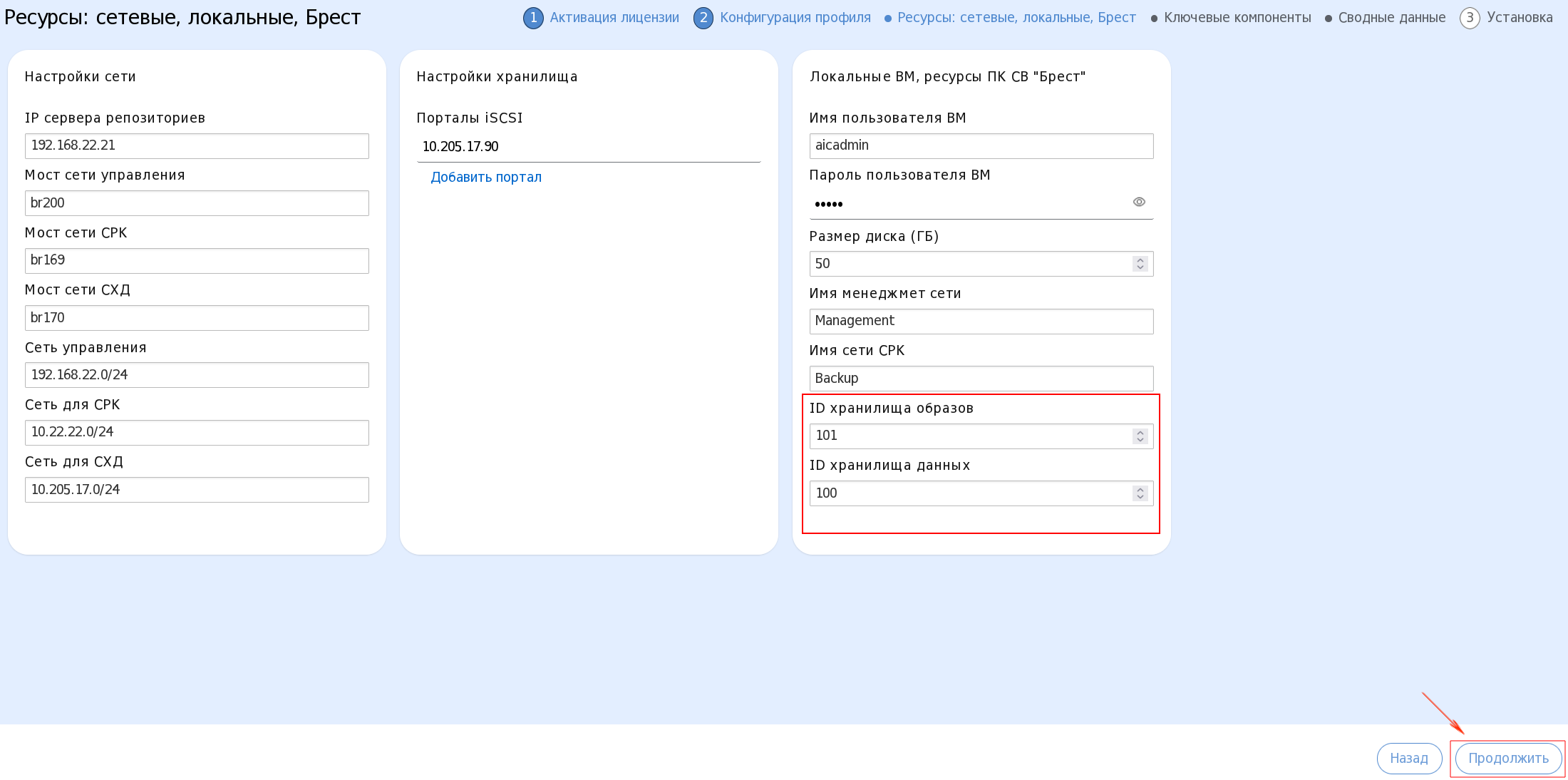

В открывшемся окне Ресурсы: сетевые, локальные, Брест:

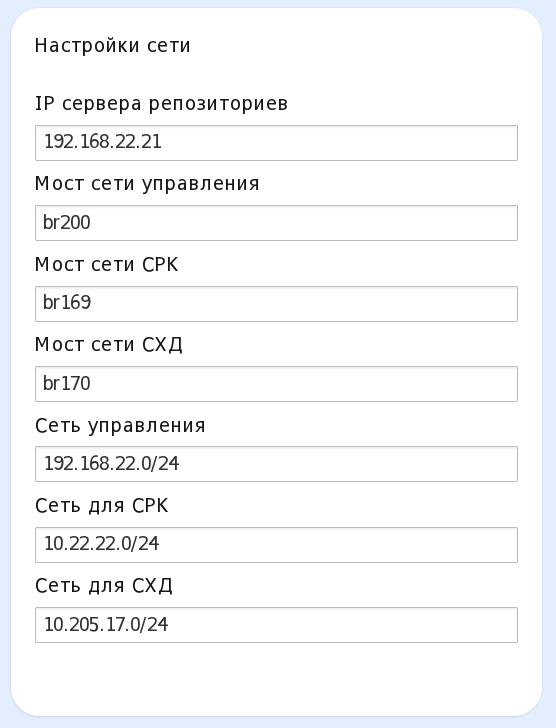

В блоке Настройка сети:

в поле IP сервера репозиториев указать IP-адрес сервера Bootstrap из менеджмент сети;

в поле Мост сети управления указать имя сетевого моста на целевых серверах, который имеет выход в менеджмент сеть;

в поле Мост сети СРК указать имя сетевого моста на целевых серверах, который имеет выход в сеть для трафика СРК;

в поле Мост сети :term:`СХД` указать имя сетевого моста на целевых серверах, который имеет выход в сеть для трафика СХД;

Предупреждение

Для корректной установки AIC требуется предварительно создать на серверах виртуализации Мост сети управления и Мост сети СРК. В противном случае установка выполнена не будет.

Поля Мост сети СХД и Сеть для iSCSI не являются обязательными к заполнению. В случае незаполнения данных полей, виртуальная сеть для СХД не будет создана и не будет подключена к серверам виртуализации и управления ПК СВ.

Сетевые мосты, относящиеся к одной сети, должны иметь одинаковые имена на всех серверах. Например, если мост менеджмент сети на первом сервере называется

br200, то на втором и на третьем серверах он должен называться так же.В процессе создания локальных ВМ будет выполнен ряд проверок на валидность значений переменных, а также на наличие сетевых мостов на серверах AIC. В случае если автоматизация завершится с ошибкой, в Журнале установки появится информация с описанием причин ее возникновения.

в полях Сеть управления, Сеть для СРК и Сеть для СХД указать адреса менеджмент сети, сети СРК и сети СХД соответственно. Адреса необходимо дополнить префиксом (в данном примере /24):

Примечание

В данном блоке обозначаются только IP-адреса сетей и сетевые мосты на основе указанных сетей. Настройка параметров сетей была выполнена на этапе Сетевая установка ОС автоматически, при заполнении данных в разделе Редактировать Interfaces или вручную пользователем по завершению сетевой установки ОС перед началом процесса развертывания инфраструктуры AIC.

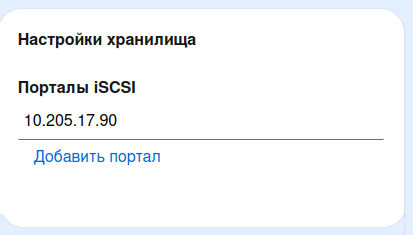

Инсталлятор AIC автоматически подключает только хранилища типа iSCSI LUN. Хранилища иного типа настраиваются пользователем в ручном режиме по завершении выполнения Первого блока этапов установки.

В блоке Настройки хранилища указать IP-адрес портала iSCSI. В случае, если использовать iSCSI как СХД не планируется, значение переменной можно оставить по умолчанию:

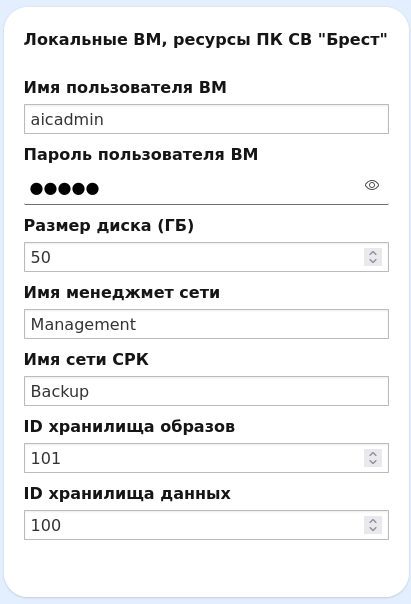

В блоке Локальные ВМ, ресурсы ПК СВ «Брест»:

в полях Имя пользователя ВМ и Пароль пользователя ВМ задать учетные данные Сервисного пользователя;

Примечание

Необходимо внести данные Сервисного пользователя, заданные на этапе Сетевая установка ОС.

в поле Размер диска (ГБ) указать в ГБ размер диска, который будет создан для каждой локальной ВМ. Значение должно быть не менее 50 ГБ;

в поле Имя менеджмент сети задать имя, которое будет назначено менеджмент сети в ПК СВ;

в поле Имя сети СРК задать имя, которое будет назначено сети СРК в ПК СВ;

в полях ID хранилища образов и ID хранилища данных временно оставить значение по умолчанию.

Примечание

Идентификаторы хранилищ будет необходимо скорректировать после выполнения этапа Подключение хранилищ к подсистеме виртуализации.

Нажать на кнопку Продолжить в правом нижнем углу экрана:

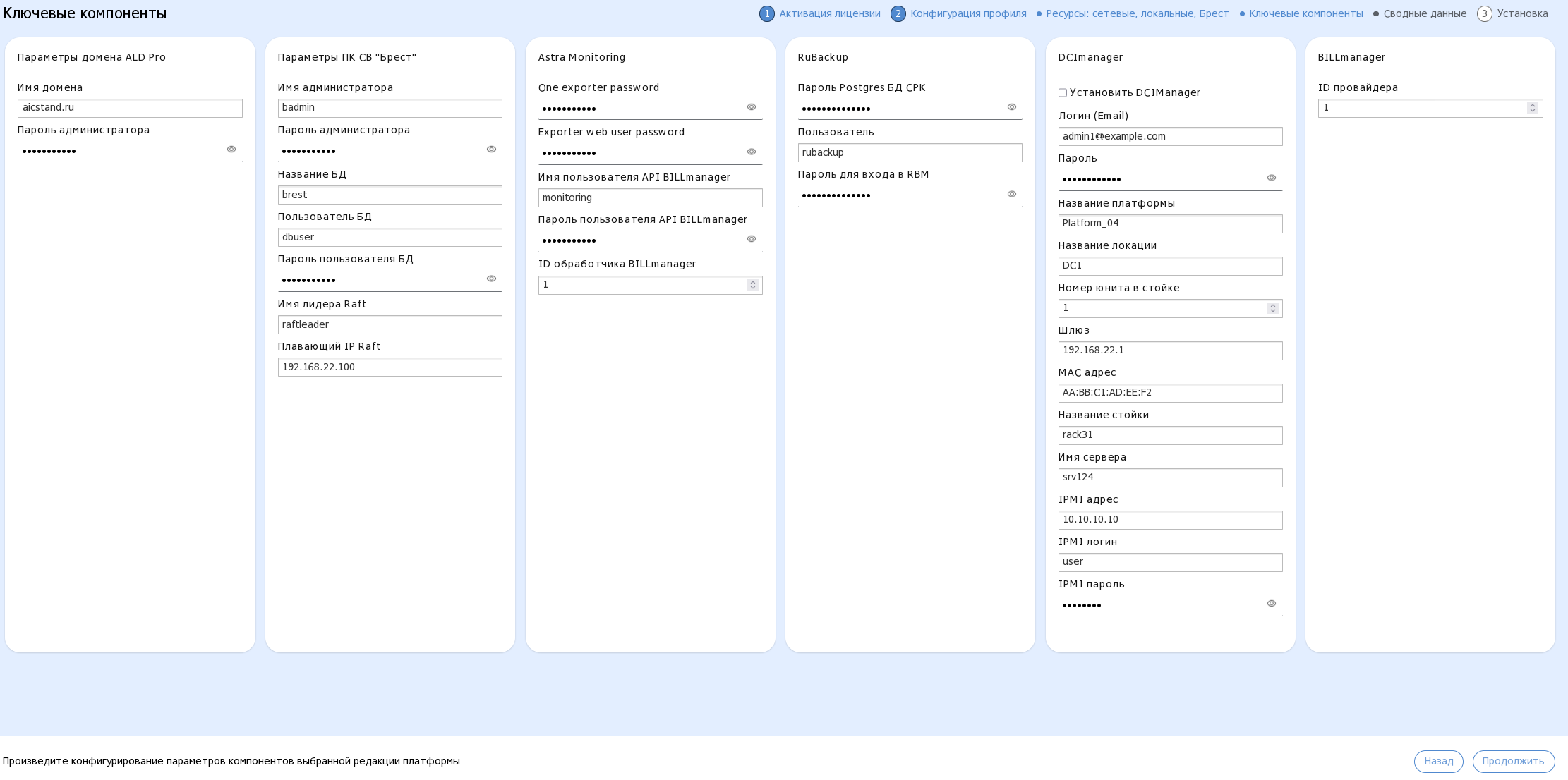

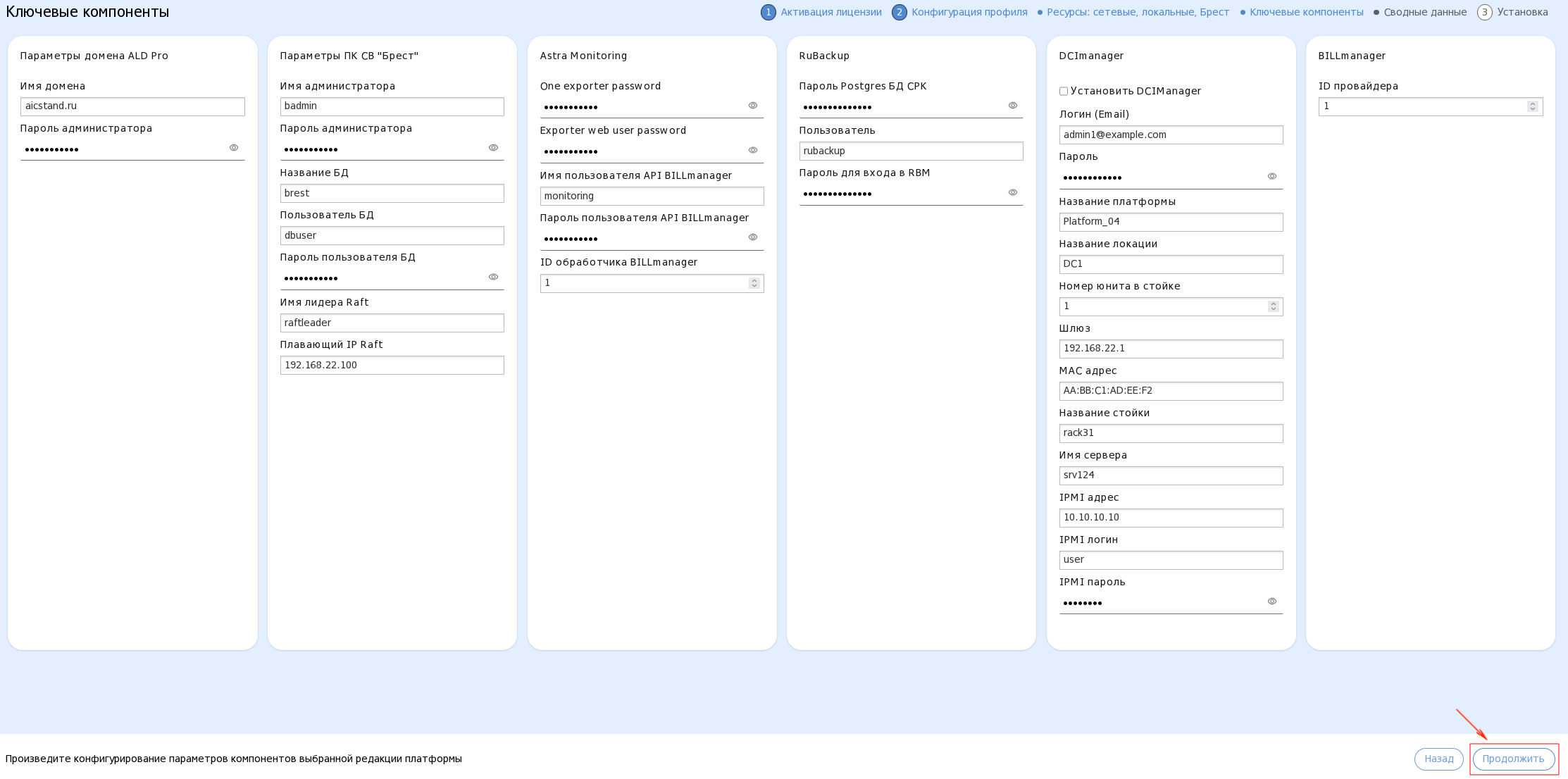

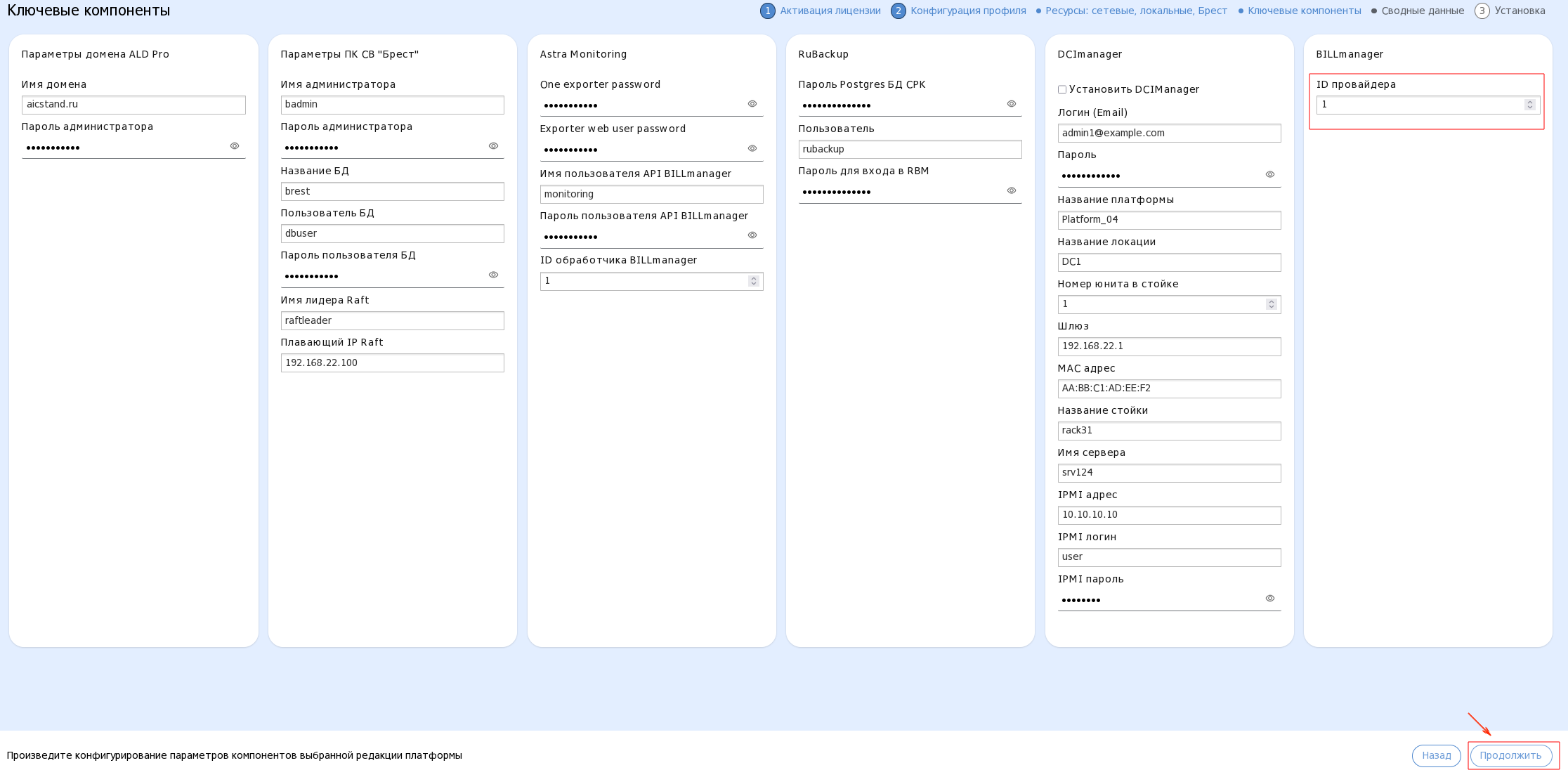

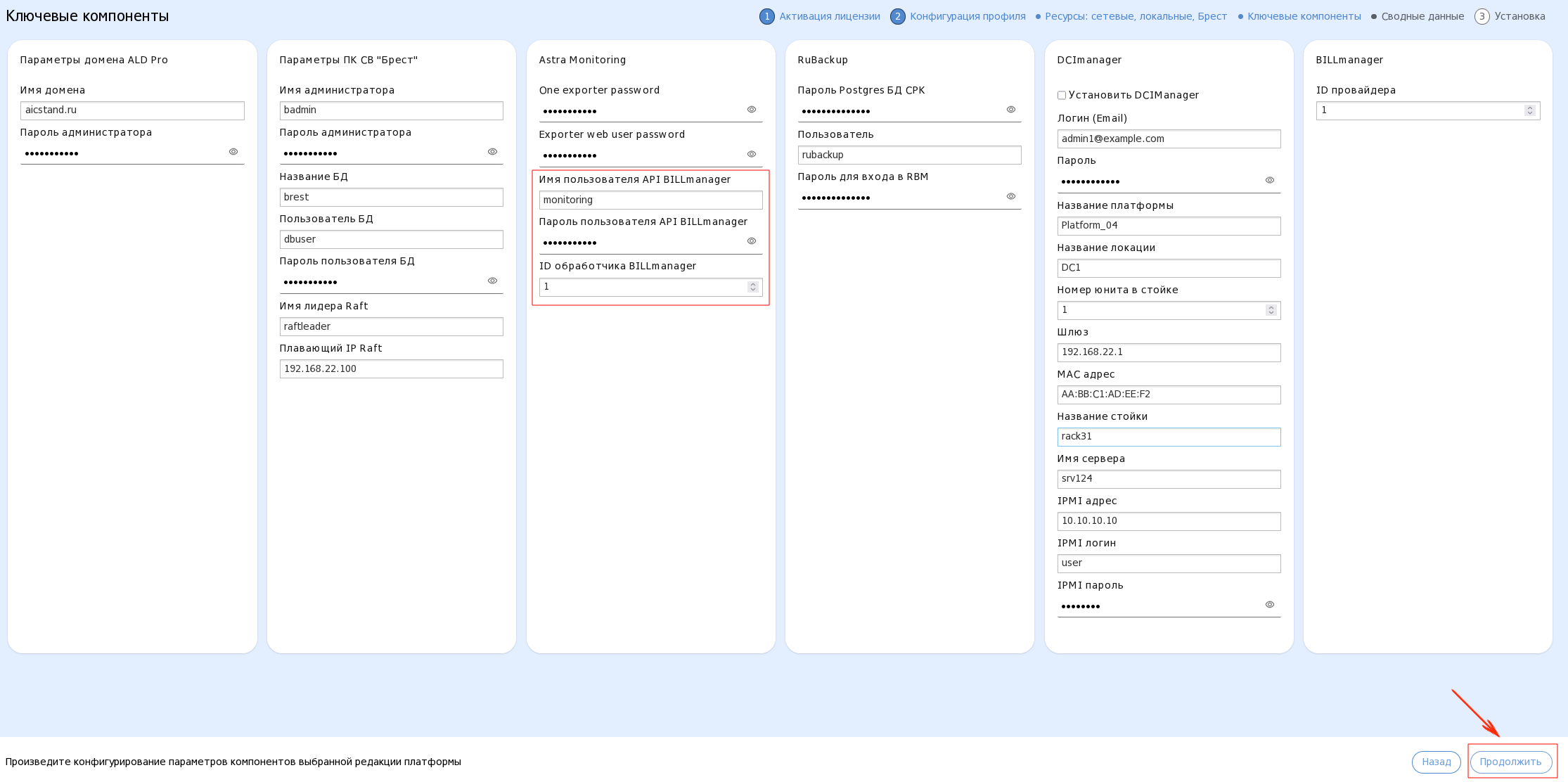

В открывшемся окне Ключевые компоненты задать параметры компонентов AIC, в соответствии с выбранной редакцией платформы:

Для этого:

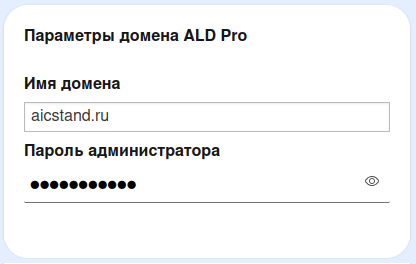

В блоке Параметры домена ALD Pro необходимо:

в поле Имя домена указать имя домена ALD Pro, заданного на этапе Сетевая установка ОС;

в поле Пароль администратора указать пароль администратора контроллера домена (имя пользователя КД по умолчанию —

admin).Примечание

Пароль администратора КД должен:

состоять минимум из 8 символов;

содержать спецсимволы, цифры, буквы нижнего и верхнего регистра;

не содержать в себе следующие спецсимволы:

$,|,!,#,<,>,\,/,(,).

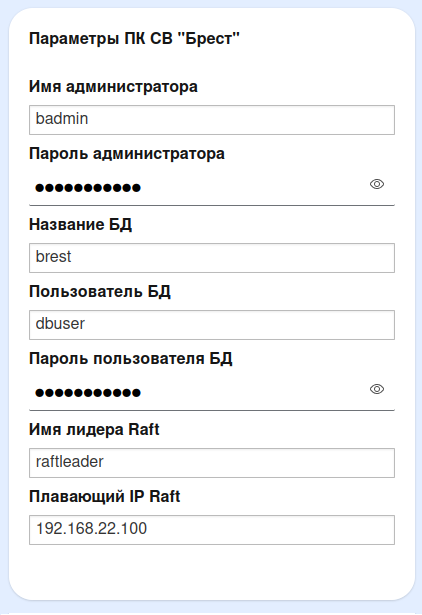

В блоке Параметры ПК СВ «Брест»:

в полях Имя администратора и Пароль администратора задать учетные данные администратора ПК СВ;

Примечание

Пароль администратора должен:

состоять минимум из 8 символов;

содержать спецсимволы, цифры, буквы нижнего и верхнего регистра;

не содержать в себе следующие спецсимволы:

$,|,!,#,<,>,\,/,(,).

в поле Название БД указать наименование Базы данных ПК СВ (по умолчанию —

brest);в полях Пользователь БД и Пароль пользователя БД задать учетные данные пользователя Базы данных;

Примечание

Минимальные требования к паролю Пользователя БД:

длина не менее 12 символов;

наличие латинских букв и цифр.

в поле Имя лидера Raft задать имя лидера управления ПК СВ (Raft);

в поле Плавающий IP Raft указать плавающий IP-адрес кластера управления ПК СВ (Raft).

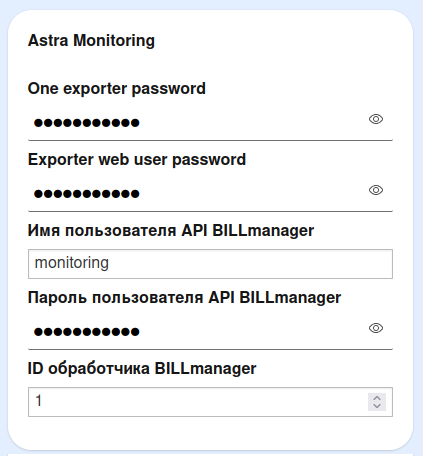

В блоке Astra Monitoring:

в поле One exporter password указать пароль пользователя

exporteruser. Этот пользователь будет через API получать данные для метрик AM;в поле Exporter web user password указать пароль пользователя

exporterwebuser. Этот пользователь будет получать данные для метрик с веб-интерфейса ПК СВ;Примечание

Пароли пользователей

exporteruserиexporterwebuserдолжны:состоять минимум из 8 символов;

содержать спецсимволы, цифры, буквы нижнего и верхнего регистра;

не содержать в себе следующие спецсимволы:

$,|,!,#,<,>,\,/,(,).

в полях Имя пользователя API BILLmanager и Пароль пользователя API BILLmanager указать учетные данные пользователя API BILLmanager;

в поле ID обработчика BILLmanager временно оставить значение по умолчанию.

Примечание

Идентификатор обработчика будет необходимо скорректировать после выполнения установки и настройки компонента BILLmanager.

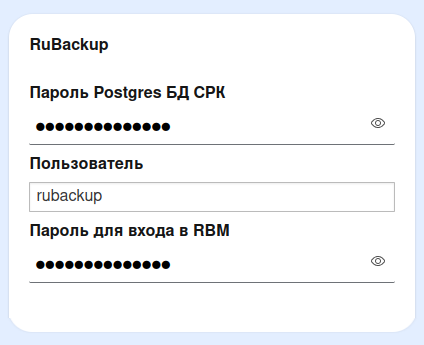

В блоке RuBackup в полях Пароль Postgress БД СРК, Пользователь и Пароль для входа в RBM задать учетные данные пользователя БД подсистемы RuBackup:

Примечание

Пароль для входа в RBM должен:

состоять минимум из 12 символов;

содержать минимум 1 цифру, а также 1 заглавную букву и минимум 1 специальный символ;

не содержать в себе следующие спецсимволы:

(,),!,$,|,/,\.

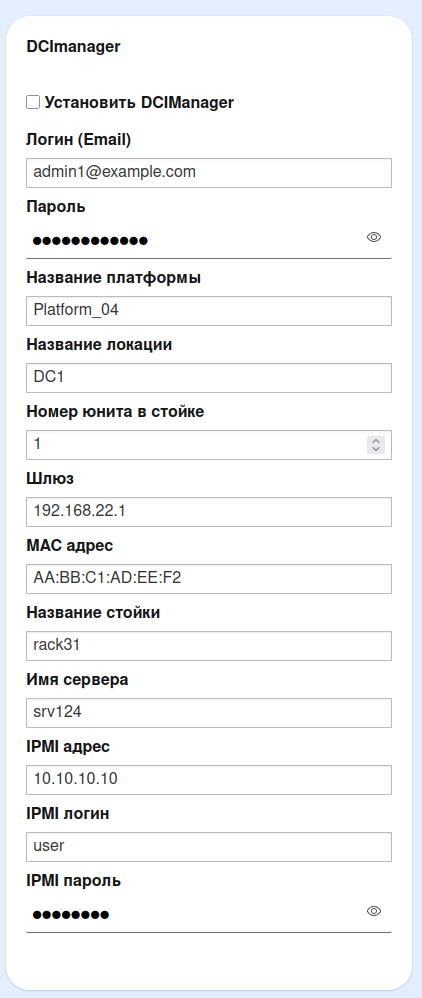

В блоке DCImanager:

при наличии необходимости в установке компонента DCImanager, в поле Установить DCIManager поставить флаг;

в поле Логин (Email) указать адрес электронной почты для подключения к DCImanager;

в поле Пароль задать ароль для подключения к DCImanager;

в поле Название платформы задать наименование платформы, на которой разворачивается DCImanager;

в поле Название локации задать наименование ЦОДа, либо места расположения оборудования;

в поле Номер Юнита в стойке указать номер юнита, на котором, управляющий локацией, сервер;

в поле Шлюз указать шлюз менеджмент сети (при создании ВМ шлюз не указывался, а он необходим для корректной работы DCImanager);

в поле MAC адрес задать MAC-адрес управляющего локацией сервера (интерфейса BMC);

в поле Название стойки указать наименование стойки, в которой должен располагаться управляющий локацией сервер;

в поле Имя сервера задать имя управляющего локацией сервера (сетевое имя сервера DCImanager);

Предупреждение

Имя сервера должно начинаться со строчной буквы латинского алфавита.

в полях IPMI адрес, IPMI логин и IPMI пароль задать данные для доступа к IPMI сервера:

Примечание

Все переменные, кроме

Логин (Email),ПарольиШлюз, являются шаблонными. Для развертывания DCImanager, при отсутствии подготовленных для него серверов, достаточно поменять только эти три переменные.В блоке BILLmanager в поле ID провайдера временно оставить значение по умолчанию.

Примечание

ID провайдера будет необходимо скорректировать после выполнения установки и настройки Портала самообслуживания (компонента BILLmanager).

Нажать на кнопку Продолжить в правом нижнем углу экрана:

В открывшемся окне Сводные данные проверить введенные данные и нажать на кнопку Установить в правой нижней части экрана:

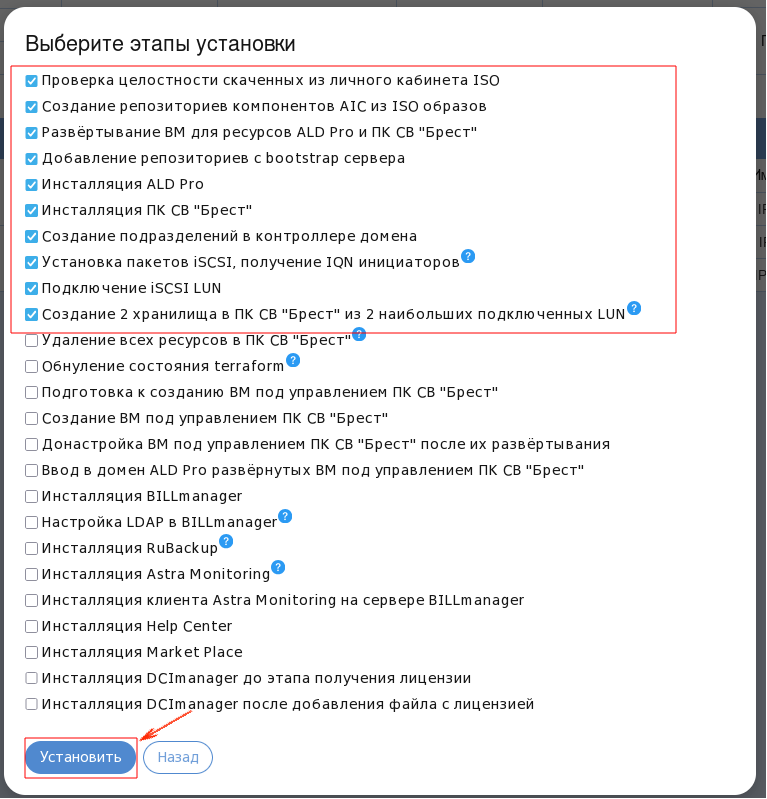

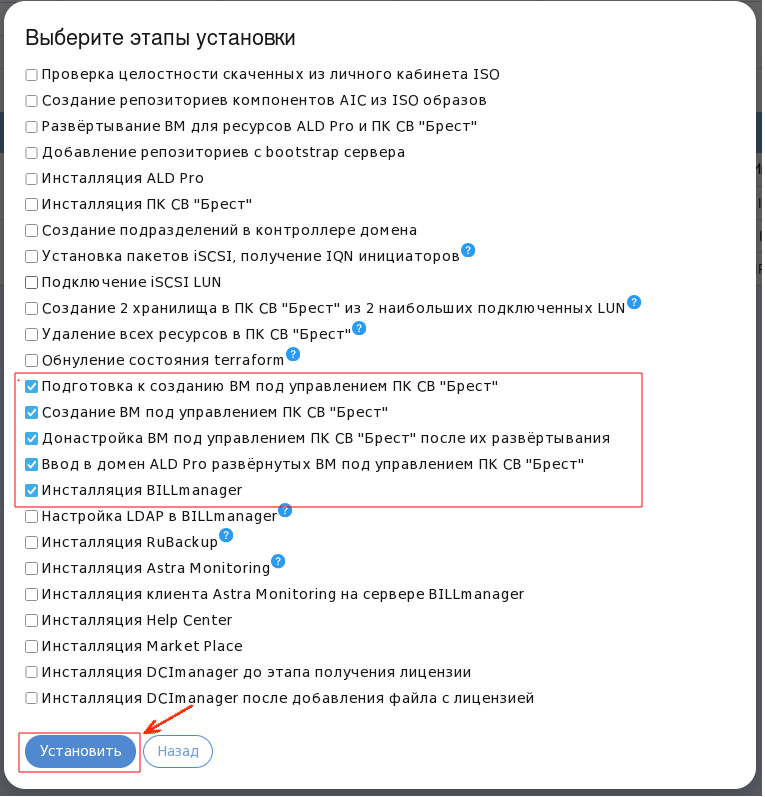

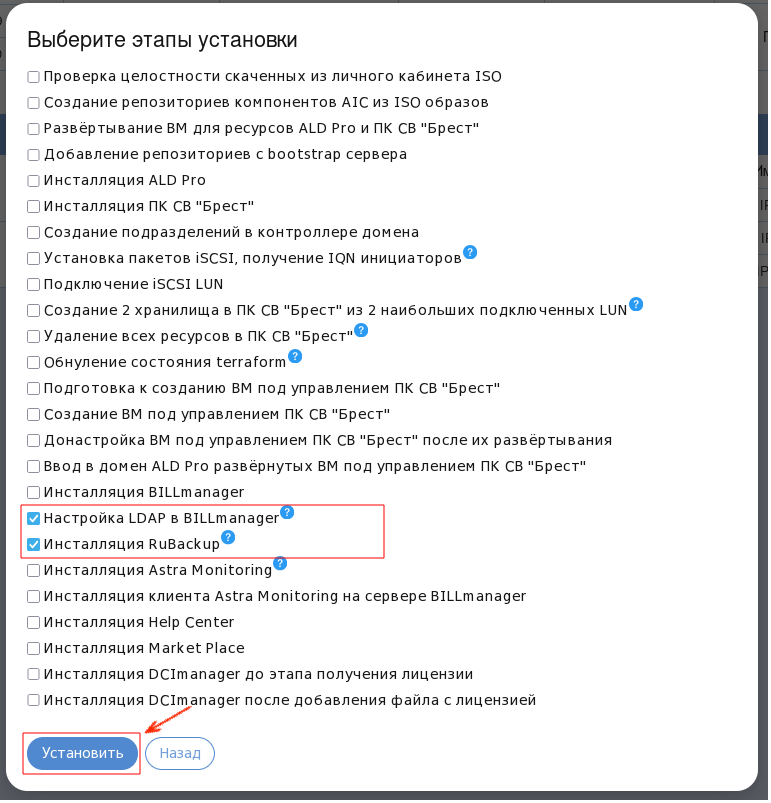

В открывшемся окне выбрать этапы установки AIC.

Этапы установки#

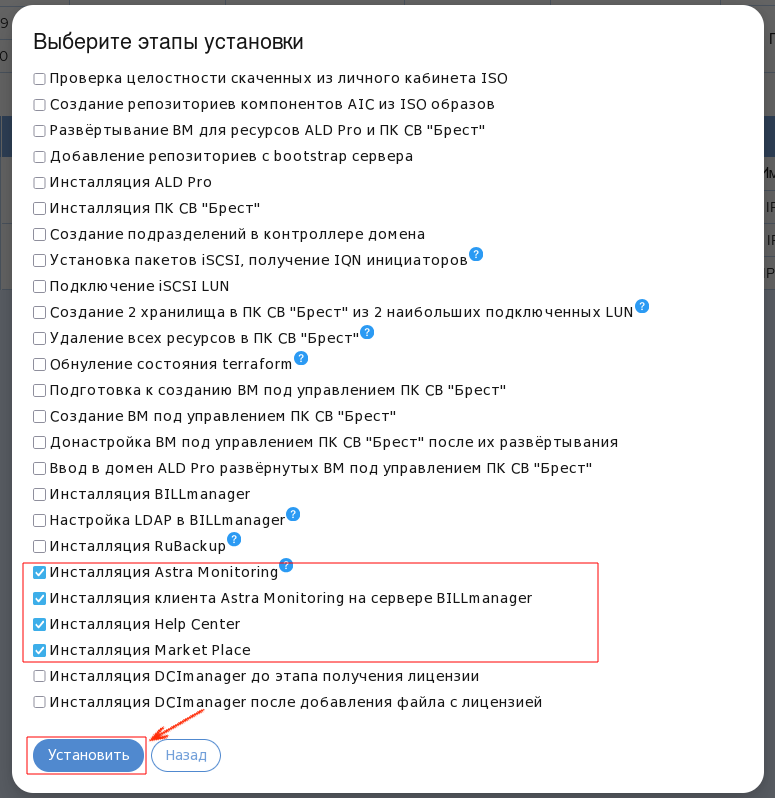

Ввиду необходимости выполнения ряда дополнительных настроек в процессе установки компонентов AIC, выбрать из списка все этапы за один раз не представляется возможным. Потому, этапы установки следует выбирать блоками.

Запуск первого блока этапов установки#

В выпадающем списке Этапы установки:

Отметить этапы установки, которые будут выполнены в первую очередь, а именно: пункты от Проверка целостности скаченных из личного кабинета ISO до Создание 2 хранилища в ПК СВ «Брест» из наиболее подключенных LUN.

Примечание

В случае, если для выдачи LUN на СХД необходимо предварительно настроить списки доступа IQN, следует снять флаг с пункта Подключение iSCSi LUN и выполнить соответствующие настройки вручную.

По завершении этапа Установка пакетов iSCSI, получение IQN инициаторов, сгенерированные IQN будут отображены в журнале установки.

В случае использования технологии multipath, подключение LUN-дисков должно быть выполнено вручную.

В случае выбора автоматического подключения и настройки iSCSI (этапы установки от Установка пакетов iSCSi, получение IQN инициаторов до Создание 2 хранилища в ПК СВ «Брест» из 2 наибольших подключенных LUN) необходимо учесть следующее:

во время работы автоматизации, на лидера RAFT будут скопированы два шаблона для хранилищ, выбраны два, наибольших по объему, подключенных iSCSI LUN, которые и будут использованы как хранилища для данных и образов ПК СВ;

Примечание

Так как используемые для хранилищ LUN должны быть пусты, в самом начале этого этапа автоматизации происходит проверка на наличие групп томов, физических томов и логических разделов. Если же LUN не пусты и на них есть какие-то компоненты LVM, автоматизация прекратит работу, сообщив о найденных компонентах LVM. Также будет выполнена проверка на идентичность размеров секторов, если размеры логических и физических секторов не будут идентичны, автоматизация остановится и выдаст сообщение об ошибке.

После проверки на наличие компонентов LVM выполняется очистка таблицы командой:

dmsetup

Из таблицы удаляются все записи о ранее созданных виртуальных блочных устройствах. Этот шаг необходим, поскольку при повторном использовании LUN, ранее задействованных в хранилище ПК СВ, наличие старых записей о виртуальных блочных устройствах может помешать их корректной инициализации как новых хранилищ.

ПК СВ не сразу определяет корректные параметры хранилищ, после подключения двух LUN следует подождать 5 минут, чтобы все хранилища корректно инициализировались.

при необходимости использовать хранилища типа LVM_LVM для создания из двух наибольших по размеру LUN хранилищ типа LVM_LVM, следует перейти в интерфейс командной строки сервера bootstrap и в директории

/home/astra/aic-codeвыполнить команду:task iscsi_lvm_lvm_datastore

Нажать на кнопку Установить.

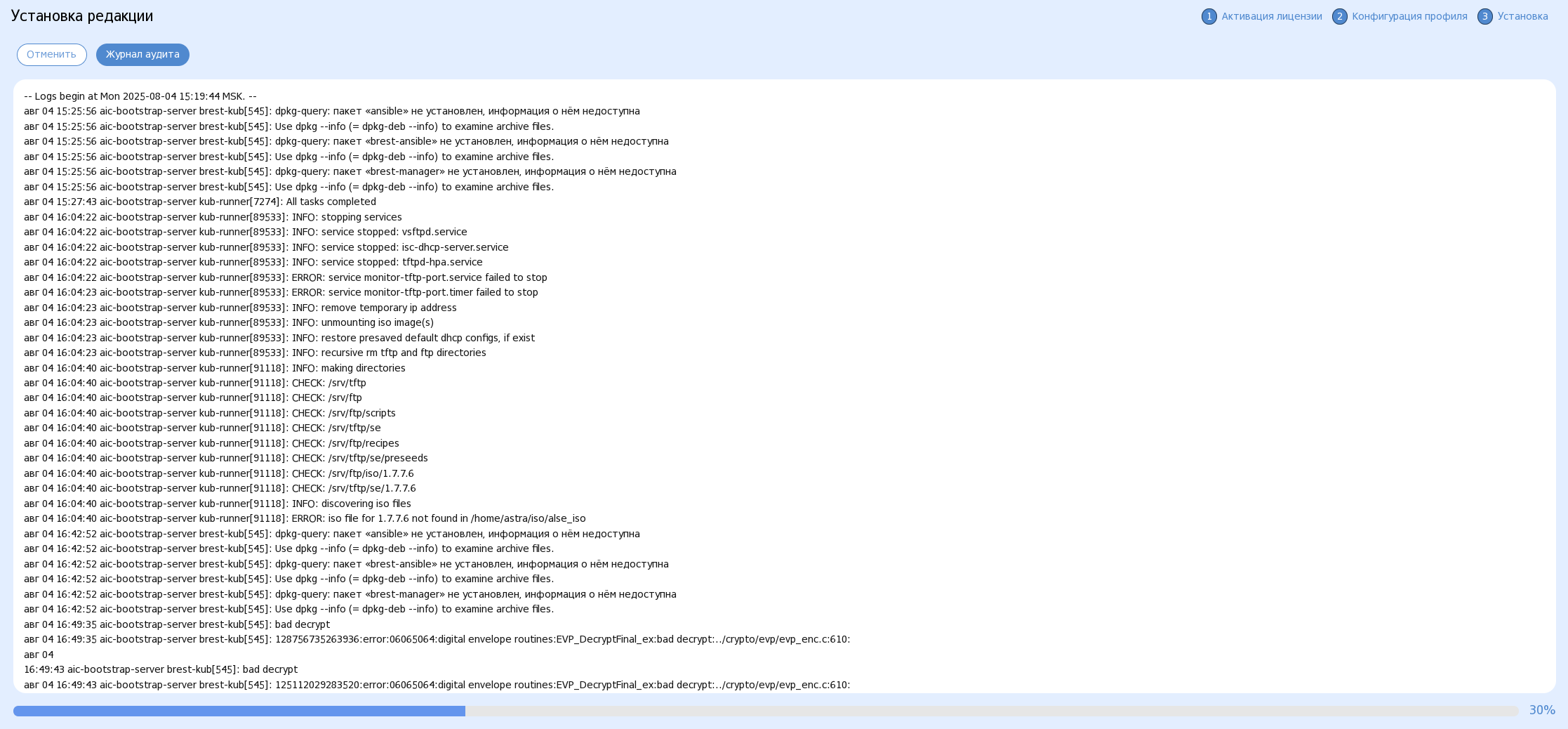

Процесс установки выбранных этапов будет запущен. На экране появится соответствующая информация, с указанием процентного соотношения выполненной работы:

По завершении работы Инсталлятора на экране появится сообщение следующего содержания:

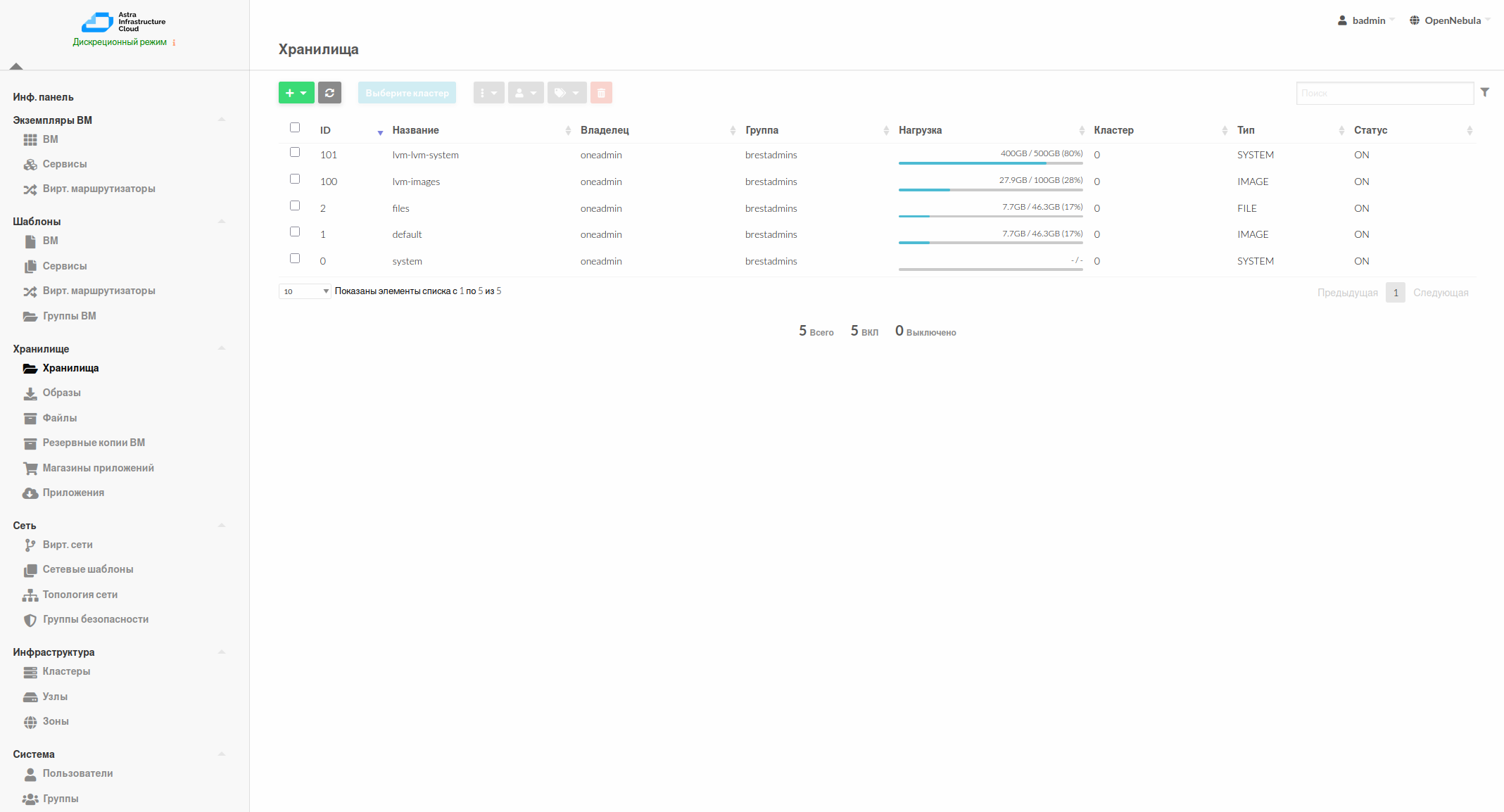

После завершения установки первого блока этапов необходимо подключиться к

Порталуадминистратора(компонент ПК СВ «Брест»), используя, заданный на этапе Конфигурация профиля Мастера установки, плавающий IP Raft (<IP_address_RAFT>) или Имя лидера Raft, авторизоваться, используя, заданные в Параметрах ПК СВ имя и пароль администратора, и проверить корректность создания хранилищ в подсистеме виртуализации.Примечание

В случае успешного создания хранилищ, следует сохранить скриншот с их идентификаторами, так как данная информация потребуются на этапе установки компонентов AIC.

Пример скриншота с идентификаторами хранилищ:

Запуск второго блока этапов установки#

После выполнения проверки создания Хранилищ в Портале администратора, выполнить повторный запуск Мастера Установки.

В блоке Локальные ВМ, ресурсы ПК СВ «Брест» окна Ресурсы: сетевые, локальные, Брест скорректировать поля ID хранилища образов и ID хранилища данных, указав идентификаторы, полученные по итогам установки первого блока этапов:

Остальные переменные необходимо оставить без изменений.

В списке этапов установки отметить пять следующих этапов: от Подготовка к созданию ВМ под управлением ПК СВ «Брест» до Инсталляция BILLmanager, нажать на кнопку Установить:

Инсталлятор приступит к созданию необходимых ресурсов для разворачивания компонентов AIC и установки Портала самообслуживания (компонента BILLmanager).

Итогом работы автоматизации будет установленное ПО BILLmanager редакции «Hosting&Cloud». После завершения его установки необходимо перейти к настройке Портала самообслуживания, выполнив следующие действия:

Активировать лицензию Портала самообслуживания. Для этого:

Подключиться по SSH к ВМ, выполнив в интерфейсе командной строки команду:

ssh <имя_сервисного_пользователя>@<IP_адрес_портала>Где:

<имя_сервисного_пользователя>— имя сервисного пользователя, заданного на этапе Сетевая установка ОС;<IP_адрес_портала>— IP-адрес компонента BILLmanager, заданный на этапе Инфраструктура.

Получить идентификатор установки

inode_id, выполнив команду:sudo -i ls -i /usr/local/mgr5/etc/billmgr.lic | cut -d' ' -f1

Пример вывода после выполнения команды:

locadm@bill-manager:~$ sudo -i ls -i /usr/local/mgr5/etc/billmgr.lic | cut -d' ' -f1 427636 locadm@bill-manager:~$

Примечание

Значение

inode_idтак же будет сохранено в файлеinode_id.txtв домашней директории пользователя на ВМ, где был развернут BILLmanager.Запросить лицензию в Личном кабинете ISPsystem , либо в службе технической поддержки ISPpsystem, указав значение

inode_id, а также номер приобретенной лицензии. Лицензия имеет длину около 2000 символов.Примечание

Номер лицензии и сама лицензия — это две разные сущности.

После получения лицензии на сервере с установленным BILLmanager, от пользователя

rootвыполнить команду:sudo echo <содержимое_файла_полученной_лицензия> > /usr/local/mgr5/etc/billmgr.lic

Предупреждение

Необходимо выполнять именно команду

echo. Использовать текстовые редакторы для добавления лицензии в файл не допускается.Использование текстовых редакторов изменит уникальный номер инсталляции

inode_id.Веб-интерфейс BILLmanager не будет доступен до активации лицензии.

Выполнить перезапуск Портала самообслуживания командой:

/usr/local/mgr5/sbin/mgrctl -m billmgr -R

Примечание

В конце инсталляции на сервер с BILLmanager в файл

/etc/hostsбудет добавлена строка:127.0.0.1 download.ispsystem.com

Данная запись ускорит работу веб-интерфейса BILLmanager в среде без выхода в интернет. В случае, если у сервера с BILLmanager есть выход в интернет, — строку необходимо удалить либо закомментировать.

В случае, если BILLmanager будет переустановлен на этой же ВМ, запись нужно будет предварительно удалить.

Сменить пароль пользователя

rootдля входа в Портал самообслуживания через графический интерфейс, выполнив команду:sudo passwdЕсли пароль не был задан вручную, (по умолчанию пароль для пользователя

rootне задается), его необходимо задать на данном этапе.Примечание

По завершении работы автоматизации, на сервер с BILLmanager в файл

/etc/hostsбудет добавлена запись:127.0.0.1 download.ispsystem.comДанная запись ускорит работу веб-интерфейса BILLmanager в закрытом контуре. В случае установки AIC в открытом контуре, — данную запись необходимо удалить либо закомментировать.

Для входа в веб-интерфейс Портала самообслуживания, после активации лицензии необходимо перейти в браузере по адресу ВМ с установленным BILLmanager:

https://<IP>/billmgr?func=logonПримечание

Также для входа на портал самообслуживания вместо IP-адреса может быть использовано доменное имя его сервера.

В открывшемся интерфейсе Портала самообслуживания ввести, ранее заданные, учетные данные пользователя

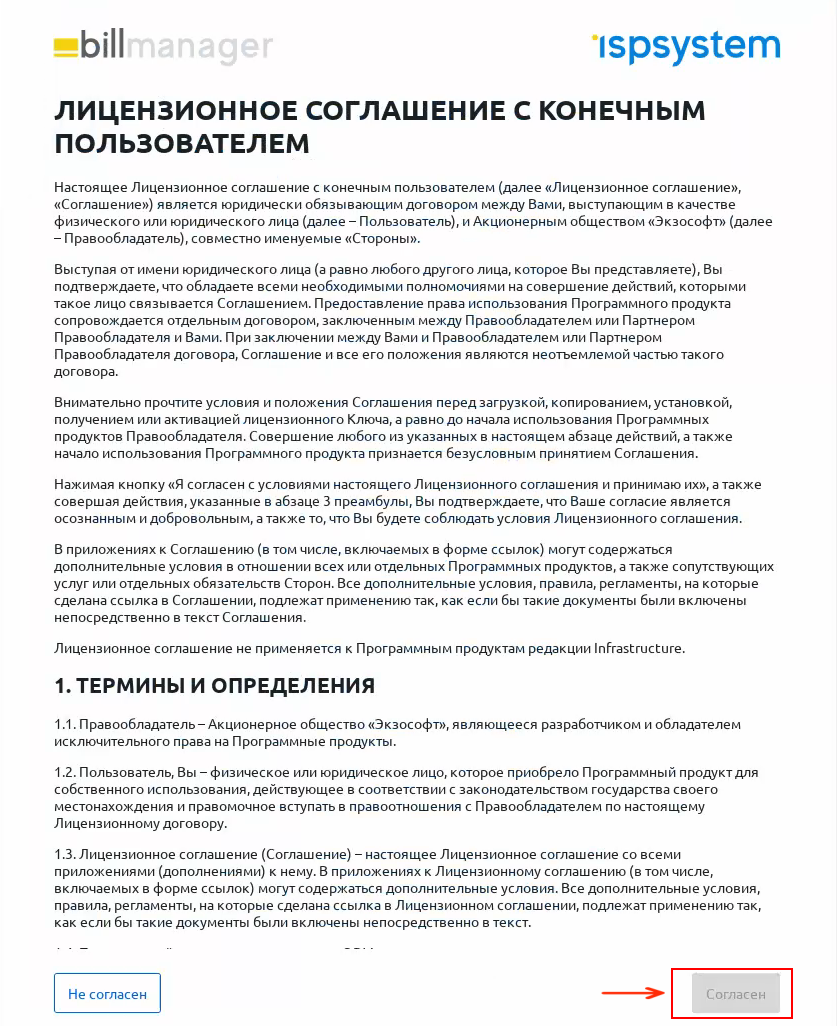

rootи нажать кнопку Войти:

Ознакомиться с условиями Лицензионного соглашения и нажать на кнопку Согласен в правой нижней части экрана:

Выполнить настройку Портала обслуживания. Для этого:

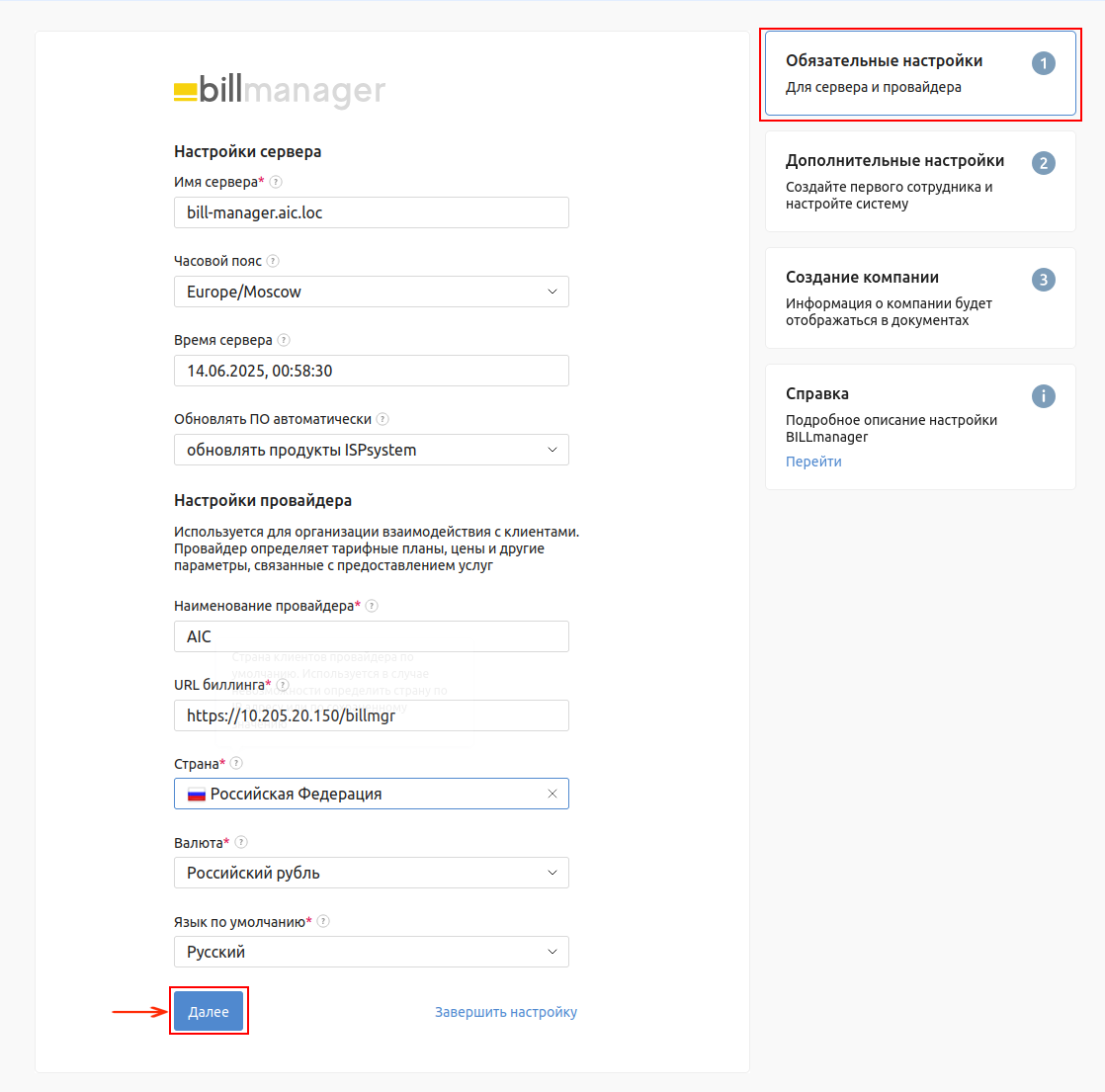

В открывшемся окне вкладки Обязательные настройки:

в поле Имя сервера указать имя сервера Портала самообслуживания;

в поле Часовой пояс в выпадающем списке выбрать соответствующий часовой пояс;

поле Время сервера будет заполнено автоматически, в соответствии с указанным часовым поясом;

в поле Обновлять ПО автоматически в выпадающем списке выбрать оптимальный вариант;

в поле Наименование провайдера задать название провайдера;

в поле URL биллинга сохранить значение по умолчанию;

в поле Страна в выпадающем списке выбрать соответствующую страну;

в поле Валюта в выпадающем списке выбрать валюту для расчетов;

в поле Язык по умолчанию в выпадающем списке выбрать требуемый язык;

нажать на кнопку Далее:

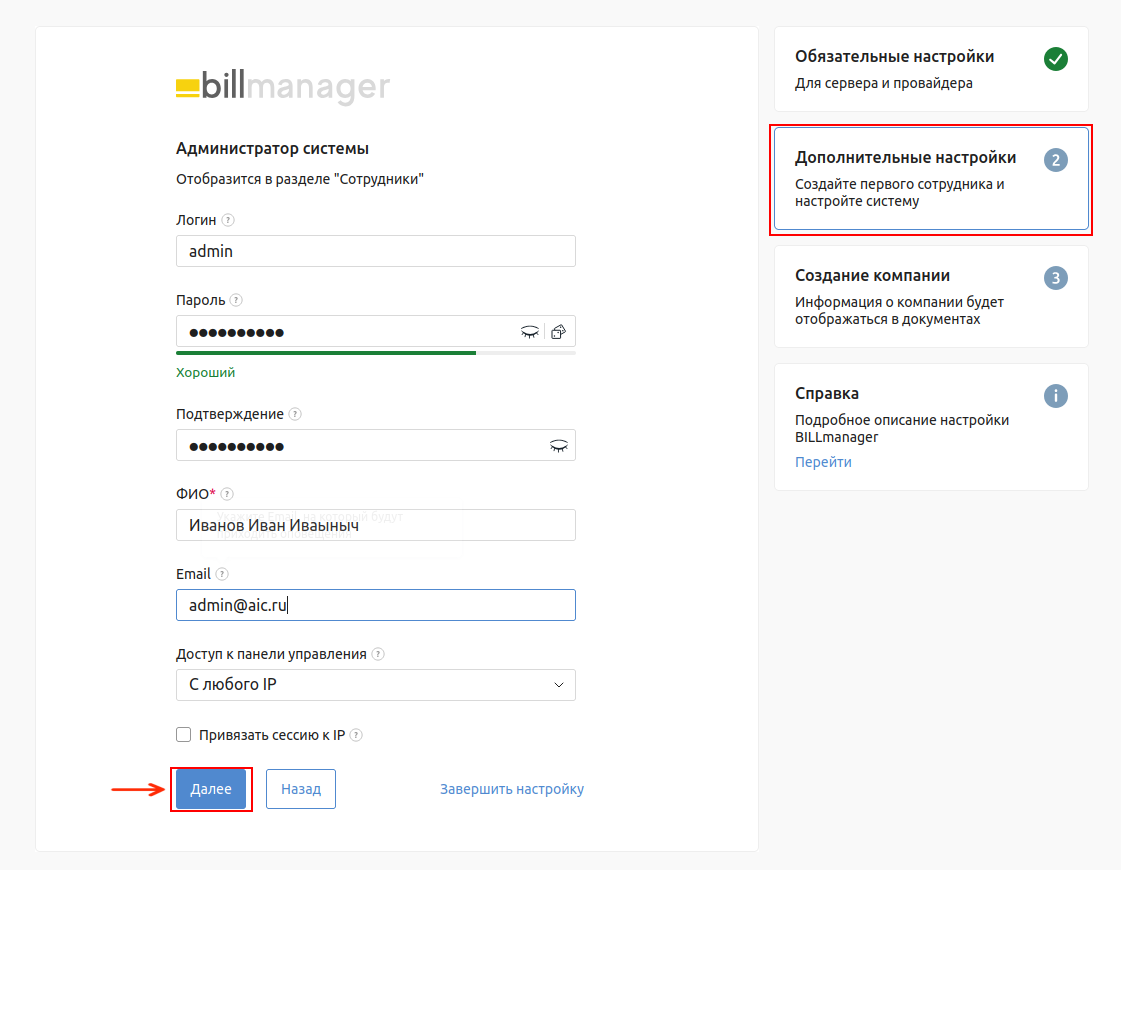

В открывшемся окне вкладки Дополнительные настройки:

в полях Логин, Пароль и Подтверждение указать учетные данные Пользователя;

в полях ФИО и Email указать контактные данные Пользователя;

в поле Доступ с панели управления в выпадающем списке выбрать оптимальное значение;

если необходимо привязать сессию к IP, поставить соответствующий флаг;

нажать на кнопку Далее:

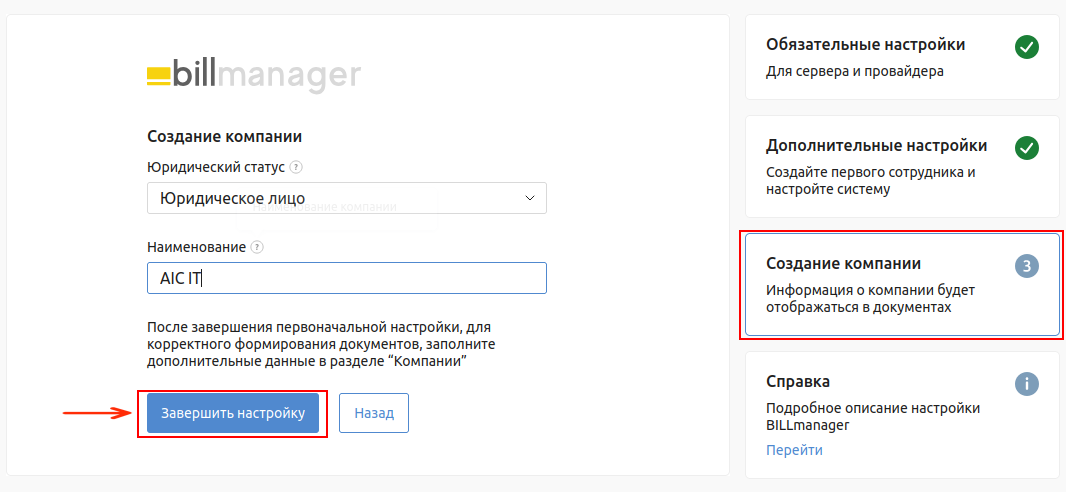

В открывшемся окне вкладки Создание компании:

в поле Юридический статус в выпадающем списке выбрать соответствующий статус;

в поле Наименование указать название компании;

нажать на кнопку Завершить установку:

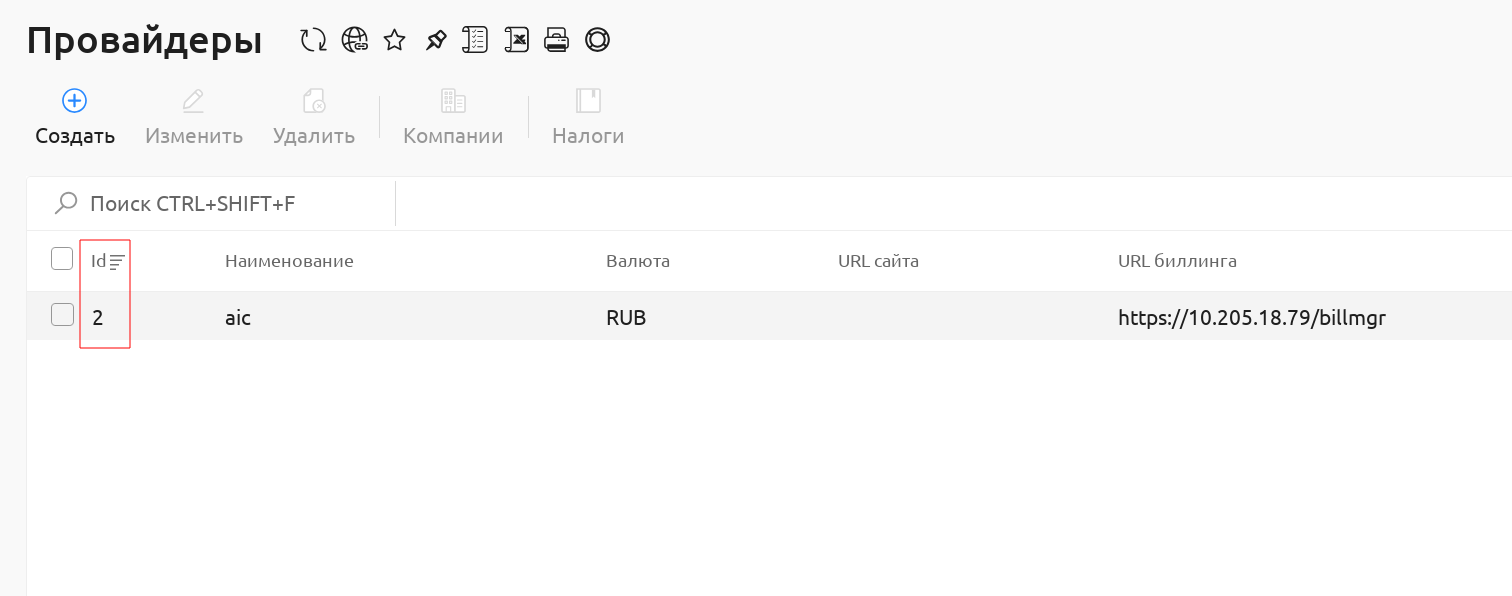

Получить ID провайдера, выполнив следующие действия:

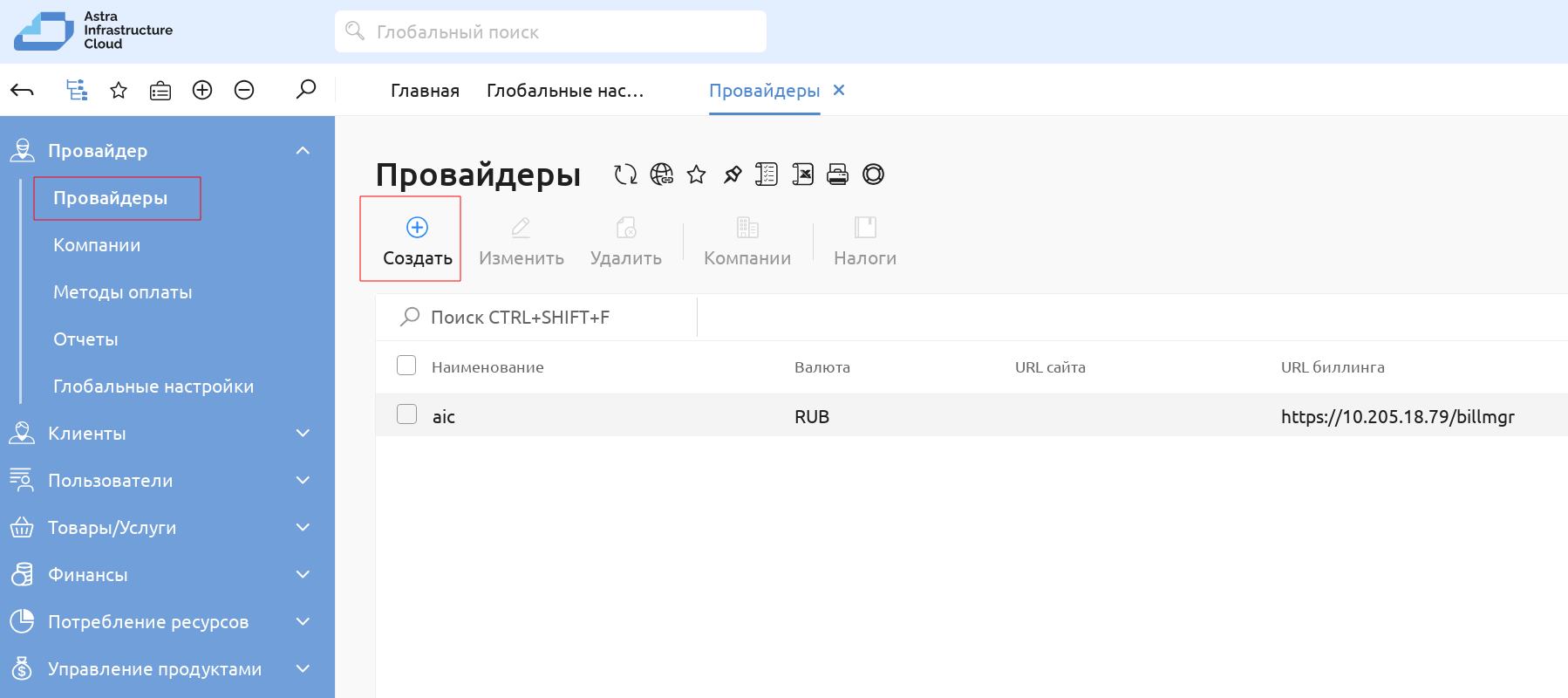

создать Провайдера, который будет использоваться для интеграции с ПК СВ. Для этого:

во вкладке Провайдер — Провайдеры основного меню слева Портала самообслуживания нажать на кнопку Создать:

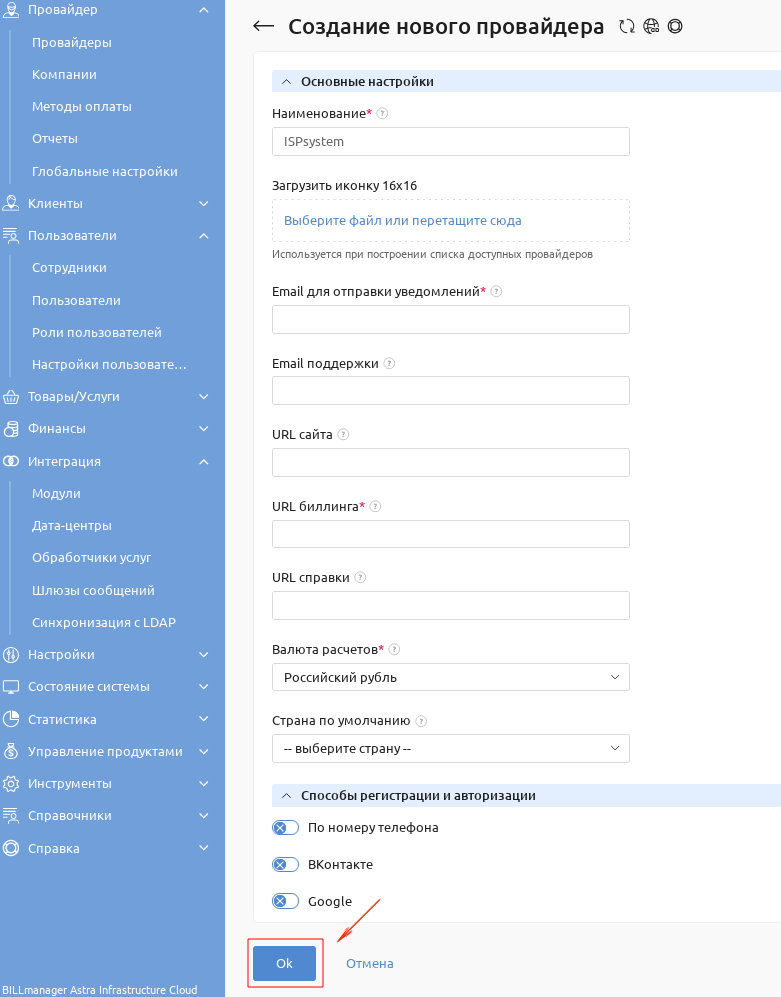

в открывшемся окне Создание нового провайдера задать наименование нового провайдера, e-mail для отправки уведомлений, URL биллинга и валюту расчетов. Остальные поля не обязательны к заполнению и могут остаться пустыми. Нажать на кнопку ОК:

Примечание

Создание провайдера не является обязательным шагом. Может быть использован провайдер, созданный системой по умолчанию.

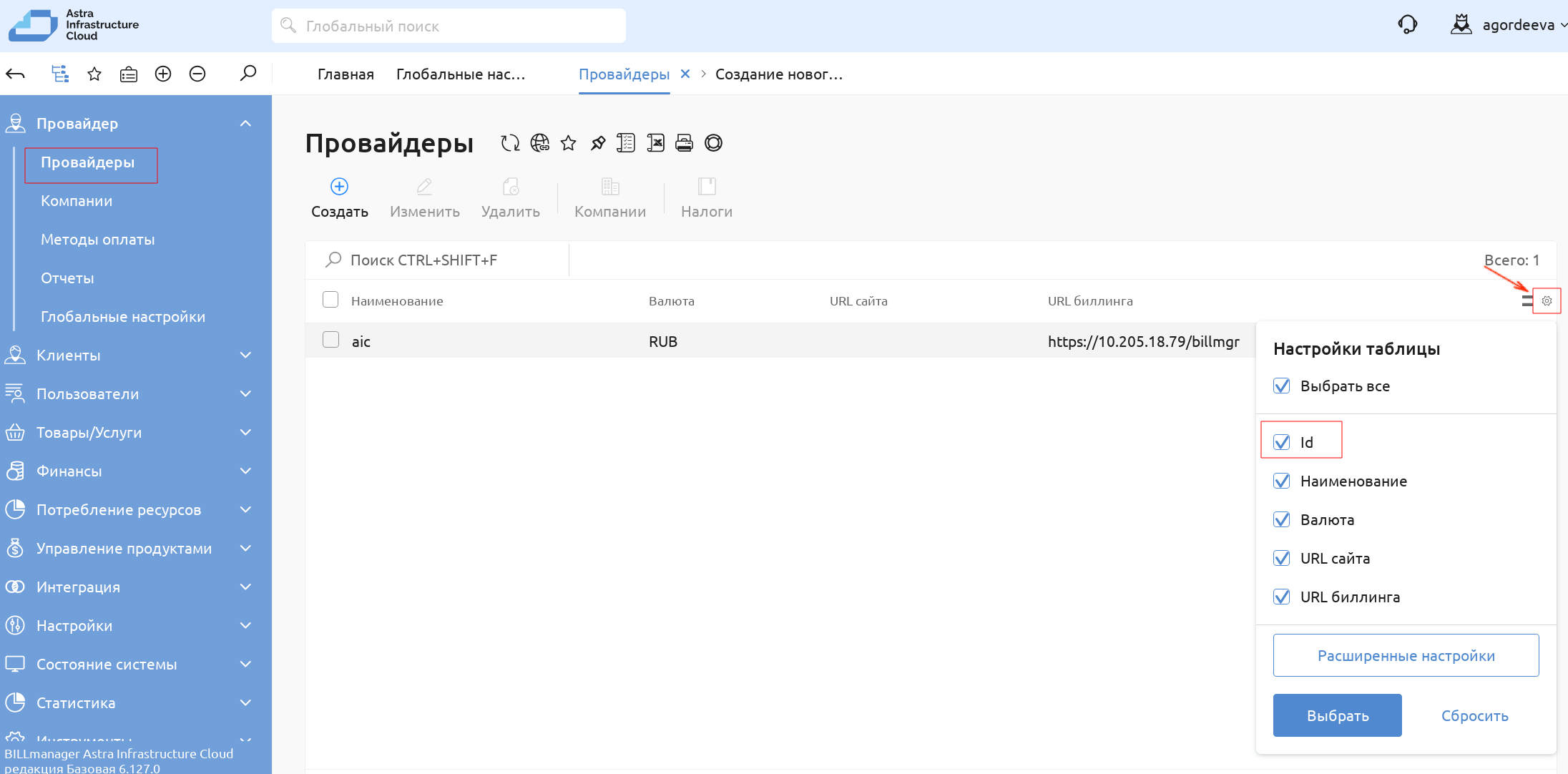

для отображения ID Провайдера в таблица свойств всех провайдеров во вкладке Провайдер — Провайдеры в меню Настройка таблицы включить отображение параметра

ID. Нажать на кнопку Найти:

Таблица свойств провайдеров будет дополнена столбцом с их идентификаторами:

Запуск третьего блока этапов установки#

После получения идентификатора провайдера, выполнить повторный запуск Мастера Установки.

В блоке BILLmanager окна Ключевые параметры скорректировать поле ID провайдера, указав идентификатор, полученный по итогам установки второго блока этапов:

Остальные переменные необходимо оставить без изменений.

В списке этапов установки отметить два следующих этапа: Настройка LDAP в BILLmanager и Инсталляция Rubackup, нажать на кнопку Установить:

Запуск четвертого блока этапов установки#

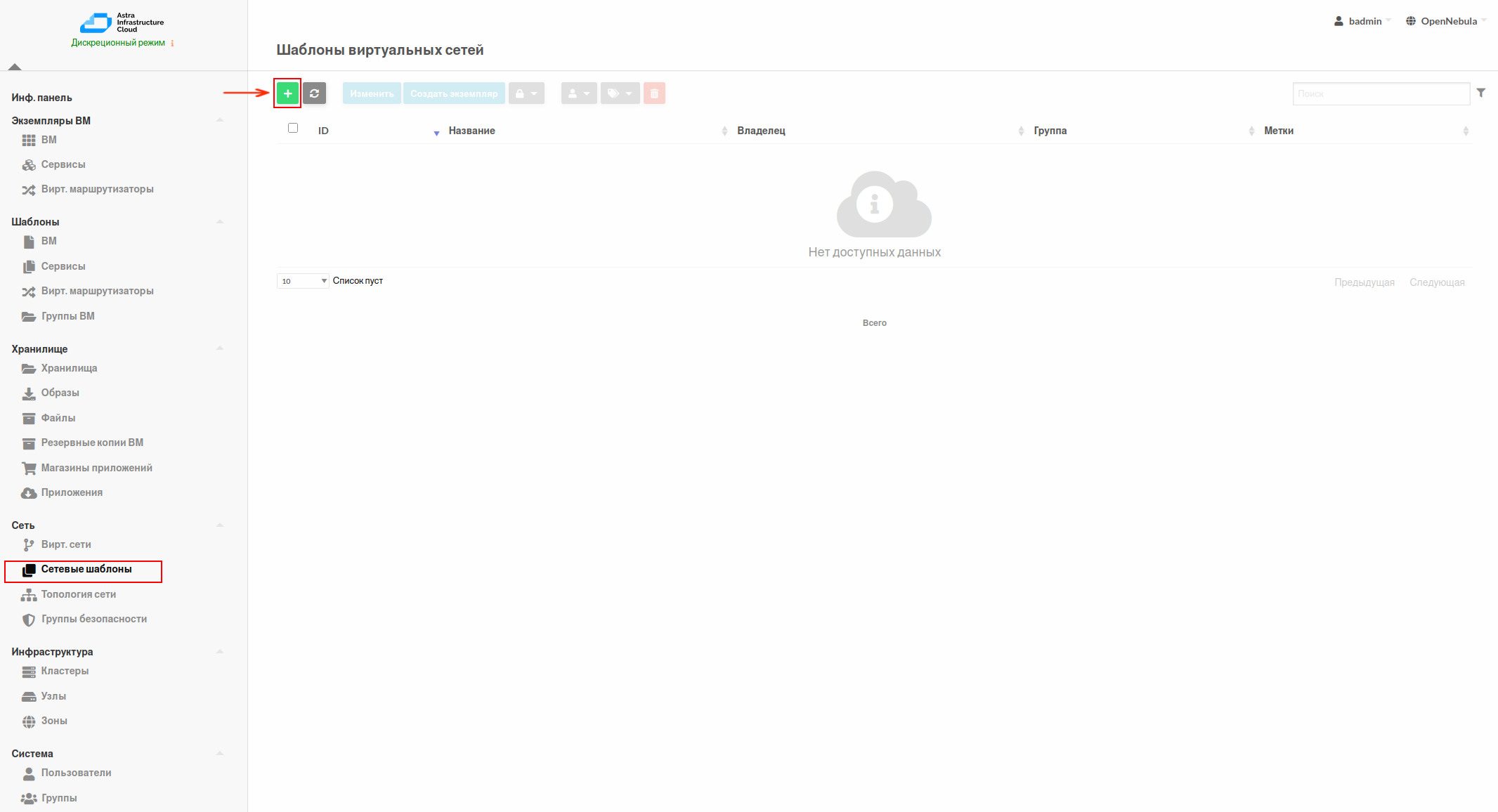

После завершения работы Мастера установки выполнить настройки для подключения Подсистемы мониторинга (компонента Astra Monitoring). Для этого на Портале самообслуживания необходимо создать сущности

ОбработчикиСотрудник. Перед созданием Обработчика необходимо создать шаблон виртуальной сети на Портале администратора, он должен быть создан пользователем с административными правами.Примечание

Установка клиентской части Astra Monitoring на сервере с BILLmanager вынесена в отдельный шаг, так как она требует наличия отдельного обработчика и сотрудника на Портале самообслуживания, создание которых доступно только после активации лицензии BILLmanager.

Порядок действий на данном этапе:

На Портале администратора выбрать пункт основного меню слева Сеть — Сетевые шаблоны и в открывшемся окне Шаблоны виртуальных сетей нажать на кнопку +:

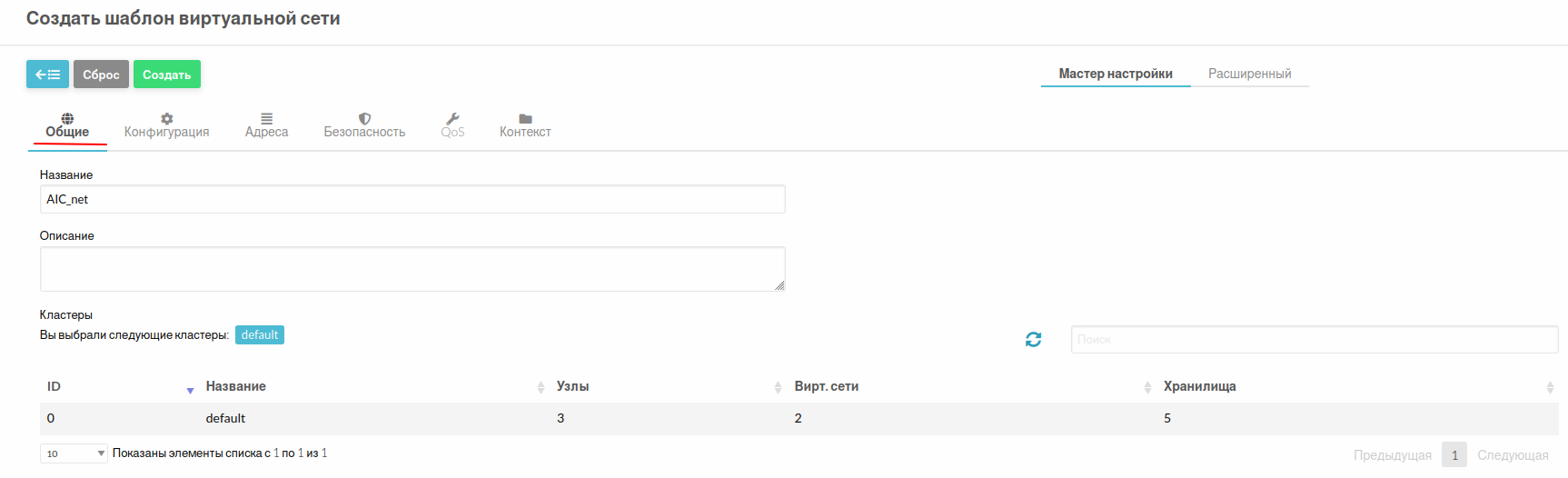

В открывшемся окне Создать шаблон виртуальной сети во вкладке Общие:

В поле Название указать название создаваемого шаблона.

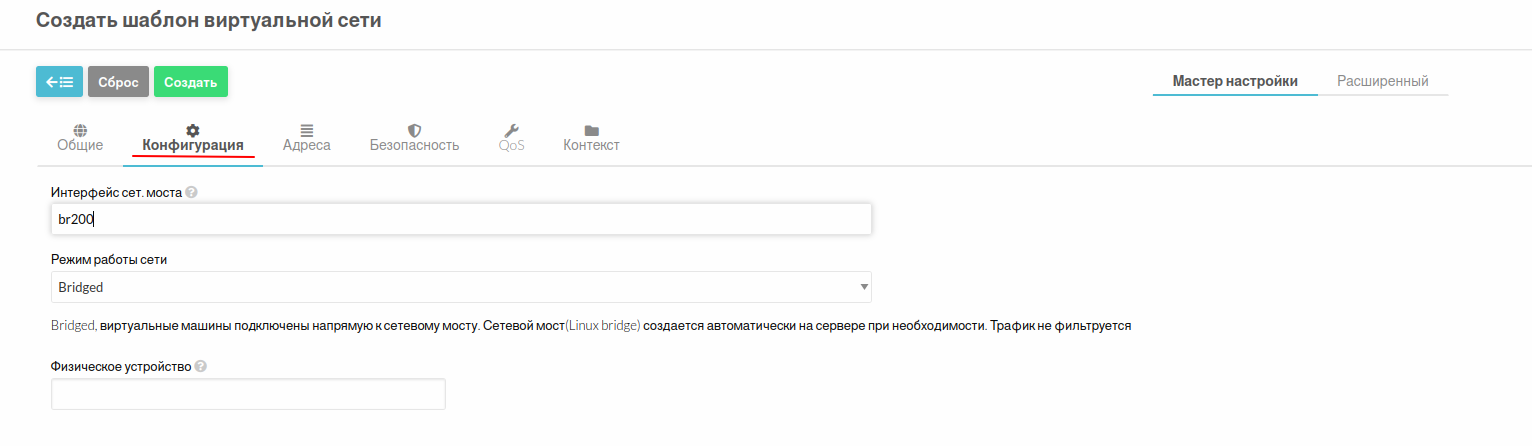

Во вкладке Конфигурация:

В поле Интерфейс сет. моста указать наименование сетевого моста менеджмент сети.

В поле Режим работы сети в выпадающем списке выбрать значение Bridged:

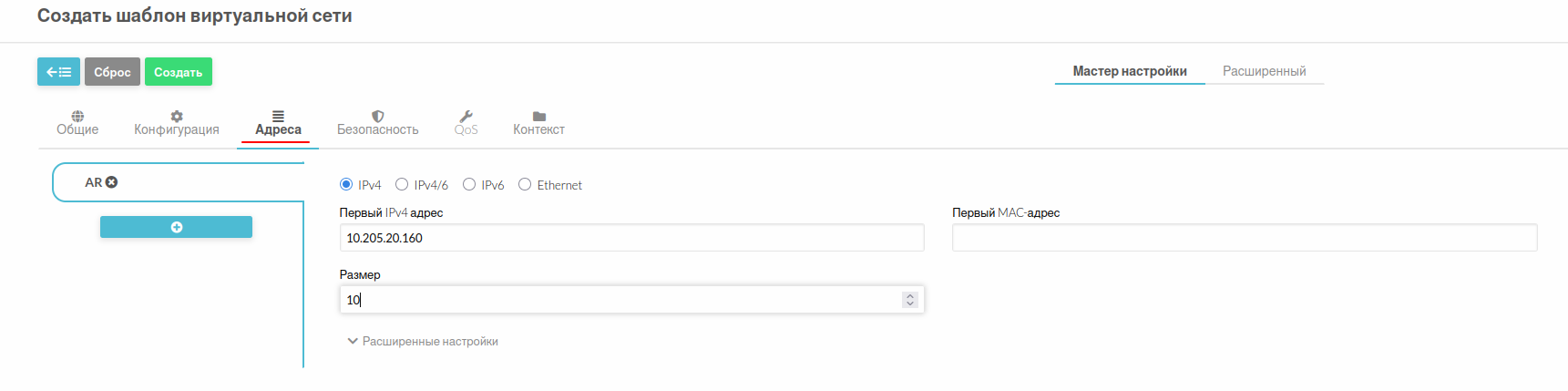

Во вкладке Адреса указать IP-адрес сети и ее емкость:

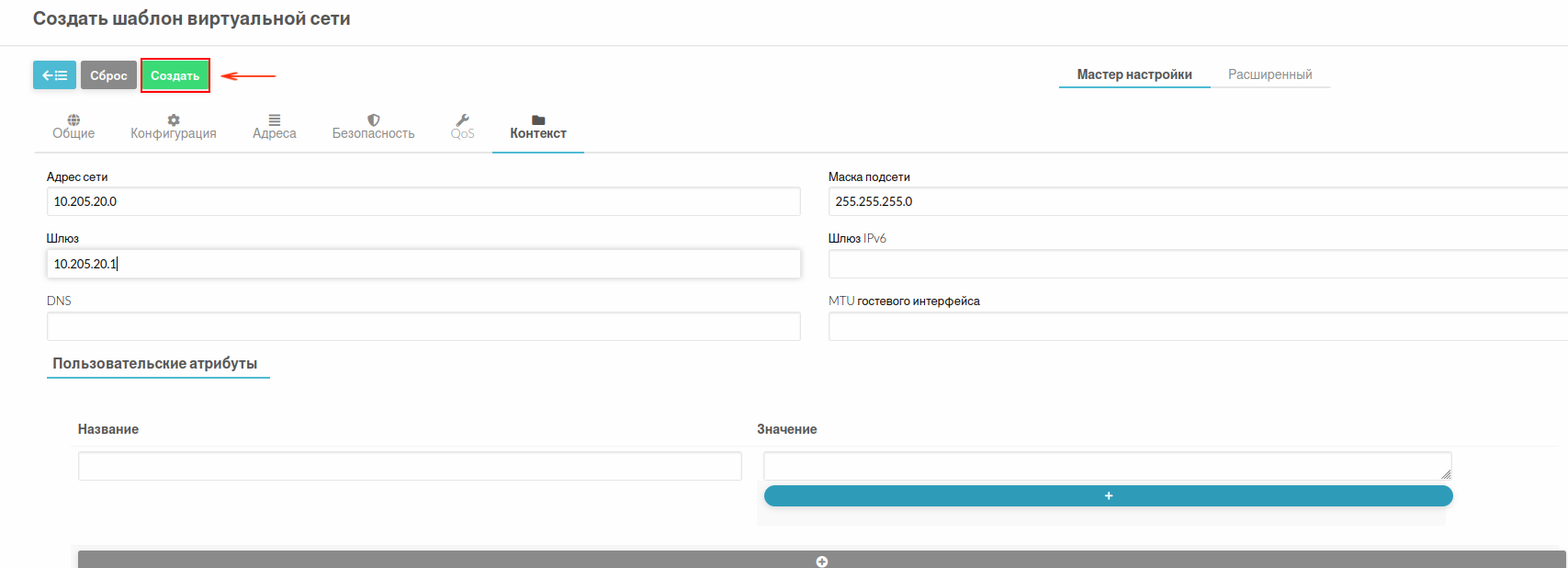

Во вкладке Контекст указать данные сети: адрес сети, маску и шлюз. Нажать на кнопку Создать:

Примечание

Заполнение разделов Безопасность и Qos не является обязательным.

Шаблон виртуальной сети будет создан.

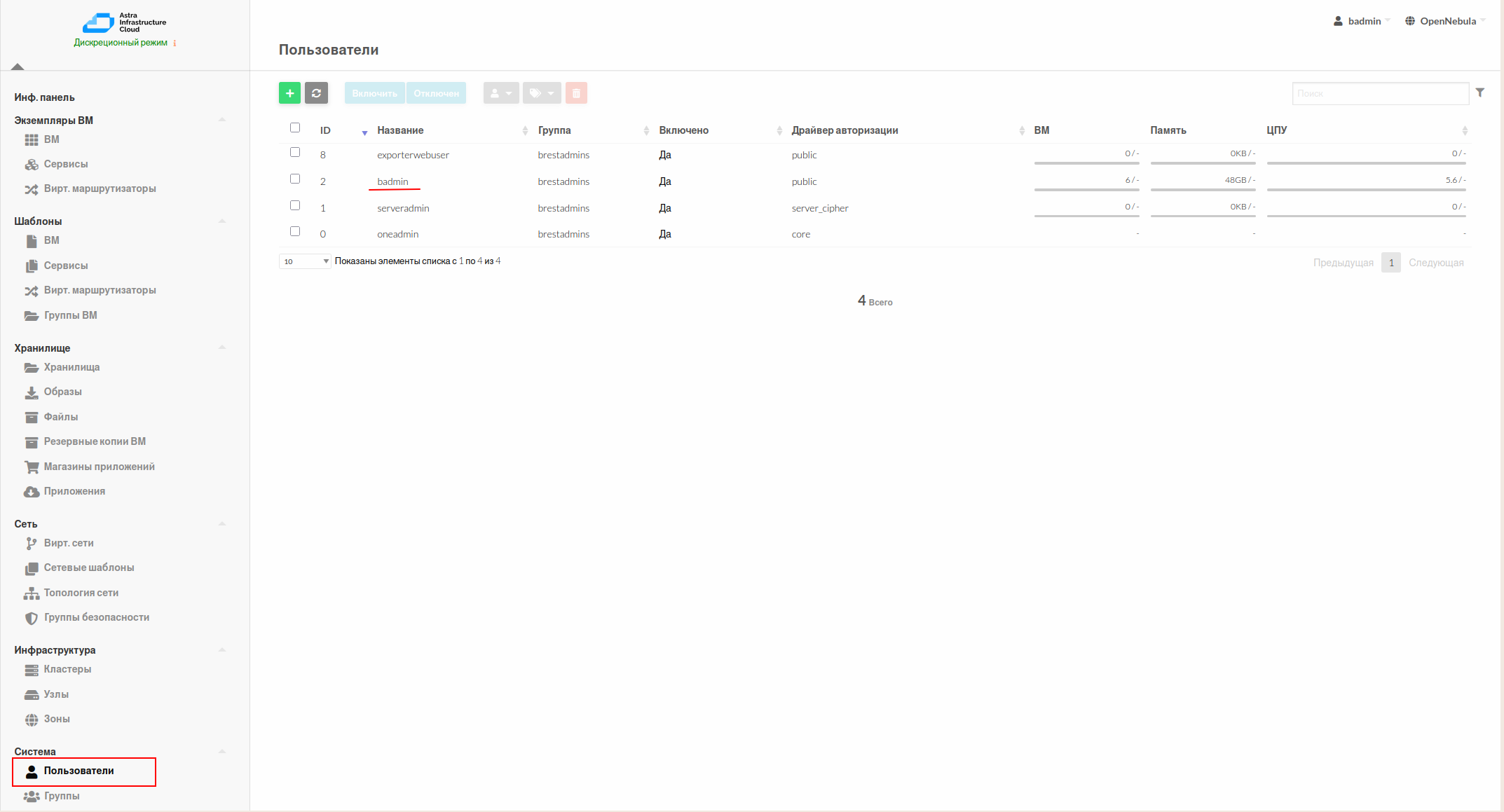

Получить токен администратора для подсистемы виртуализации. Для этого:

Перейти на вкладку Пользователи основного меню слева и в открывшемся окне выбрать из списка пользователей администратора подсистемы виртуализации:

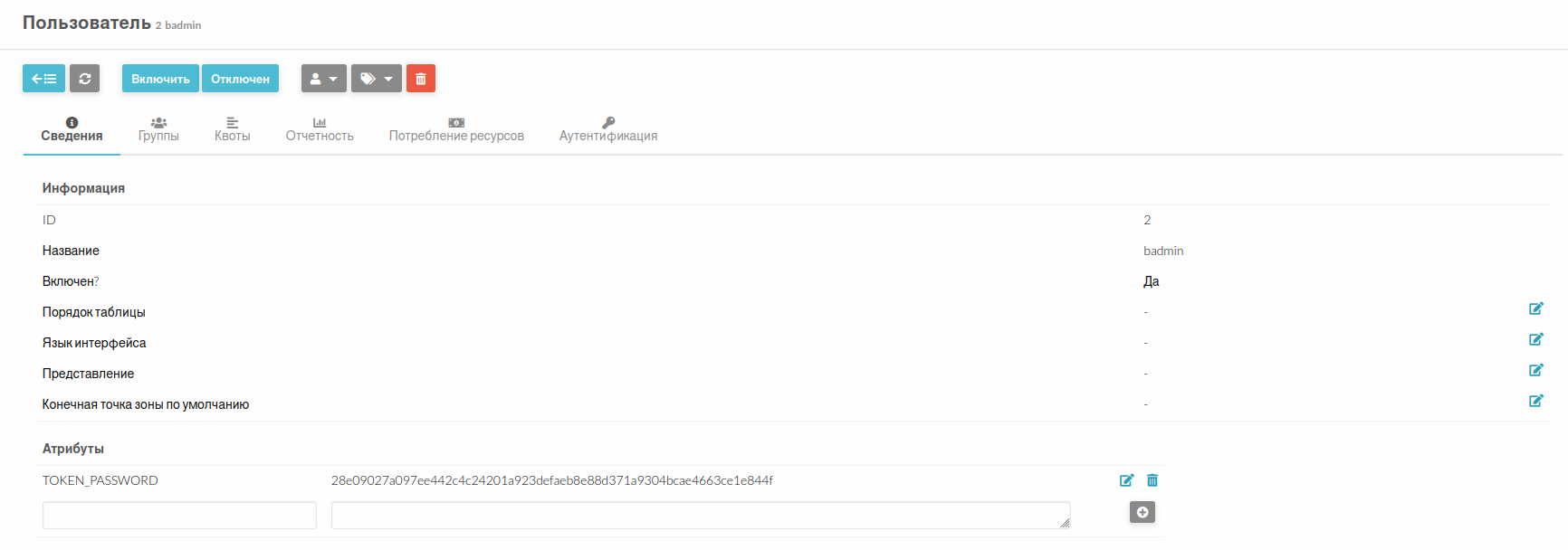

Перейти в свойства данного пользователя:

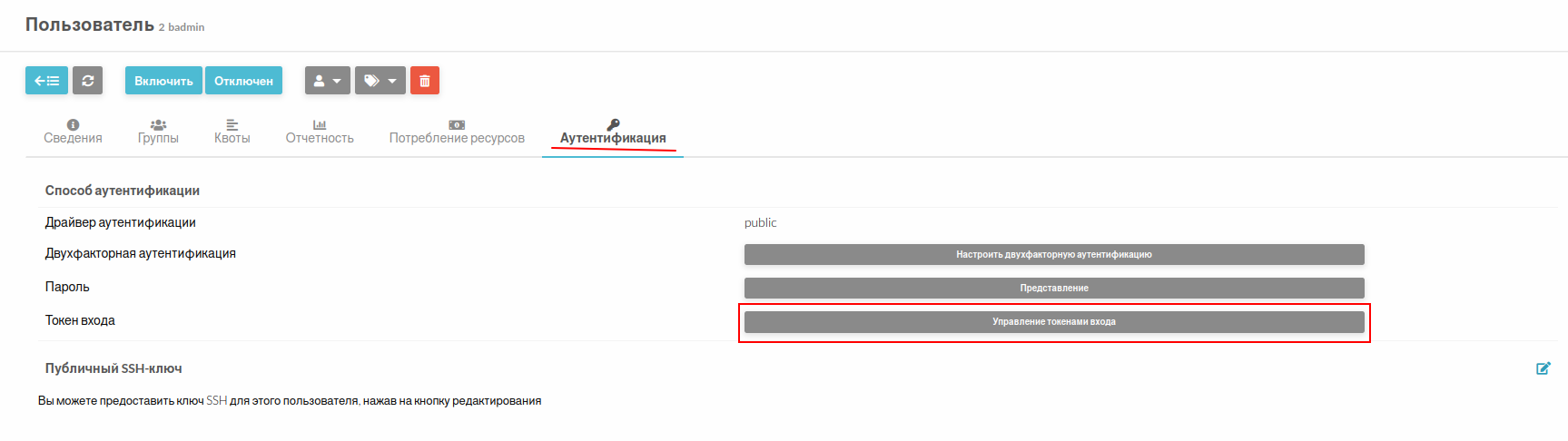

с. В открывшемся окне свойств пользователя перейти во вкладку Аутентификация и нажать кнопку Управление токенами входа:

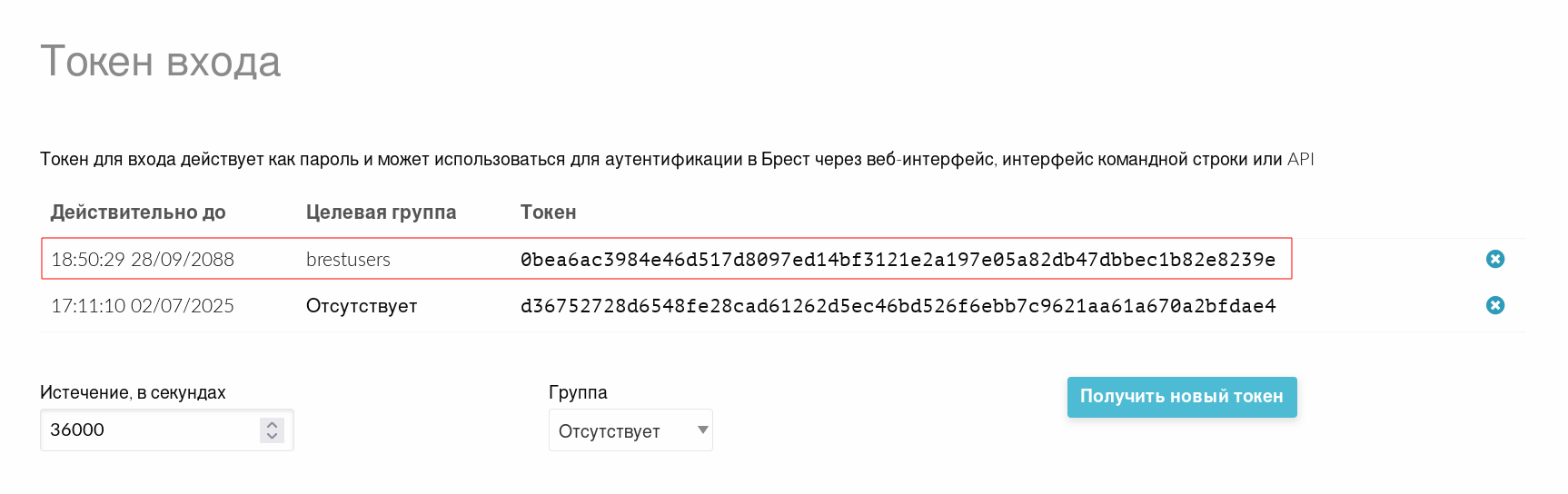

Скопировать из списка токенов наиболее подходящий:

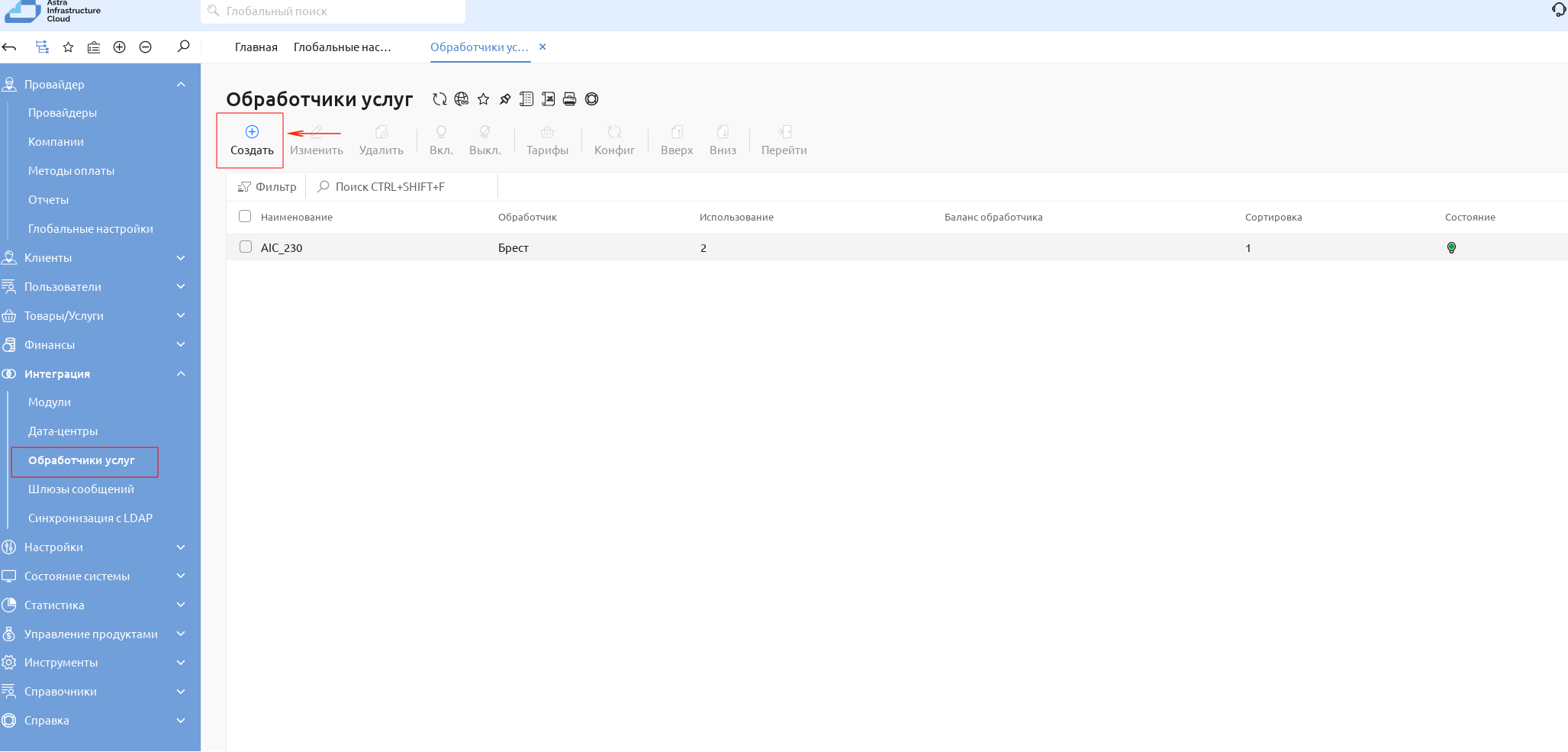

Создать Обработчик интеграции Портала самообслуживания с Порталом администратора. Для этого на Портале самообслуживания выполнить следующие действия:

Во вкладке Интеграция — Обработчики услуг основного меню слева нажать на кнопку + в верхней левой части экрана:

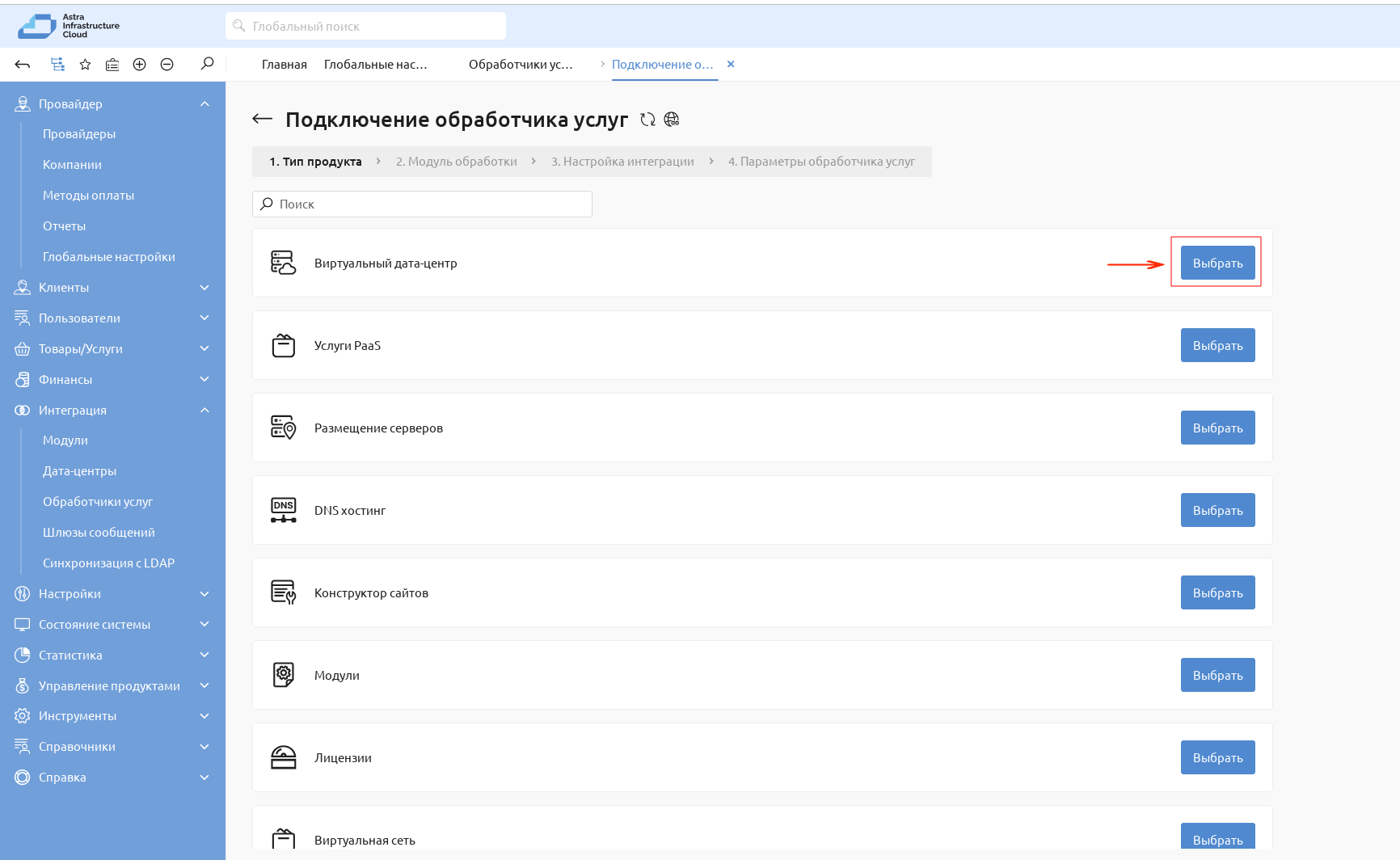

В открывшемся окне вкладки Тип продукта выбрать Виртуальный дата-центр:

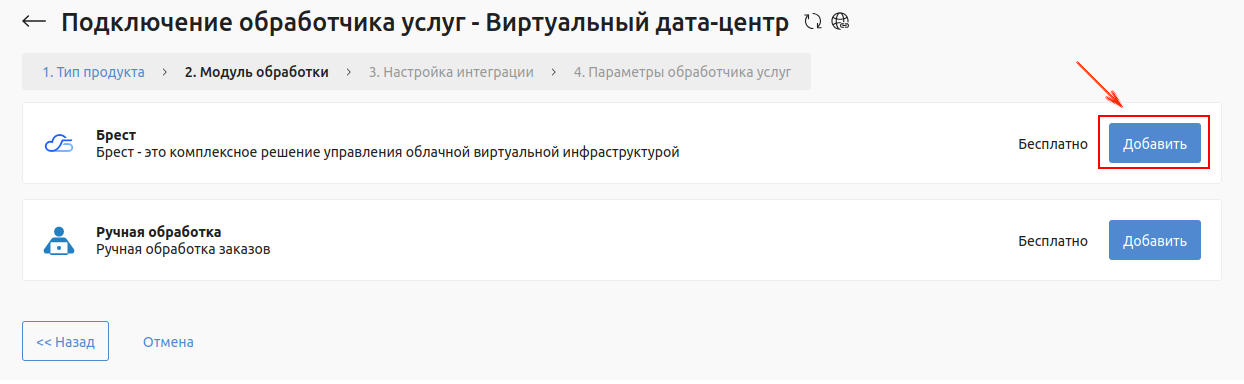

В открывшемся окне вкладки Модуль обработки выбрать

Брест, нажав на кнопку Добавить:

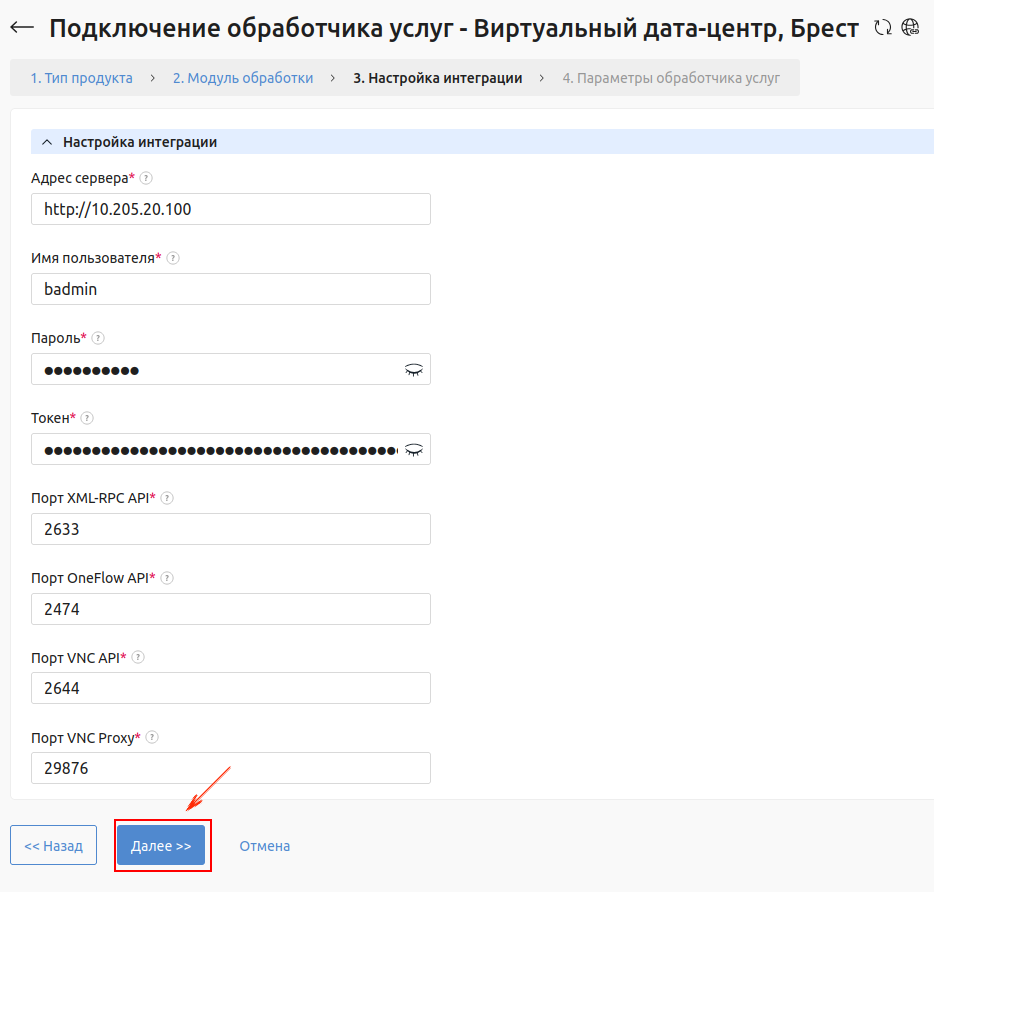

В открывшемся окне Настройка интеграции заполнить данные обработчика:

В поле Адрес сервера указать адрес RAFT ПК СВ с протоколом «http».

В полях Имя пользователя и Пароль указать учетные данные администратора ПК СВ.

В поле Токен указать ранее скопированный токен администратора ПК СВ.

В полях Порт XML-RPC API, Порт OneFlow API, Порт VNC API и Порт VNC Proxy оставить значения по умолчанию.

Нажать на кнопку Далее:

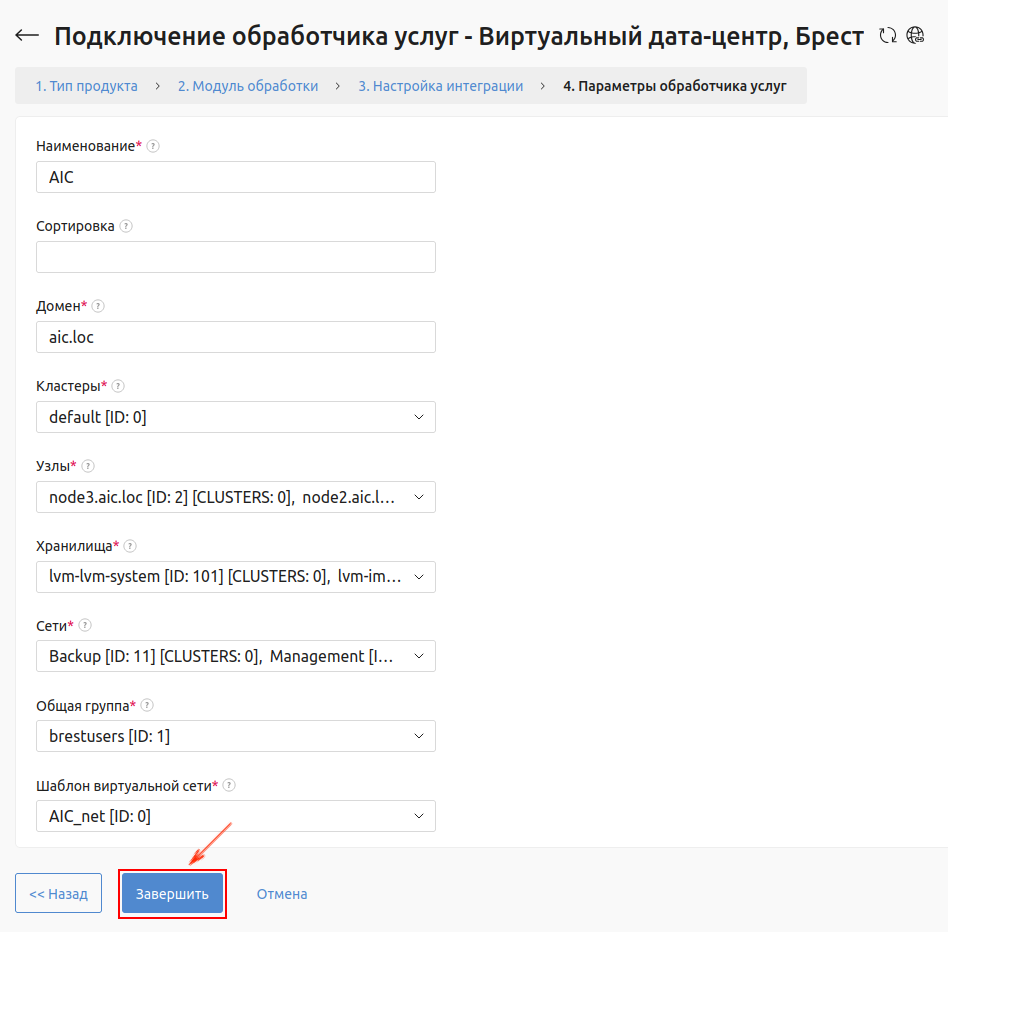

В открывшемся окне Параметры обработчика услуг:

В поле Наименование задать наименование обработчика.

Поле Сортировка не обязательно к заполнению.

В поле Домен указать наименование текущего домена.

В полях Кластеры и Узлы в выпадающем списке выбрать Выделить все.

В поле Хранилища в выпадающем списке выбрать два ранее созданных хранилища.

Предупреждение

Использование системных хранилищ с ID

1,2не допускается.В поле Сети в выпадающем списке выбрать созданную ранее виртуальную сеть ПК СВ.

7 В поле Общая группа в выпадающем списке выбрать группу brestadmins.

В поле Шаблон виртуальной сети выбрать шаблон, на основании которого будут создаваться сети в рамках данной интеграции.

Нажать на кнопку Завершить:

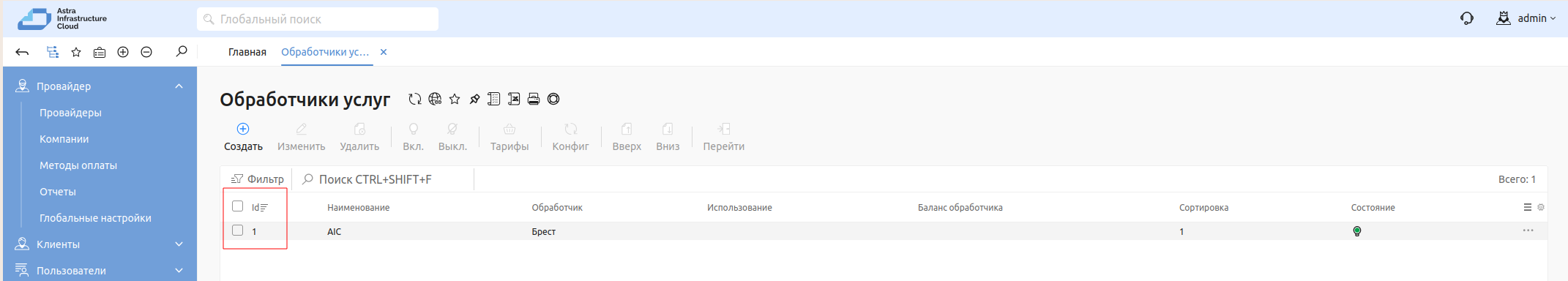

Скопировать ID обработчика из списка обработчиков после его создания. Данный идентификатор потребуется для запуска автоматизации подсистемы мониторинга:

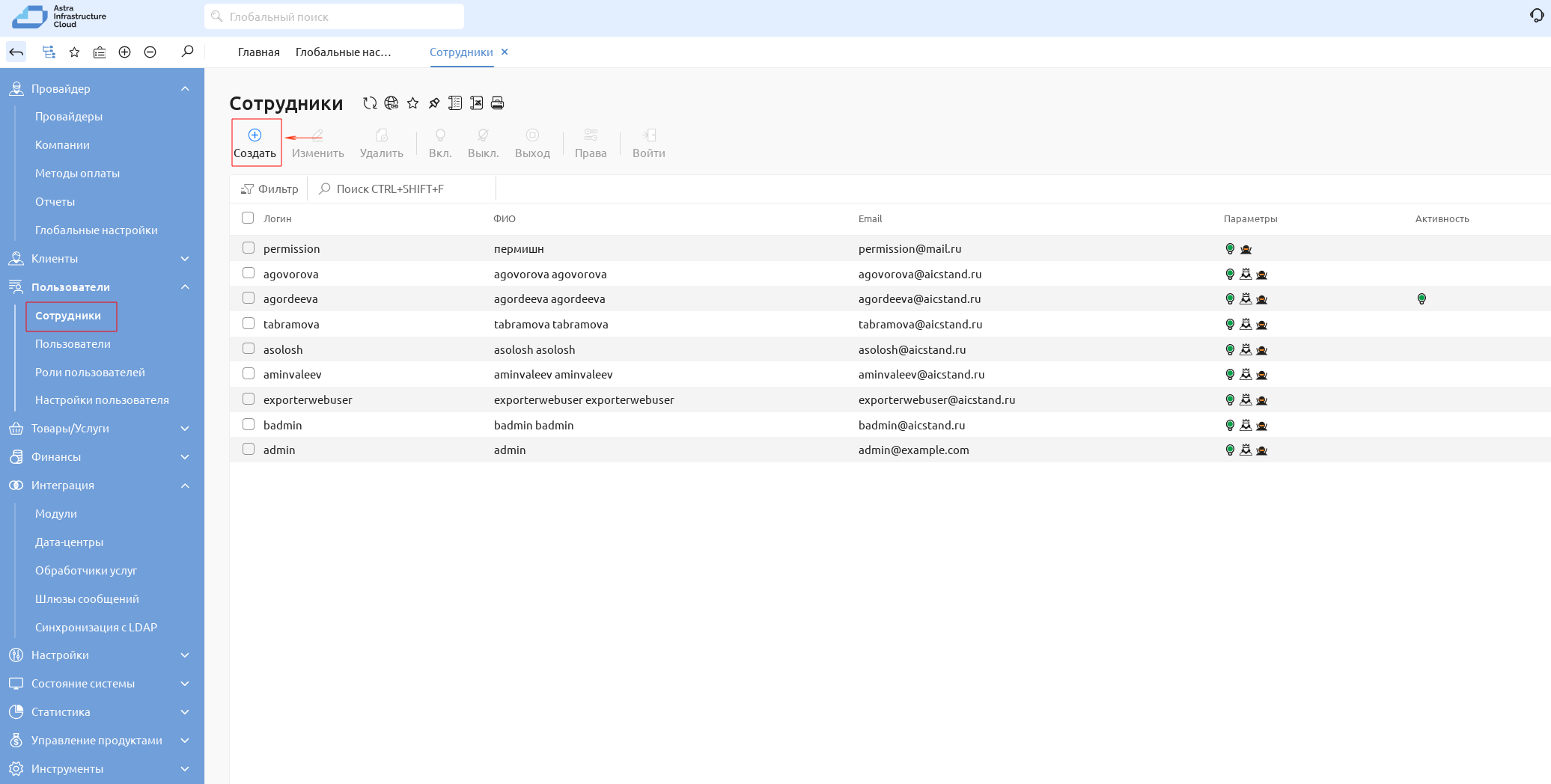

Создать пользователя для подсистемы мониторинга. Для этого:

На Портале самообслуживания перейти во вкладку Пользователи — Сотрудники основного меню слева и нажать на :кнопку Создать:

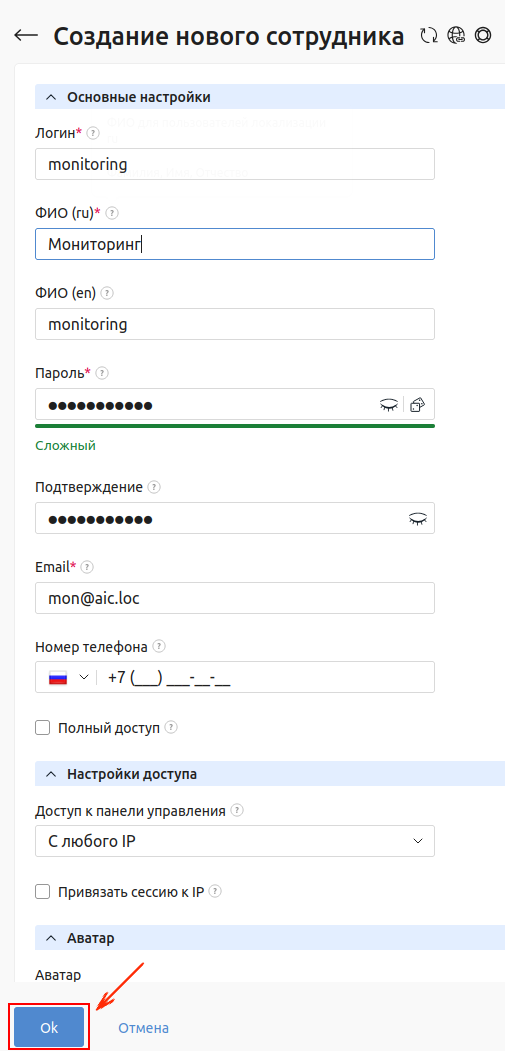

В открывшемся окне Создание нового сотрудника:

В полях Логин, ФИО (ru) и Пароль ввести учетные данные Пользователя, заданного ранее в блоке Мастера установки – Astra Monitoring;

В поле Email указать адрес электронной почты;

В поле Полный доступ поставить флаг;

Нажать на кнопку Ок:

Авторизовать токен мониторинга для СРК, выполнив следующие действия:

Скопировать из журнала автоматизации или из файла

/home/astra/api-tokensна сервере СРК автоматически сгенерированный CSRF-токен.Пример содержания файла с токеном CSRF:

astra@rubackup-server:~$ cat /home/astra/api-tokens # BEGIN ANSIBLE MANAGED BLOCK csrf_token: 2904dcc7-7749-4a81-b860-2cbf08162dad # END ANSIBLE MANAGED BLOCK

Для корректного сбора метрик подсистемой мониторинга, полученный CSRF-токен REST API необходимо авторизовать. Для этого в веб-браузере ВМ с СРК нужно перейти по адресу:

https://api.rubackup.local:5656/api/v1

В верхнем правом углу открывшегося окна нажать на кнопку Authorize:

Ввести полученный в выводе CSRF-токен.

При перезагрузке RuBackup сервера, либо службы

rubackup_server.service, токен для REST API нужно генерировать и авторизовать заново. Для выполнения генерации нового токена, без необходимости запускать весь процесс развертывания заново, на Bootstrap сервере в папке/home/astra/aic-codeвыполнить команду:task rubackup_token

После завершения процесса создания пользователя, выполнить повторный запуск Мастера Установки.

В блоке Astra Monitoring окна Ключевые компоненты скорректировать поля Имя пользователя API BILLmanager, Пароль пользователя API BILLmanager и ID обработчика BILLmanager, указав данные, полученные на предыдущем шаге:

Остальные переменные необходимо оставить без изменений.

Примечание

Для сбора метрик в ПК СВ, в процессе развертывания в FreeIPA будет создан специальный сервисный пользователь Astra Monitoring.

Клиентами Astra Monitoring являются серверы КД, серверы управления и виртуализации ПК СВ, сервер RuBackup. На каждого клиента AM будет установлен отдельный экспортер, позволяющий собирать нужные логи.

В списке этапов установки отметить четыре следующих этапа: от Инсталляция Astra Monitoring до Инсталляция Market Place (в случае если установка DCImanager не планируется). Нажать на кнопку Установить:

Примечание

Если развертывание DCImanager планируется, на этом шаге необходимо дополнительно установить флаг на этапе Инсталляция DCImanager до этапа получение лицензии. Этап инсталляции DCImanager после добавления лицензии запускается отдельно.

Если установка DCImanager не планируется, на этом установку компонентов AIC следует завершить.

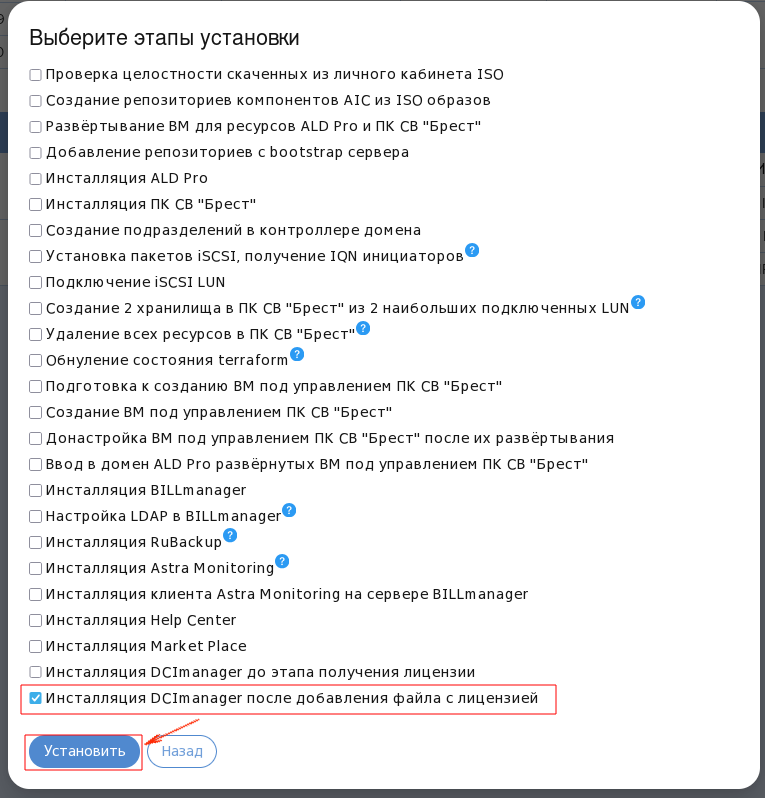

Запуск финального этапа установки (при развертывании DCImanager)#

Если на предыдущем шаге была произведена Инсталляция DCImanager до этапа получения лицензии, после завершения работы автоматизации необходимо перейти во вкладку Журнал установки и найти выведенный уникальный отпечаток установки для получения лицензии DCImanager.

Пример отпечатка установки:

"fingerprint": "H4sIAAAAAAAA/zXOQW4CMQwF0LtkzSKOHSfmMiM7iUsFGiqGoaoQd2+k0qX1v973M7T9dhvrfXnoZR9bOD5fh3DS7RSOoQA36uauXsgEFHKl1kVjRayJ3YblVEA55jokKo8ZFQVps5klHMI6vpfz+JlYNG/MKqTNtD QHduzoGUr3VrEy1titI8eeTN2YKWESAGGrDm1i10t/Y/PYPj/W5f1oHAiIXVpOqAlAMxcTBkmpapEYaxwmRNlToUxAUJ27NiJNRbRM7n49j/VP3r+63sf/0usXmbnIRCMBAAA="

Далее необходимо в личном кабинете ISPsystem запросить лицензию для DCImanager. Полученный ответ разместить в файле по пути:

'/home/astra/aic-code/ansible/roles/dci_manager/after_license/files, создав файл с именемdci_license.Примечание

В этом файле должен быть только текст полученной лицензии, в нем не должно быть пустых строк или лишних символов.

После получения лицензии DCImanager, выполнить финальный запуск Мастера Установки, выбрав в этапах установки последний пункт: Инсталляция DCImanager после добавления файла с лицензией. Нажать на кнопку Установить:

После завершения работы Мастера установки, перейти к настройке DCImanager. Для этого:

Открыть кабинет DCImanager по адресу:

https://IP_адрес_DCI

Авторизоваться, использовав для входа учетные данные, заданные при конфигурировании DCImanager.

с. Нажать на кнопку Войти:

На этом установка компонентов AIC будет завершена.

Проверка результатов установки#

Результаты работы Мастера установки на всех этапах можно просматривать используя вкладку Журнал установки в основном меню слева:

После завершения установки AIC результаты установки компонентов можно проверить следующим образом:

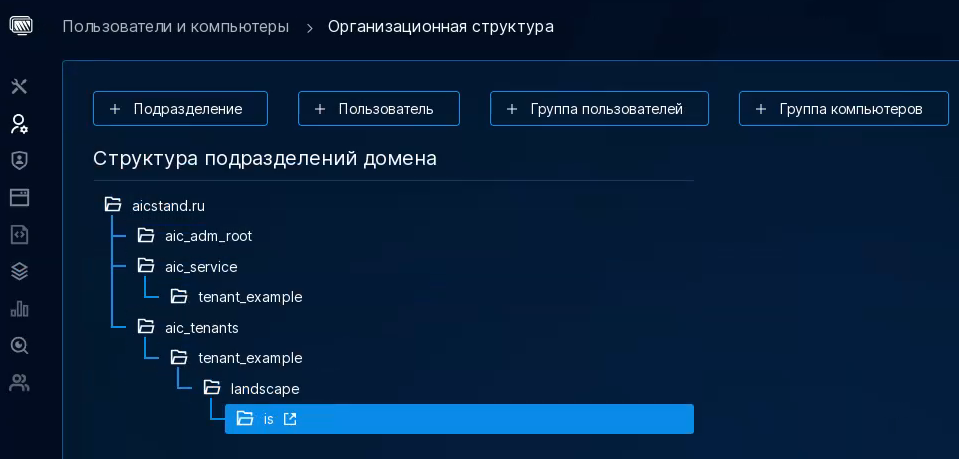

Проверка установки КД ALD Pro.

После успешного развертывания КД, следует перейти в веб-интерфейс ALD Pro, чтобы удостовериться, что все нужные серверы вошли в домен. Для этого:

в браузере одного из трех серверов, на которых были развернуты ВМ, перейти по адресу:

https://<IP_КД>

Где

<IP_КД>— IP-адрес созданного контроллера домена (в данном примере:https://dc1-test.aicstand.ru) .авторизоваться под учетной записью администратора КД;

для проверки создания организационной структуры домена выбрать пункт меню слева: Пользователи и компьютеры — Организационная структура. Структура должна иметь следующий вид:

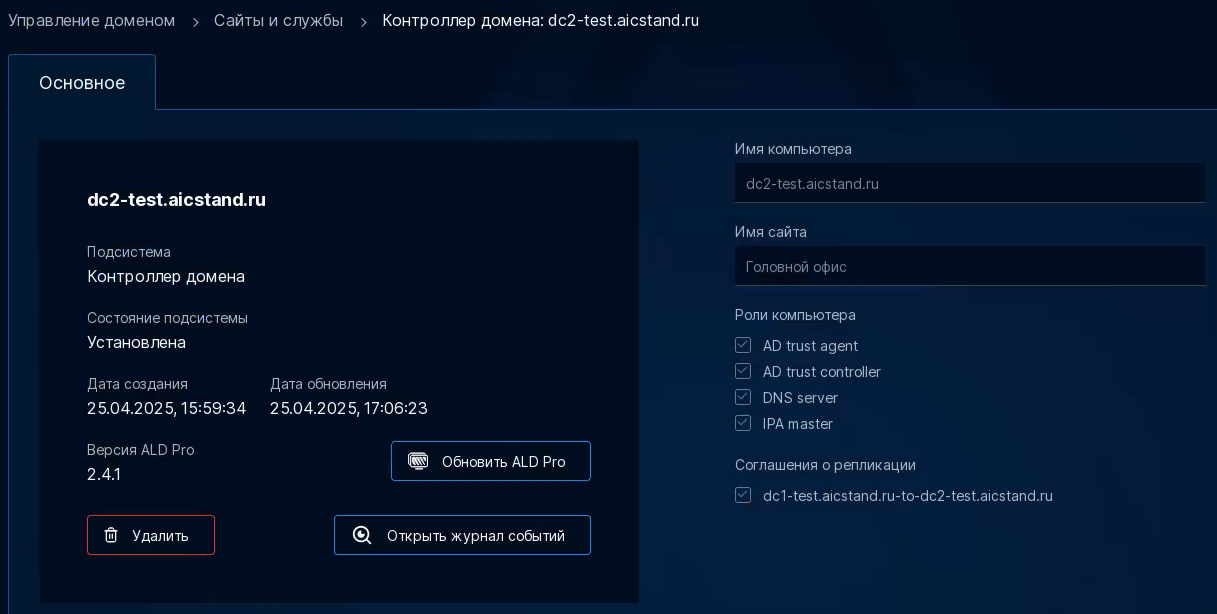

для проверки корректности инициализации реплик КД, в веб-интерфейсе реплики ALD Pro по адресу

https://<IP_реплики_КД>, перейти во вкладку основного меню слева Управление доменом — Сайты и службы. В этом окне отображаются все контроллеры домена. Для того, чтобы удостовериться в корректности инициализации реплик, поочередно выбрать каждую реплику из списка. Пример отображаемой информации:

важно обратить внимание на Роли компьютера. Если сервер пока не стал репликой, у него будут отсутствовать роли, не будет никаких соглашений о репликации, а также в пункте Версия ALD Pro вместо версии будет отображаться значение Неизвестно. Репликация занимает от 30 до 240 минут.

Проверка работы подсистемы мониторинга Astra Monitoring.

перейти в веб-интерфейс Astra Monitoring по адресу:

<IP_адрес_AM>;войти в веб-интерфейс Astra Monitoring (логин и пароль по умолчанию

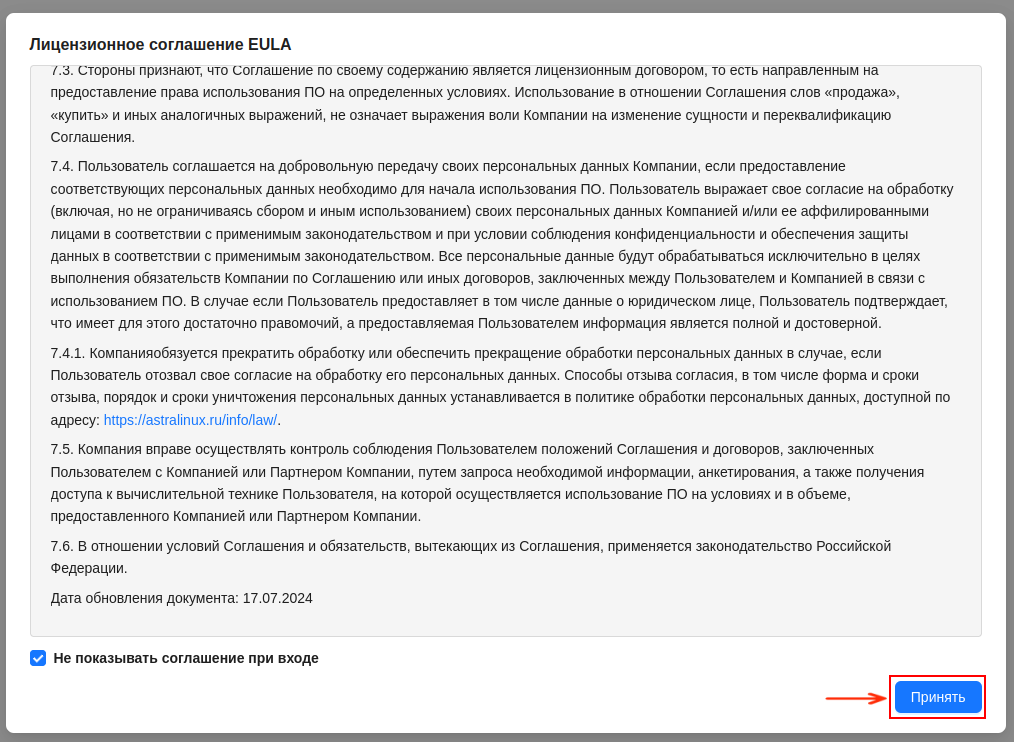

admin-internal/adminможет быть изменен после развертывания);перейти по адресу:

<IP_адрес_AM>:3000, для доступа к сервису визуализации собираемой информацииGrafana;войти в сервис

Grafana(логин и пароль по умолчаниюadmin/passwordможет быть изменен после развертывания);при первом входе принять условия Лицензионного соглашения, нажав на кнопку Принять в правом нижнем углу экрана:

Предупреждение

Системное время на сервере, с которого осуществляется вход на портал Grafana, должно совпадать со временем на серверах контроллера домена.

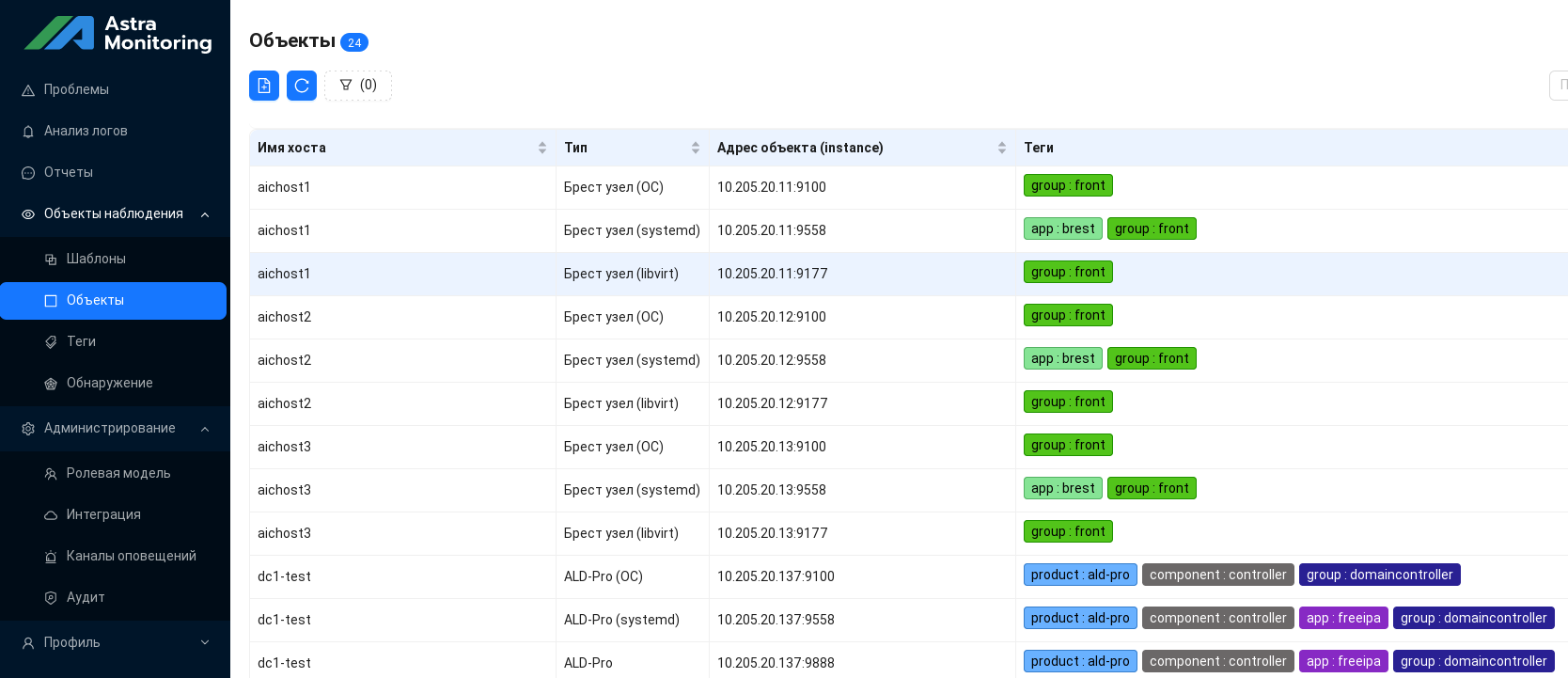

перейти в раздел Объекты наблюдения — Объекты.

Пример вида меню Объекты:

Проверка работы СРК RuBackup.

Для проверки работы подсистемы резервного копирования:

войти в Портал Администратора;

выбрать в списке ВМ компоненты СРК;

перейти в графическую консоль ВМ;

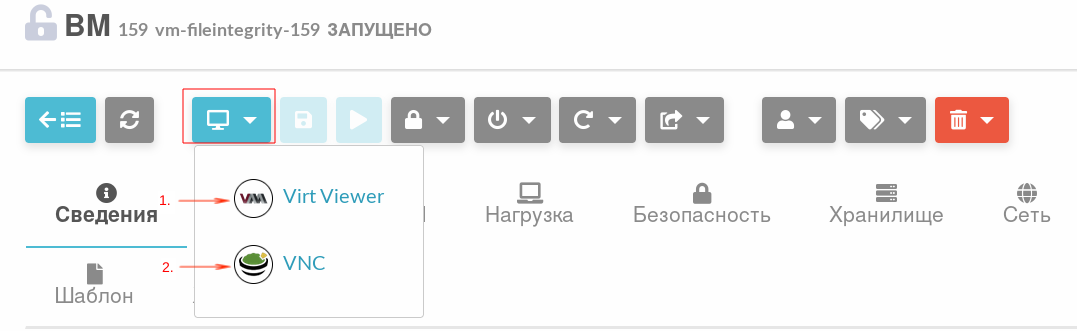

Примечание

Для подключения к удаленному столу ВМ рекомендуется использовать внешний клиент либо VNC-подключение. Для установки внешнего клиента выполнить команду:

sudo apt install virt-viewer

Далее на Портале Администратора загрузить файл для ПО Virt Viewer либо выбрать подключение к консоли VNC через веб-браузер:

При подключении с использованием ПО Virt Viewer, открыть скаченный файл командой:

remote-viewer <имя_скаченного_файла>.vvв графической консоли выполнить команду:

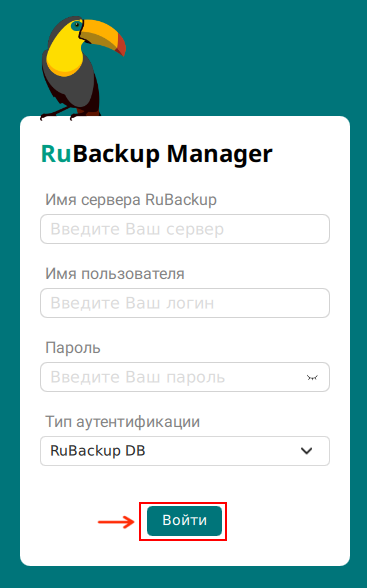

rbm

в открывшемся окне для входа в систему указать Имя сервера RuBackup (можно использовать

localhostлибо IP-адрес самой ВМ) и учетные данные Пользователя, заданные при настройке Подсистемы резервного копирования в Мастере установки. Тип аутентификации оставить по умолчанию. Нажать на кнопку Войти;

после входа в систему необходимо удостовериться, что все клиенты СРК авторизованы, находятся в сети, распределены по группам. В разделе Глобальное расписание созданы расписания для создания РК каталогов и файлов, содержащих конфигурационные файлы AIC.

Проверка работы компонента HelpCenter.

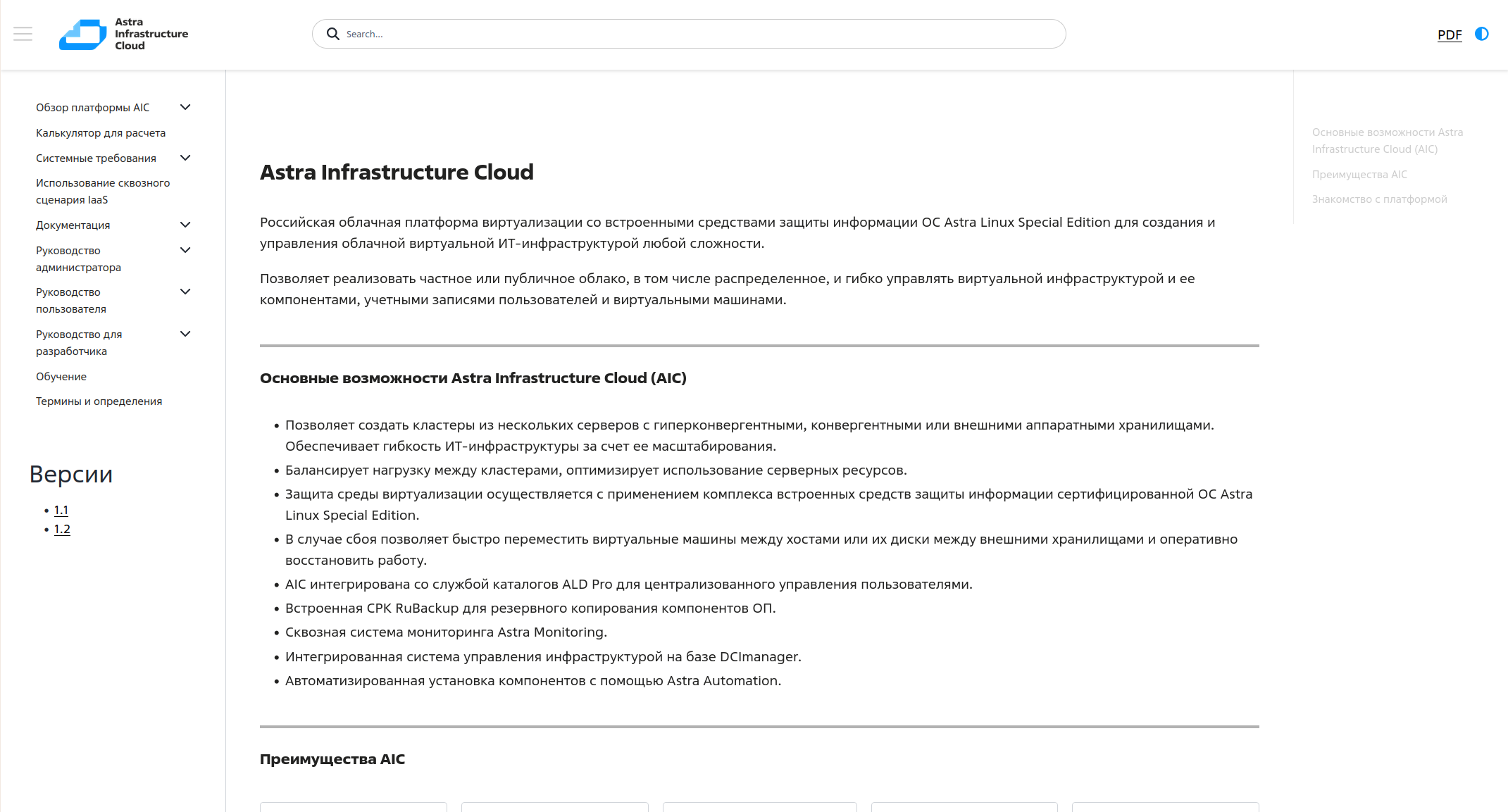

Компонент HelpСenter представляет собой веб-версию документации ОП АИК. Он включает архитектурные описания, руководства для пользователей и администраторов, а также встроенный калькулятор, позволяющий рассчитать необходимое количество процессорных ядер и объем оперативной памяти для серверов виртуализации ПК СВ с учетом планируемой нагрузки.

Для проверки Подсистемы справочного центра необходимо перейти по ссылке в журнале логов, либо по IP-адресу (http://<IP_адрес_helpceneter>) или доменному имени ВМ. В случае успешной установки откроется интерфейс справочного центра:

Основные разделы веб-документации доступны через навигационное меню слева. В нижней части панели предусмотрен выбор версии платформы AIC, в соответствии с которой отображается актуальное содержание справочного центра.

Калькулятор для расчета нужного количества ядер и оперативной памяти для серверов виртуализации ПК СВ представлен в виде

.xlsxфайла.Примечание

Для открытия калькулятора необходимо установить пакет

libreoffice, выполнив команду:sudo apt install -y libreoffice

После выполнения команды файл будет корректно открываться в

Libreoffice. Калькулятор представляет собой набор таблиц с возможностью расчета количества серверов виртуализации в зависимости от планируемой нагрузки.

Рекомендуемые действия после установки#

Одним из постустановочных действий является добавления в директории /root на трех серверах управления ПК СВ скрипта backup_db.sh, который выполняет резервное копирование базы данных кластера, при условии, что текущий сервер является лидером кластера управления ПК СВ. Резервная копия базы данных помещается в каталог /backup, расположенный на этих же серверах. Также скрипт ротирует резервные копии, с периодичностью в 15 дней. Выполнение скрипта добавляется в таблицу планировщика задач cron, с периодичностью запуска скрипта каждый день, в 00:05.

Устранение ошибок при отработке мастера установки#

Ошибки при создании Сервисных ВМ#

В случае возникновения ошибок на шаге создания сервисных ВМ, необходимо:

подключиться к целевому серверу, используя пакет

virt-managerили команду:visrh

удалить ВМ и ее диск. Диски ВМ расположены в директории:

/var/lib/libvirt/images;после удаления ВМ и дисков перезапустить автоматизацию.

Ошибки при работе с BREST_LVM#

В случае возникновения ошибок при настройке BREST_LVM и/или при возникновении необходимости удалить существующие LUN и пересоздать их с другими параметрами для хранилищ типа BREST_LVM, простое удаление компонентов LVM не является корректным методом.

Так как хранилища типа BREST_LVM используют кластерную блокировку SAN-Lock, очистка LUN должна быть разделена на 2 этапа:

удаление групп томов;

удаление физических томов.

Перед началом процесса удаления компонентов LVM необходимо выполнить следующие шаги:

в веб-интерфейсе ПК СВ удалить существующие хранилища. Для этого нужно перейти в раздел Хранилища основного меню слева, выбрать оба созданных ранее хранилища, после чего нажать на кнопку Удалить;

удостовериться, что на всех серверах, входящих в Кластер Brest_LVM, включена кластерная блокировка, то есть в файле

/etc/lvm/lvm.confу переменнойuse_lvmlockdустановлено значение 1.

Примечание

Все действия выполняются под учетной записью пользователя root.

Для удаления структуры Brest_LVM выполнить следующие действия:

Для получения информации об используемых хранилищами групп томов и физических томов, на сервере лидере RAFT выполнить команду:

pvs:

Пример вывода после выполнения команды:

<pre class="western"><span style="color: rgb(255,0,0);">root@node1-test:~# pvs PV VG Fmt Attr PSize PFree /dev/sda vg-one-100 lvm2 a-- <499,97g 499,97g /dev/sdb vg-one-101 lvm2 a-- <199,97g 199,97g</span></pre>

Где:

</dev/sda>и</dev/sdb>— имена блочных устройств, используемых в физических томах;<vg-one-100>— имя группы томов для хранилища с ID 100 на физическом томе/dev/sda;<vg-one-101>— имя группы томов для хранилища с ID 101 на физическом томе/dev/sdb.Для остановки работы системы блокировок LVM, на всех серверах, входящих в Кластер Brest_LVM, кроме текущего лидера RAFT, выполнить команду:

root@node2...3-test:~# vgchange --lockstop

На лидере RAFT для удаления групп томов, используемых хранилищами ПК СВ, выполнить команды:

root@node1-test:~# vgremove vg-one-100 root@node1-test:~# vgremove vg-one-101

Перед удалением физических томов на лидере RAFT выполнить команду:

root@node1-test:~# systemctl stop sanlock.service lvmlockd.service

Выключить кластерную блокировку. Для этого в файле

/etc/lvm/lvm.confнайти строкуuse_lvmlockd = 1и поменять значение 1 на 0. После чего можно удалять оба физических тома:root@node1-test:~# pvremove /dev/sda root@node1-test:~# pvremove /dev/sdb

Выполнение этих команд очистит компоненты LVM от созданных автоматизацией хранилищ. Для пересоздания хранилищ достаточно в директории /home/astra/aic-code выполнить команду:

iscsi_brest_lvm_datastore